Analizamos la NVIDIA RTX 4090, la tarjeta gráfica más potente del mundo

Llevábamos meses hablando sobre la nueva generación de tarjetas gráficas de NVIDIA, y hoy por fin están aquí. En este análisis os vamos a mostrar la que es, en la actualidad, la tarjeta gráfica para juegos más potente del mundo, la NVIDIA GeForce RTX 4090 que porta la nueva arquitectura Ada Lovelace, cargada de novedades y nuevas tecnologías como DLSS 3.0.

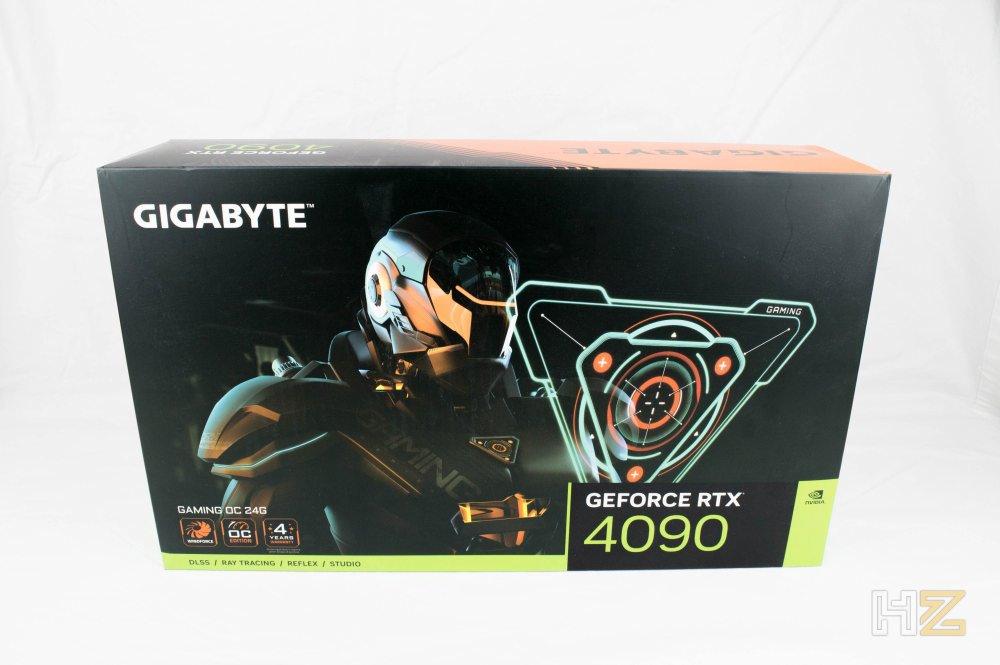

Aunque en el día de ayer ya pudimos ver algunos análisis del modelo Founders Edition de NVIDIA, no es hasta hoy que podemos mostraros por fin los modelos custom de esta nueva tarjeta gráfica, y es que en este caso el fabricante no nos ha mandado una gráfica propia sino un modelo personalizado por Gigabyte, concretamente el Gigabyte GeForce RTX 4090 Gaming OC 24G, que porta un disipador optimizado y unas frecuencias de funcionamiento ligeramente superiores.

NVIDIA RTX 4090, características técnicas

Como acabamos de mencionar, en nuestro poder tenemos una versión personalizada de Gigabyte, pero aun así salvo la velocidad de funcionamiento (que más tarde veremos el valor concreto), el hardware es idéntico al modelo de referencia. Por este motivo, en la siguiente tabla podéis encontrar las especificaciones técnicas completas tanto de la RTX 4090 como de la RTX 3090 Ti, que es el modelo que viene a sustituir en la familia de GPUs de NVIDIA.

| GeForce RTX 3090 Ti | GeForce RTX 4090 | |

|---|---|---|

| Proceso de fabricación | Samsung 8 nm | TSMC 4 nm |

| Transistores | 28.200 millones | 76.300 millones |

| Factor de forma | Triple slot | Triple slot |

| Salidas de vídeo | 3x DisplayPort 1x HDMI | 3x DisplayPort 1x HDMI |

| Conectores de alimentación | 1x16 pin (adaptador 3x8 pines) | 1x16 pin (adaptador 4x8 pines) |

| Clústers gráficos / procesador de texturas | 7 / 42 | 11 / 64 |

| SM | 84 | 128 |

| Núcleos CUDA | 10.752 | 16.384 |

| Tensor Cores | 336 (3ª Gen) | 512 (4ª Gen) |

| RT Cores | 84 (2ª Gen) | 128 (3ª Gen) |

| Texture Units | 336 | 512 |

| ROPs | 112 | 176 |

| Velocidad (Boost) | 1860 MHz | 2520 MHz |

| Velocidad de la memoria | 10.500 MHz | 10.501 MHz |

| Data Rate de la memoria | 21 Gbps | 21 Gbps |

| Caché L2 | 6144 KB | 73728 KB |

| Memoria de vídeo total | 24 GB GDDR6X | 24 GB GDDR6X |

| Interfaz de memoria | 384 bit | 384 bit |

| Ancho de banda de la memoria | 1.008 GB/s | 1.008 GB/s |

| Texture Rate (bilinear) | 625 GT/s | 1290,2 GT/s |

| Fuente de alimentación recomendada | 850W | 850W |

| Total Graphics Power (TGP) | 450W | 450W |

| Temperatura máxima | 93ºC | 90ºC |

| Interfaz PCIe | 4.0 | 4.0 |

En seguida entraremos en detalle para hablar sobre la nueva arquitectura Ada Lovelace, pero para empezar aquí tenéis también el diagrama de bloques que ilustra las cifras que hemos puesto en la tabla. Podemos ver que la GPU AD102 de nueva generación incorpora, en su forma completa (ya que la RTX 4080 lleva una forma «capada»), un total de 12 Graphics Processing Clusters (GPCs), 72 Texture Processing Clusters (TPCs), 144 Streaming Multiprocessors (SMs), y una interfaz de memoria de 384-bit con 12 controladores de memoria de 32 bits.

Estamos como podemos apreciar ante una auténtica bestia, que según NVIDIA está diseñada ya no para gaming a resolución 4K, sino a mayores resoluciones como 8K. Por supuesto, NVIDIA también ha mejorado notablemente las capacidades de Ray Tracing en comparación con la generación actual, y de hecho esta GPU AD102 incorpora 18.432 núcleos CUDA, 144 RT Cores, 576 Tensor Cores y 576 Texture Units, mejorando además en una generación (lo cual incluye ciertas optimizaciones) a lo que teníamos en la serie RTX 30.

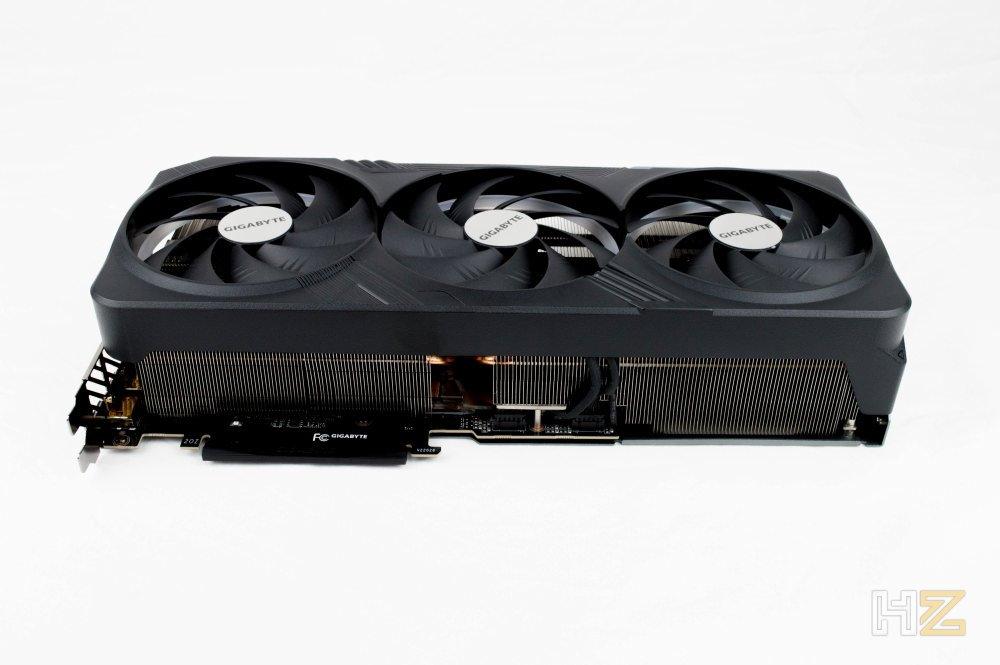

Uno de los temas más debatidos acerca de esta nueva generación de tarjetas gráficas es su tamaño, y es que son realmente enormes. El modelo personalizado de Gigabyte que NVIDIA nos ha enviado para este análisis mide nada más y nada menos que 35 centímetros de largo, 13,6 centímetros de profundidad en su parte más ancha, y 7,7 centímetros de ancho, ocupando completamente 3 slots.

Aunque Gigabyte no especifica el peso exacto de esta gráfica en el embalaje, la hemos pesado y estamos ante 2.170 gramos de tarjeta gráfica. Por supuesto, el fabricante incluye un bracket de soporte para poder aguantar el peso, un tipo de soporte que no utiliza el suelo de la caja para aguantar el peso sino que deberemos atornillarlo en uno de los soportes de la placa base (luego lo vemos en detalle), lo cual aliviará la presión sobre el zócalo PCIe de la placa y evitará que el PCB de la propia gráfica se doble.

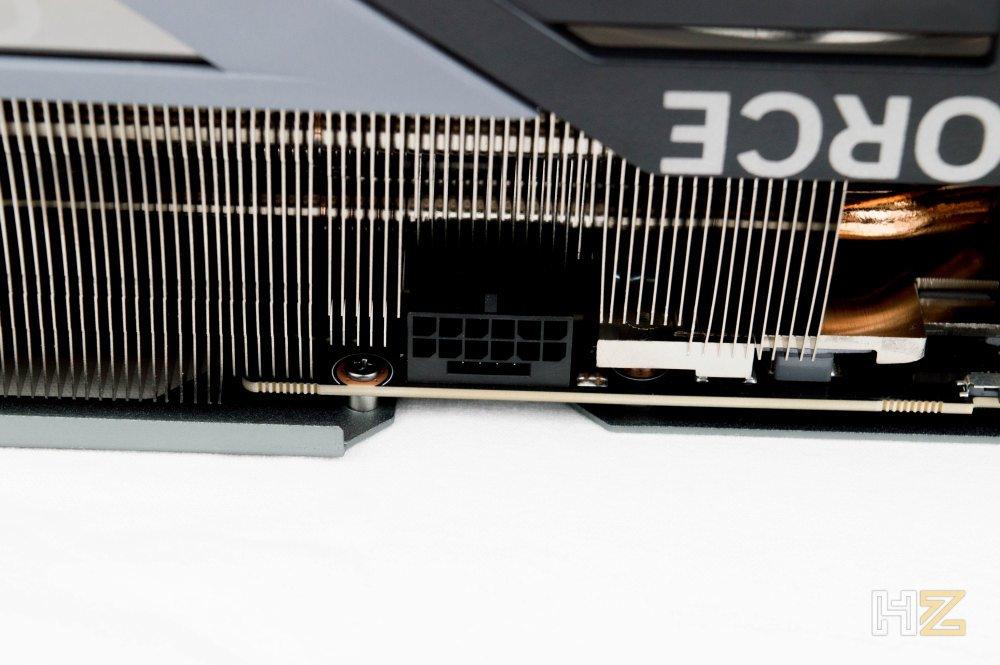

Otro tema controvertido es la alimentación; NVIDIA recomienda una fuente de alimentación de por lo menos 850W para dar servicio a esta tarjeta gráfica, a pesar de que su TGP es de 450 vatios. NVIDIA ha utilizado el nuevo conector de 16 pines que ya algunas fuentes incorporan, pero de todos modos lo curioso es el adaptador incluido en la gráfica, que pasa de ser de 3 conectores de 8 pines a 4, aumentando así la potencial potencia consumida.

Finalmente, el otro tema ampliamente debatido sobre esta nueva generación es el precio, y es que esta RTX 4090 tiene un PVPR de NVIDIA de nada menos que 1.959 Euros, si bien es cierto que estos modelos personalizados son algo más caros, y este modelo concreto de Gigabyte ya está listado en tiendas por 2.049,90 Euros. Efectivamente, estamos hablando de una tarjeta gráfica que ella sola cuesta más que un PC gaming de gama media-alta, así que vamos a ver si esto merece o no la pena.

¿Para qué quieres 24 GB de memoria?

Desde luego, 24 GB de VRAM dedicada parece una barbaridad para una tarjeta gráfica orientada al gaming, por mucho que NVIDIA diga que está pensada para jugar a resolución 8K… y efectivamente lo es. Sin embargo, para muchas cargas de trabajo en entornos creativos, el tamaño de la memoria de la gráfica influye directamente en los conjuntos de datos que se pueden visualizar y analizar al mismo tiempo, así que los 24 GB de memoria GDDR6X de la RTX 4090 no son exagerados en este caso (para gaming, desde luego parece que sí).

Esta enorme cantidad de VRAM permite a los creadores de contenido trabajar con grandes conjuntos de datos utilizando un gran número de materiales y texturas, así como flujos de trabajo que utilicen varias aplicaciones de uso intensivo de la GPU sin preocuparse por quedarse sin memoria o sufrir ralentizaciones.

Para el renderizado de la GPU, la memoria es especialmente importante, ya que las escenas 3D que son más grandes que la memoria disponible necesitan reducir su complejidad utilizando datos de texturas de menor resolución o reduciendo la fidelidad de las mallas. Otra posibilidad es dividir una escena en elementos separados que se renderizan también por separado y luego se vuelven a componer, lo cual requiere trabajo adicional y afecta a la productividad.

Por lo tanto, un mayor tamaño de la memoria de vídeo reduce la necesidad de hacer este tipo de concesiones, ya que permite a los usuarios trabajar y renderizar escenas de mayor tamaño en tiempo real. Eso sí, como hemos mencionado antes, para gaming no tiene demasiado sentido en realidad.

La revolución de la tecnología DLSS 3.0

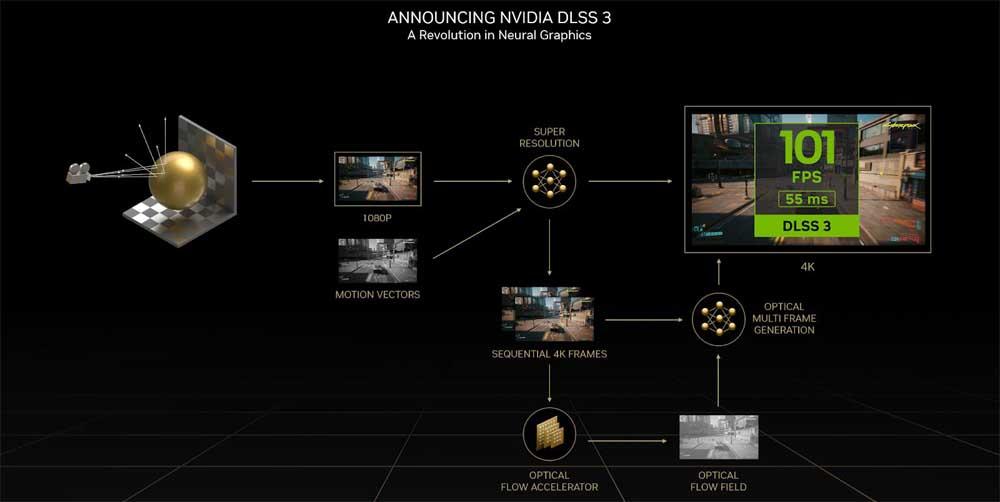

Cuando se presentó por primera vez la tecnología NVIDIA DLSS, ya supuso una interesante perspectiva para mejorar el rendimiento en juegos, ya que se renderizaban menos píxeles utilizando una IA para construir imágenes a mayor resolución, liberando de carga a la GPU. Menos de dos años después llegó la versión 2.0 de esta tecnología, mejorando todavía más la calidad y el rendimiento a través de una red neural que podía adaptarse a todos los juegos sin necesidad del famoso entrenamiento que necesitan las IA. DLSS 2.0 está ya disponible en 216 juegos compatibles, pero NVIDIA no ha querido esperar y ya está entre nosotros la versión 3.0 de la tecnología DLSS.

DLSS 3 es un avance revolucionario en los gráficos impulsados por la IA que aumenta mucho más el rendimiento, manteniendo una buena calidad de imagen y capacidad de respuesta. DLSS 3 añade generación óptica de fotogramas múltiples a la base de DLSS para generar fotogramas completamente nuevos, e integra además la tecnología de baja latencia NVIDIA Reflex para mejorar la capacidad de respuesta. DLSS 3 está impulsado por los nuevos Tensor Cores de 4ª generación y el acelerador de flujo óptico de la arquitectura Ada Lovelace, así que solo es compatible con gráficas NVIDIA RTX 40 Series.

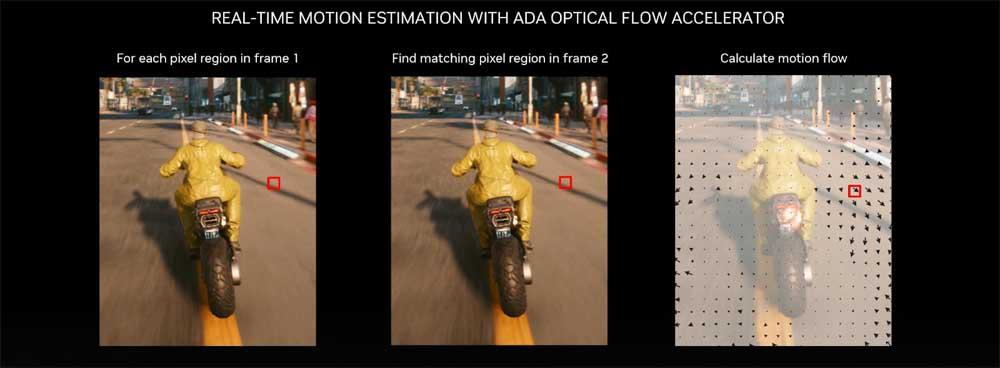

Ese «acelerador de flujo óptico» del que os hablamos, analiza dos fotogramas secuenciales del juego y calcula un campo de flujo óptico entre ellos, capturando la velocidad y dirección a la que se mueven los píxeles del fotograma 1 al 2 a la vez que captura información a nivel de píxel, como partículas, reflejos, sombras e iluminación que normalmente no se incluyen en los cálculos del vector de movimiento del motor de los juegos.

Podéis verlo en el siguiente ejemplo, en el que se representa el flujo de movimiento del escenario con respecto a la motocicleta. Con esta tecnología, podemos decir que la IA prevé hacia dónde se van a mover los píxeles para generar los fotogramas siguientes en consonancia.

DLSS 3 también incorpora la tecnología NVIDIA Reflex, que sincroniza la GPU y la CPU para garantizar una óptima capacidad de respuesta en el menor tiempo posible. Esto hace que los controles en los juegos respondan mejor y garantizan que las acciones en pantalla se muestren de forma casi instantánea. Según NVIDIA, en comparación con no utilizar esta tecnología, DLSS 3 es capaz de reducir la latencia a la mitad en el mejor de los casos.

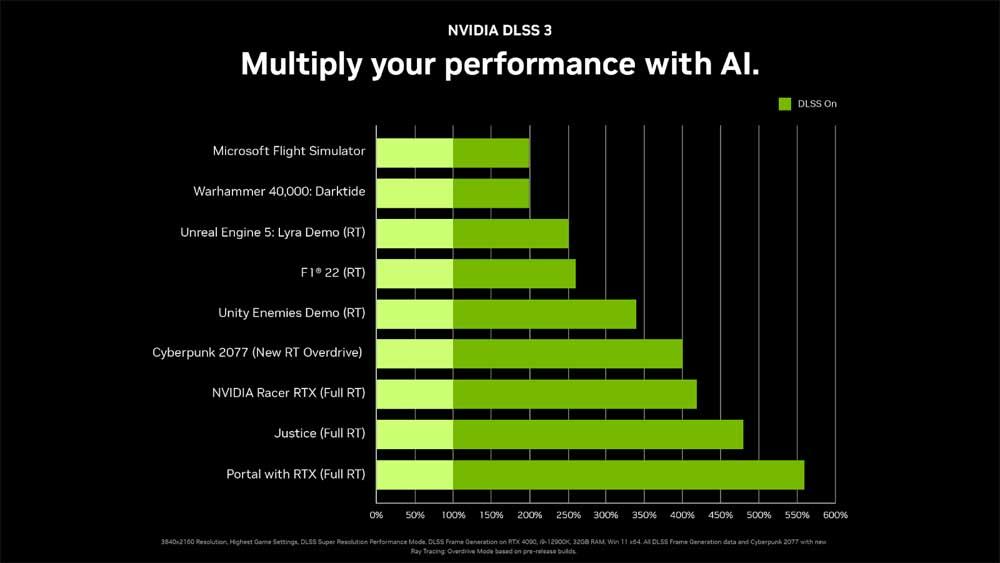

No vamos a entrar a hablaros del funcionamiento de DLSS 3 en profundidad en este análisis porque sería extremadamente extenso (podéis contar con que haremos un artículo aparte para ello), pero el dato con el que tenemos que quedarnos es que según el fabricante, es capaz de multiplicar el rendimiento por 4.

La arquitectura Ada Lovelace

Con sus revolucionarios RT y Tensor Cores, la arquitectura Turing sentó las bases de una nueva era en el campo de los gráficos para PC, que incluye por supuesto el trazado de rayos en tiempo real y los gráficos basados en IA. El renovado SM de Ampere, los núcleos RT y Tensor Cores mejorados y el nuevo subsistema de memoria GDDR6X establecieron el puente entre los gráficos tradicionales basados en la rasterización, y los gráficos con trazado de rayos, acelerando ambos y proporcionando enormes ganancias de rendimiento a resoluciones de pantalla cada vez más altas.

El lanzamiento de la nueva arquitectura de GPU, Ada Lovelace, supone un nuevo avance para los gráficos 3D, ya que ha sido concebida para proporcionar un rendimiento todavía mayor en Ray Tracing y los gráficos neuronales basados en IA. Es posible mejorar el rendimiento entre 2 y 4 veces (gracias a DLSS 3.0) con respecto a las GPU Ampere de generación anterior, marcando un punto de inflexión en el que el trazado de rayos y los gráficos neuronales se convierten en la corriente principal.

En esta nueva arquitectura Ada Lovelace, la GPU AD102 es el buque insignia, y se lanza con esta RTX 4090 que analizamos hoy. NVIDIA también proporcionará pronto detalles sobre las GPUs AD103 y AD104, que utilizan la misma arquitectura básica que esta GPU.

Os presentamos a la NVIDIA GeForce RTX 4090

Tal y como era de esperar, el embalaje de esta tarjeta gráfica es de un tamaño y peso considerables. Como el modelo que nos han enviado es el personalizado por Gigabyte, lógicamente tiene los colores y adornos habituales de la marca, en este caso destacando el modelo en la parte frontal junto con algunas de sus principales características, como el hecho de que es el modelo Gaming OC 24G, que tiene DLSS, Ray Tracing, Reflex y NVIDIA Studio, o que equipa el disipador WindForce y tiene 4 años de garantía.

En la parte opuesta, el fabricante nos explica brevemente el funcionamiento del disipador, indicándonos que sus tres ventiladores giran en sentidos alternos para maximizar la refrigeración o que el disipador está sobredimensionado para garantizar una buena temperatura. Abajo también se indican sus principales características y sus salidas de vídeo.

Quitamos la cubierta de cartón blando exterior y accedemos a una caja negra de cartón rígido solo adornada con el logo de Gigabyte en la parte exterior. Por dentro, amplias protecciones de poliestireno expandido y una pequeña caja que contiene el manual de instrucciones, tanto de la gráfica como del bracket de instalación que en breve veremos.

Dentro encontramos muchas cosas para tratarse de una simple tarjeta gráfica, que generalmente no traen nada salvo el producto en sí. Por supuesto, también tenemos la gráfica en un plástico antiestático, pero como siempre la vamos a dejar para el final y vamos a ver primero qué accesorios incluye.

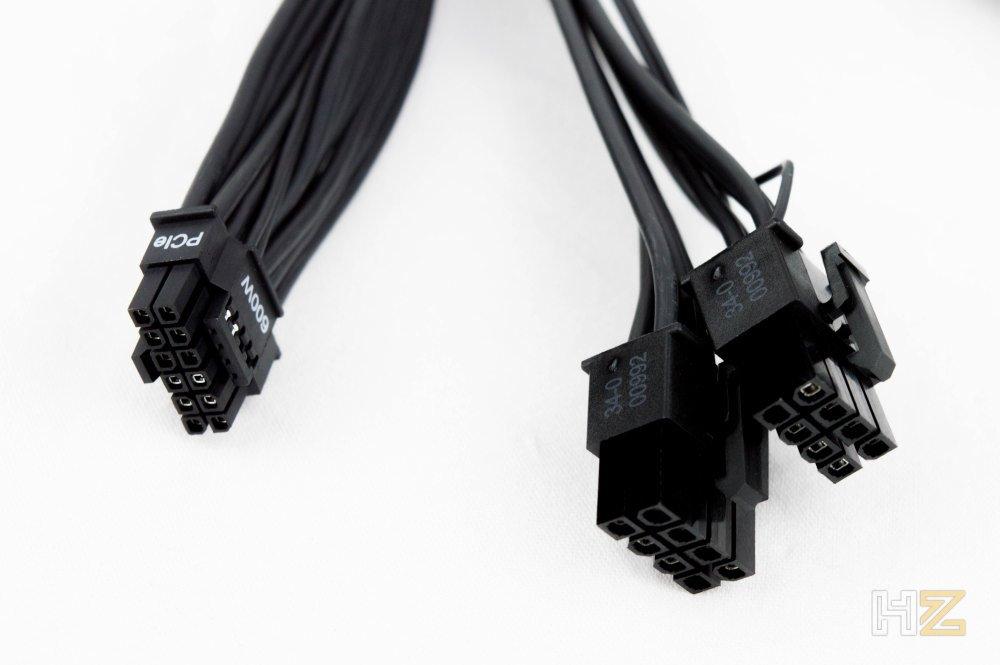

Comenzamos por el adaptador de 4 conectores de 8 pines de la fuente al conector de 16 pines y 600W que utiliza esta generación de gráficas. La verdad es que es un accesorio bastante tosco y que provocará que tengamos que dejar los conectores al aire y en medio de la caja.

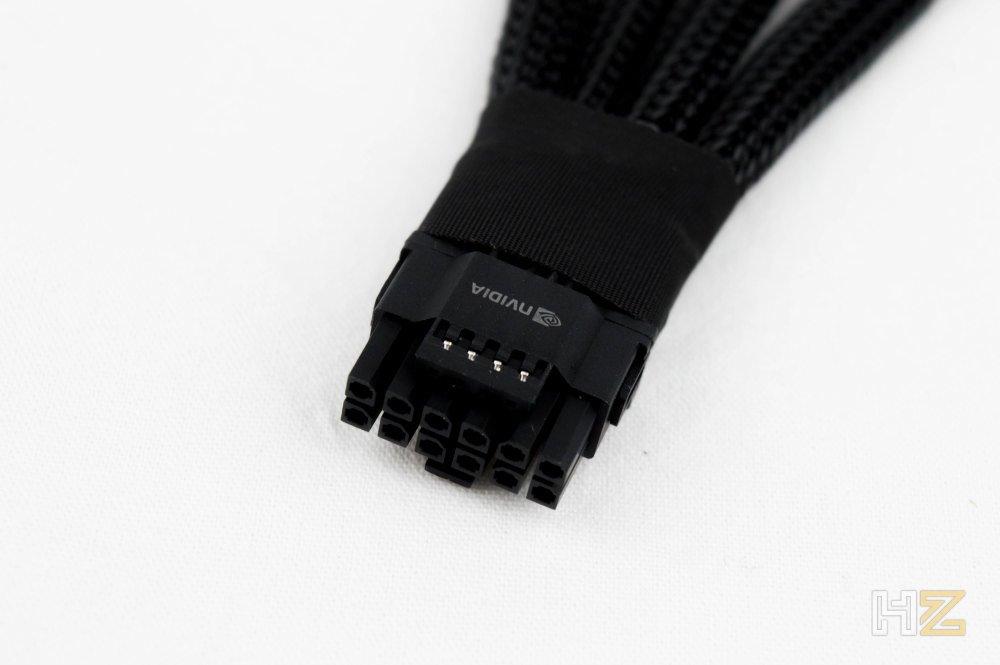

Aquí podéis ver más de cerca el conector de 16 pines de NVIDIA.

Como en nuestro análisis vamos a utilizar una fuente de alimentación de CORSAIR, el propio fabricante ha tenido la amabilidad de enviarnos un cable (que estará incluido en sus nuevas fuentes) que convierte dos conectores de alimentación PCIe / EPS de la fuente en este conector de 16 pines para la gráfica, todo en un solo cable.

Como podéis apreciar, este cable es plano y de color negro, y tiene la misma longitud que los conectores habituales PCIe de las fuentes de la marca.

Por comodidad (ya que es mucho mejor usar dos conectores de la fuente y tener un solo cable que usar dos cables y tener los cuatro conectores empalmados al adaptador por ahí colgando), vamos a utilizar este cable nativo de CORSAIR en lugar del adaptador que viene con la tarjeta gráfica.

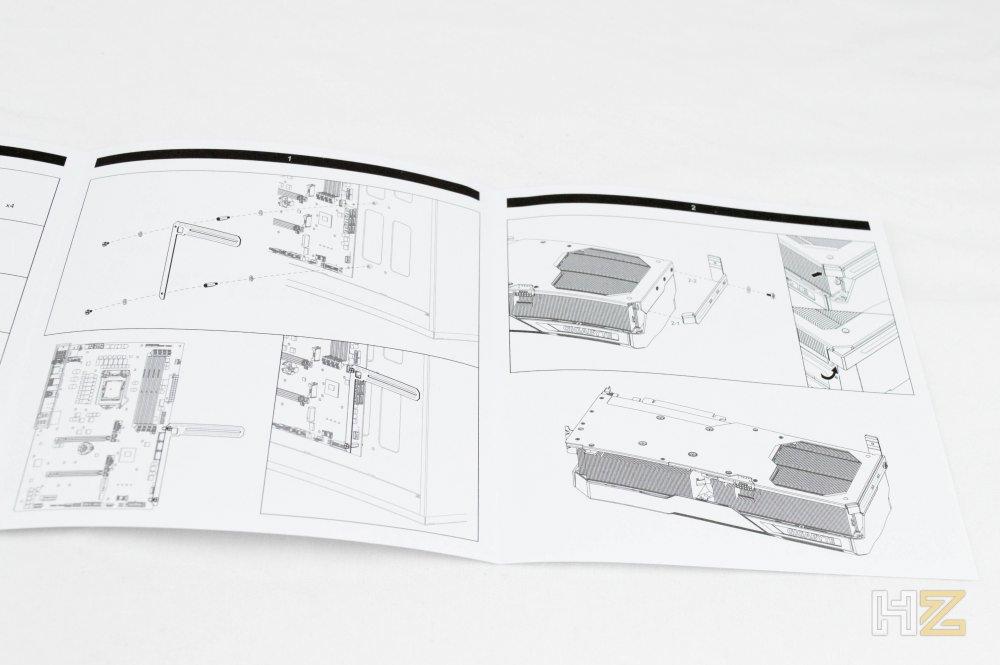

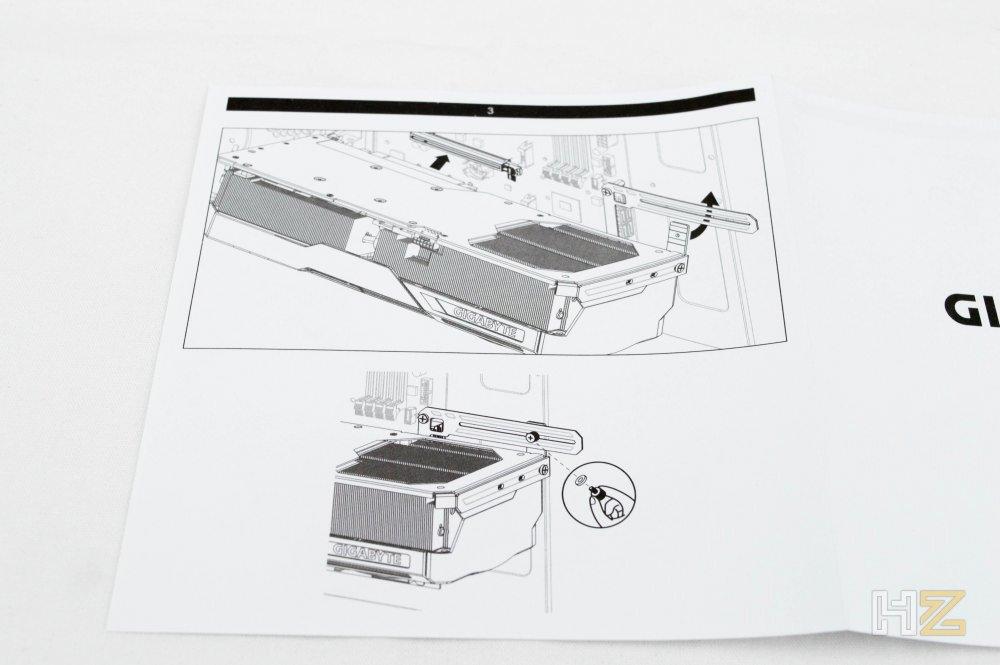

Tal y como os decíamos antes, debido el enorme tamaño y peso de la RTX 4090, es prácticamente imperativo utilizar un soporte que ayude a aliviar este peso, y Gigabyte lo incluye entre los accesorios de su RTX 4090. Además, en este caso, en lugar de ser un mero soporte que podremos ajustar y poner en el suelo de la caja, es un auténtico anclaje que atornillaremos literalmente a la tarjeta gráfica y a los tornillos de la placa base.

Tal y como podéis ver en el manual de instrucciones de instalación, este soporte deberemos atornillarlo a dos de los tornillos con los que la placa base se ancla a la caja del PC (viene con estos adaptadores y arandelas para ello). Luego tendremos que atornillar la otra parte a la tarjeta gráfica, y tras instalar ésta en el zócalo PCIe de la placa base (hay que hacerlo con verdadero cuidado para no cargarte nada), atornillaremos lo uno a lo otro.

Ahora sí, aquí tenéis la Gigabyte GeForce RTX 4090 Gaming OC 24G en una vista a tres cuartos que de entrada ya nos permite ver el enorme tamaño de sus ventiladores.

Desde luego, lo que destaca de esta tarjeta gráfica estéticamente hablando son sus grandes proporciones, puesto que no es solo que tenga tres ventiladores de 10 cm de diámetro sino también que es extremadamente gruesa.

Antaño, lo que ocupaban las tarjetas gráficas era justo el tamaño del embellecedor trasero, donde tenemos las salidas de vídeo, pero ahora fijaos que sobresale por todas partes, y no poco precisamente. Como podéis ver, esta gráfica tiene tres DisplayPort y un HDMI como salidas de vídeo, pero carece de USB-C.

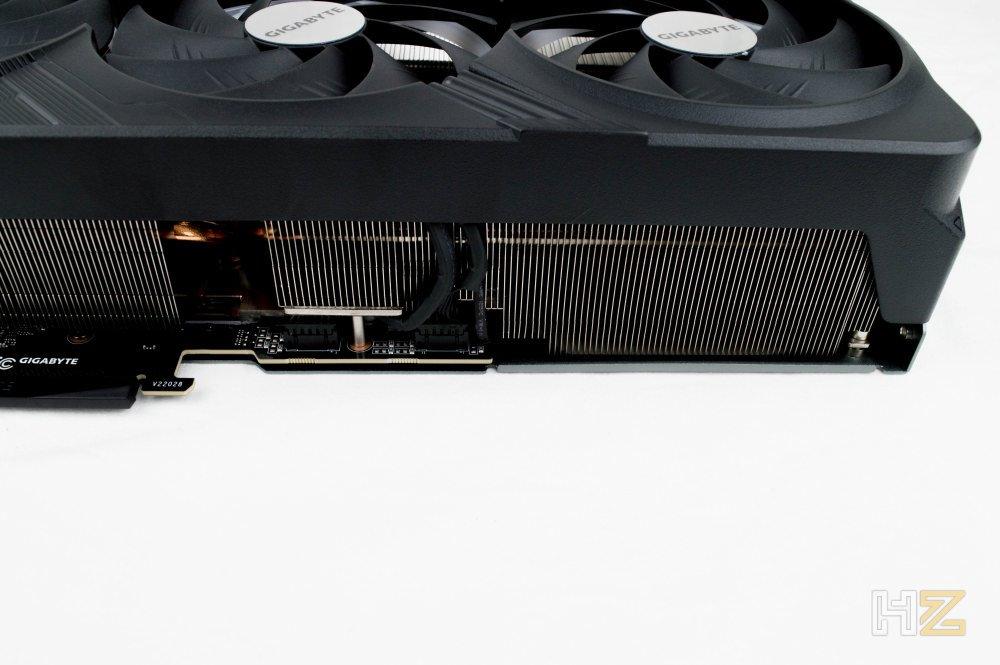

En la parte superior, que es la que se verá en una instalación tradicional en PC, tenemos a la vista los dos enormes bloques de láminas de aluminio del disipador, así como el logo GeForce RTX y por supuesto el de Gigabyte, que cuando esté el equipo encendido se iluminará con colores RGB.

Aquí, por cierto, podemos ver el conector hembra de alimentación de la gráfica.

La parte trasera está cerrada por el embellecedor del disipador, y podéis apreciar en la zona inferior la pieza metálica con tres perforaciones, que son precisamente para poder atornillar el bracket de sujeción que hemos visto antes.

Esta pieza metálica forma parte del backplate, que ocupa casi toda la superficie como ya es habitual y que ayudará a reforzar toda la estructura del dispositivo.

En esta zona podemos ver un pequeñísimo interruptor que nos permitirá cambiar entre el perfil de BIOS de la gráfica, pudiendo elegir el modo OC y el modo Silent.

Cuenta eso sí con un enorme agujero que deja ver el ventilador más exterior, y que fomenta una mejor refrigeración ya que este ventilador podrá sacar el aire caliente sin restricciones.

Este diseño sobredimensionado es algo que ya hemos visto en otros modelos anteriormente, como cuando analizamos la RTX 3050 también de Gigabyte y que tenía un diseño de disipador exactamente igual. Eso sí, podemos ver que desde luego sobresale mucho, fijaos en la siguiente foto hasta dónde llega el PCB.

Para tener un dato empírico y no tener que imaginar nada, podemos deciros que de la longitud total podríamos restar nada menos que 118,6 mm si el disipador tuviera el mismo tamaño que el PCB, recortando en casi 12 centímetros la longitud de la gráfica.

De altura, el calibre nos dice que sobresale 134,6 mm, es decir, que necesitaremos una caja de PC bastante ancha para poder darle cabida.

El ancho medido es de 73,7 milímetros, o dicho de otra manera, ocupa tres slots PCI.

Y el largo (para lo que el calibre no nos llegaba y hemos tenido que utilizar un metro normal) asciende a unos 35 centímetros (por lo que el PCB mide solo unos 23 cm).

Visto el aparato, vamos a proceder a instalarlo en el sistema de pruebas y ver qué tal se comporta. Recordemos que estamos ante la que, en teoría, es la tarjeta gráfica más potente del mundo hasta la fecha.

Pruebas de rendimiento

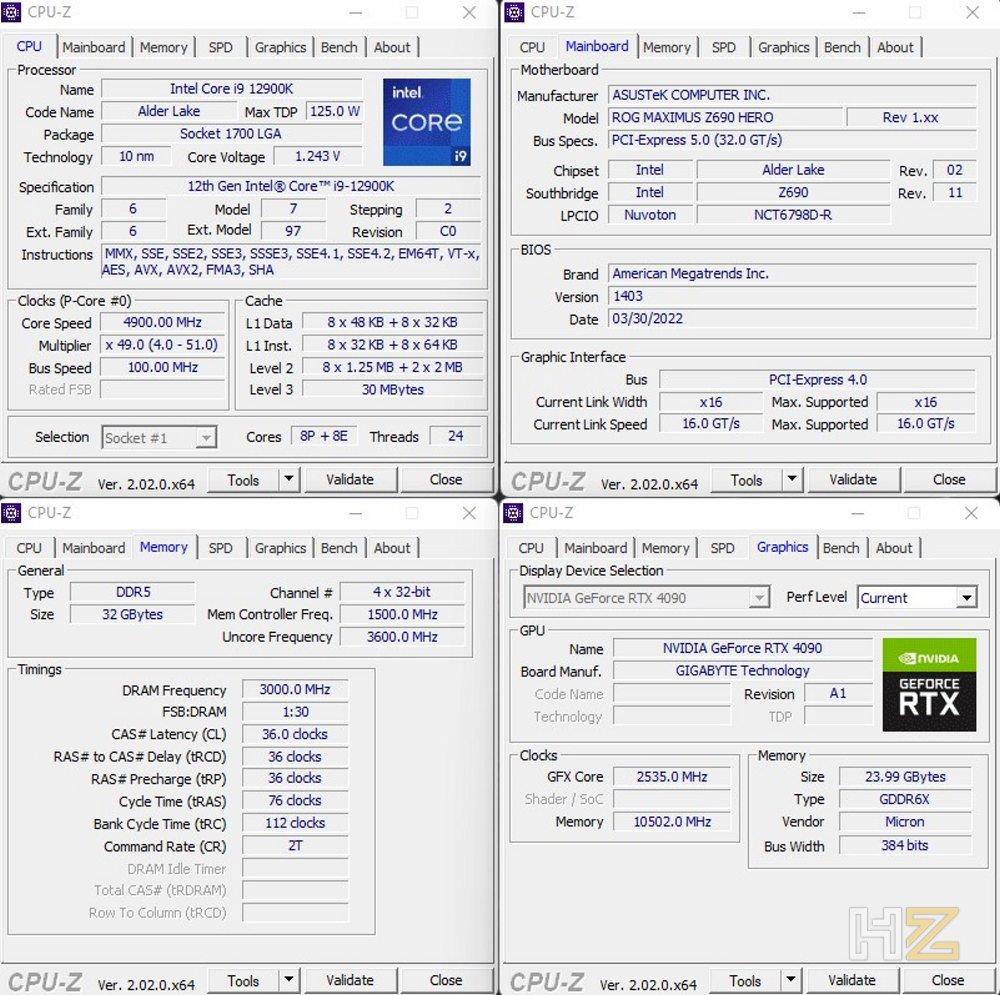

Para probar esta NVIDIA RTX 4090 vamos a hacer uso de nuestro habitual banco de pruebas, consistente en el siguiente hardware:

- Intel Core i9-12900K.

- be quiet! Pure Rock 2.

- ASUS ROG MAXIMUS Z690 HERO.

- 2×16 GB CORSAIR Vengeance RGB DDR5-6000 MHz.

- CORSAIR RM1000i.

- TeamGroup Cardea A440 Pro 2 TB.

El sistema operativo utilizado ha sido como siempre Windows 11 de 64 bits con todas las actualizaciones instaladas, y en cuanto a los controladores gráficos, hemos hecho uso de una versión Beta que nos ha proporcionado NVIDIA y que estará disponible en su versión definitiva en el momento de publicación de este análisis, la versión 521.90 Game Ready.

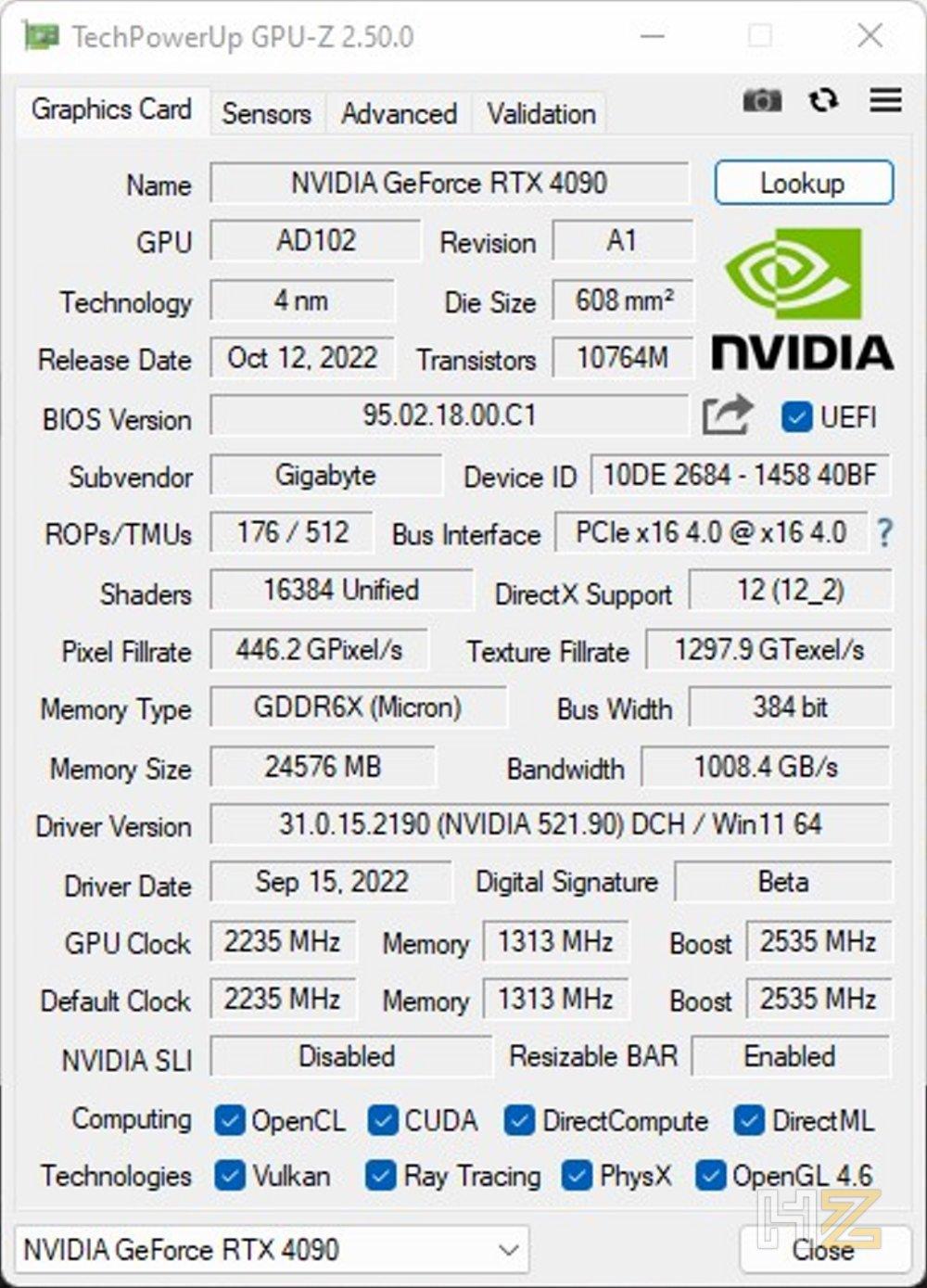

Veamos qué información nos arroja GPU-Z sobre esta tarjeta gráfica.

Como podéis apreciar, todos los datos que os mostramos cuando hablamos de las especificaciones de esta gráfica son exactos, a excepción de ese ligero Overclock que Gigabyte ha utilizado en esta gráfica y que eleva la frecuencia Boost desde los 2.520 MHz del modelo base a los 2.535 MHz, es decir, 15 MHz más.

Consumo y temperatura

Según el fabricante, esta tarjeta gráfica tiene un TGP (total graphics power, es decir, el consumo total de la tarjeta gráfica) de 450 vatios. También indican que su temperatura máxima de funcionamiento es de hasta 90ºC, así que vamos a ver qué datos hemos obtenido nosotros.

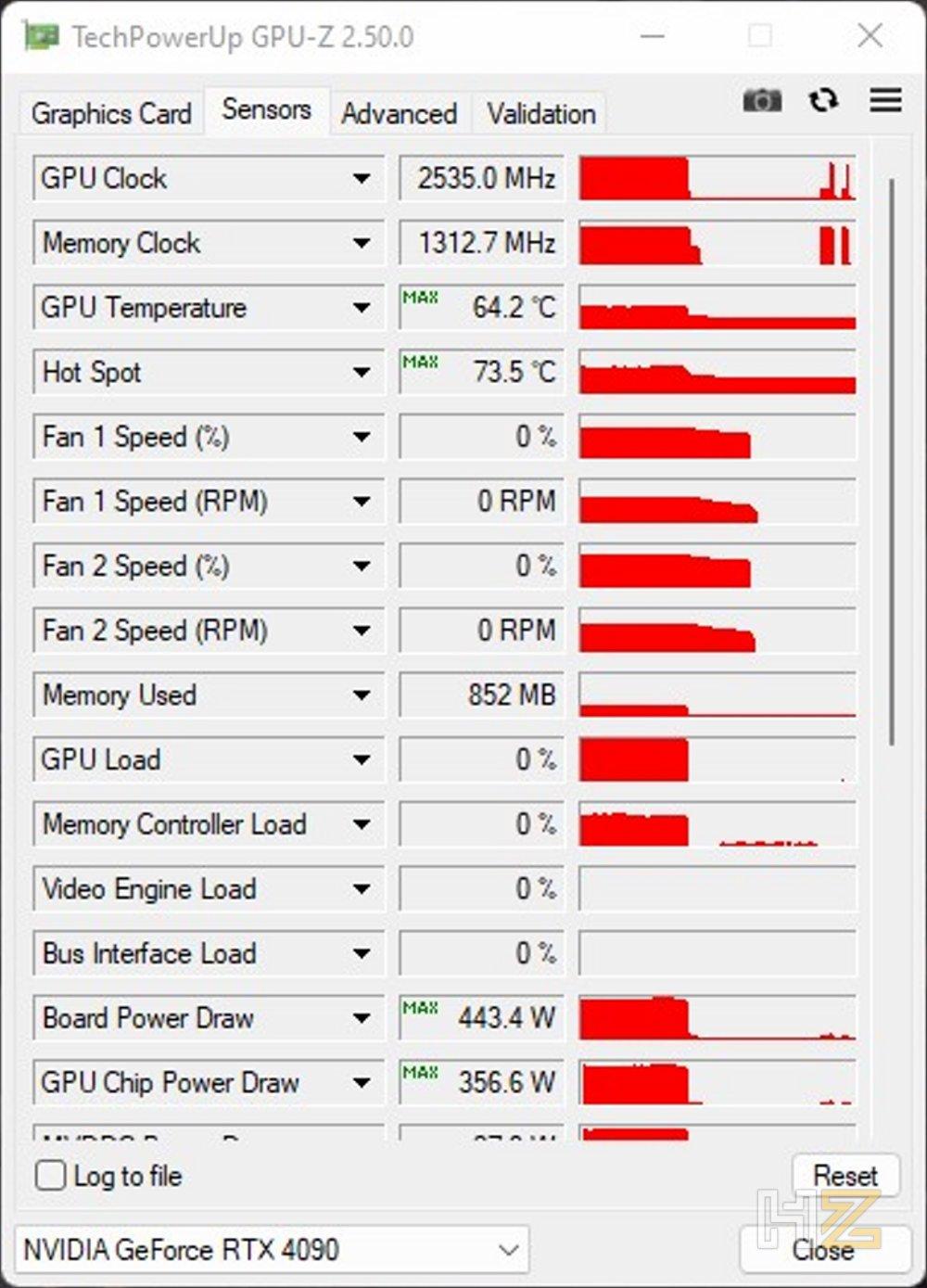

Tal y como podéis apreciar, GPU-Z ha detectado que el consumo de la gráfica ha llegado a 443,4 vatios, desde luego un consumo muy elevado pero que es el esperado. En cuanto a la temperatura, el inmenso disipador que ha instalado Gigabyte en esta RTX 4090 ha hecho su trabajo de manera sobresaliente, y la temperatura máxima registrada durante las pruebas no ha pasado de 64,2ºC teniendo unos 24ºC de temperatura ambiente, siendo el hot spot (el punto más caliente) de tan solo 73,5ºC.

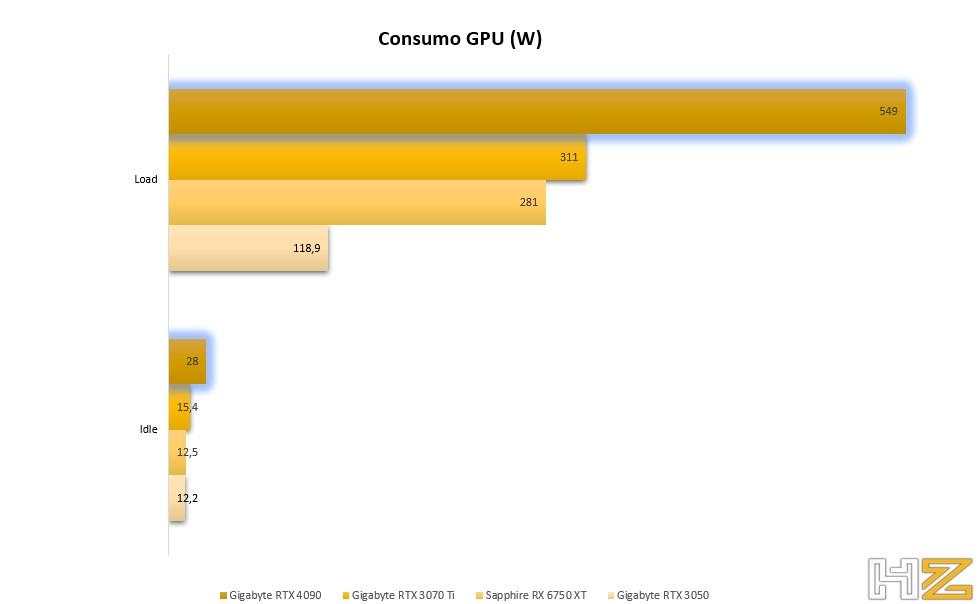

Pero vamos a poner estos datos en perspectiva. Hemos medido el consumo total del equipo con un medidor de enchufe eFergy eSocket, midiendo el consumo total del equipo tanto en reposo (en el escritorio sin hacer nada) como sometido a carga (solo ejecutando Furmark para estresar a tope la gráfica, pero no el procesador o demás componentes).

Como se puede ver en la gráfica, desde luego que el consumo se dispara utilizando esta tarjeta gráfica, y sube hasta quedarse cerca de los 550 vatios. Si pusiéramos el procesador también al máximo, así como el resto de los componentes, estaríamos en un consumo de unos 750-800 vatios aproximadamente, así que sin duda la recomendación de utilizar una fuente de 850W que decía el fabricante no es exagerada.

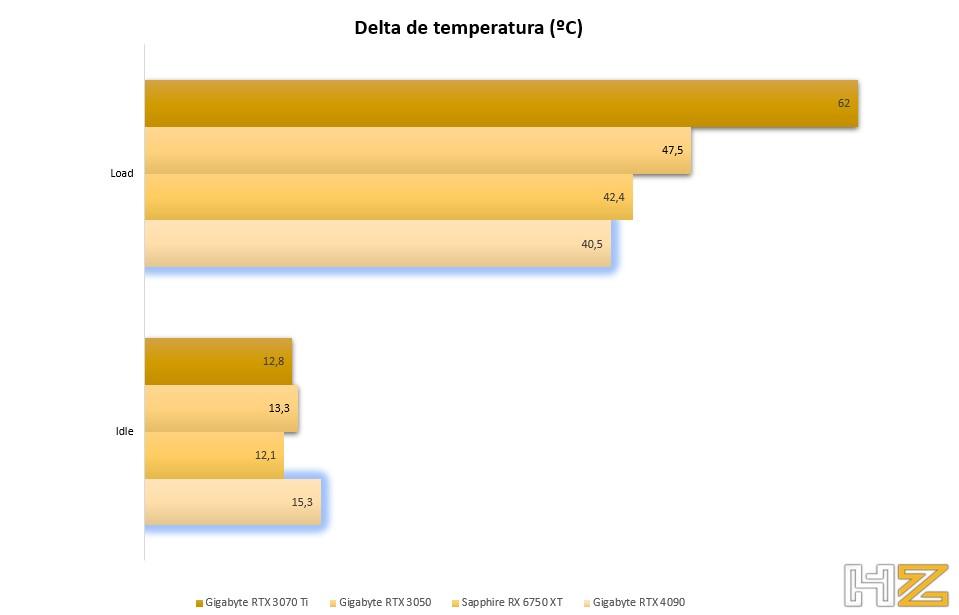

En cuanto a la temperatura, hemos medido también el dato tanto en reposo como con la gráfica sometida a máxima carga, restando la temperatura ambiente al dato obtenido para obtener el Delta de temperatura, que es lo que nos permite hacer comparativas con otras gráficas cuando la temperatura ambiente es distinta. Este es el resultado.

Si bien es cierto que la RTX 4090 es la más caliente cuando está en reposo, sigue siendo una temperatura excelente, y es que hay que recordar que los ventiladores están completamente parados cuando la gráfica está en reposo para tener el mayor silencio posible, y eso es algo muy bueno. Lo que parece increíble es que también sea la gráfica que menos se calienta cuando está sometida a carga a pesar de su enorme consumo, y esto es algo que denota las ganancias de eficiencia del nuevo proceso a 4 nm de TSMC frente al de 8 nm de Samsung que utilizaba la anterior generación. Eso, y el monstruoso disipador, claro.

Benchmarks sintéticos

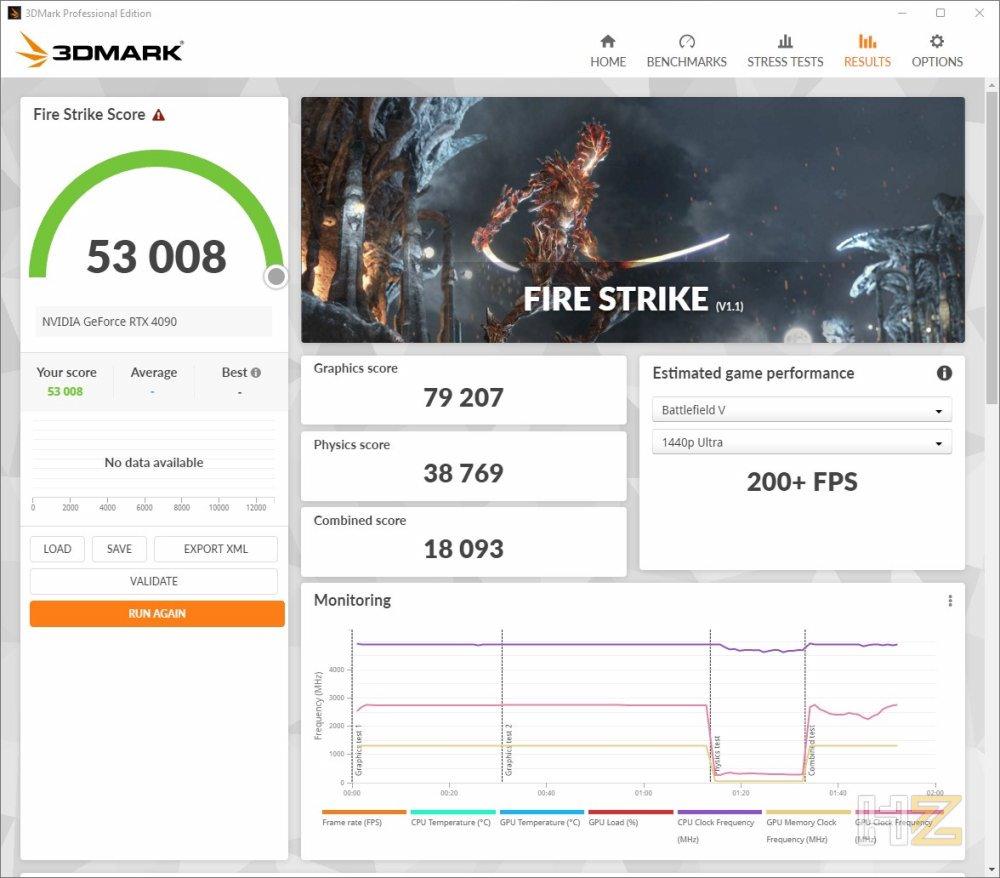

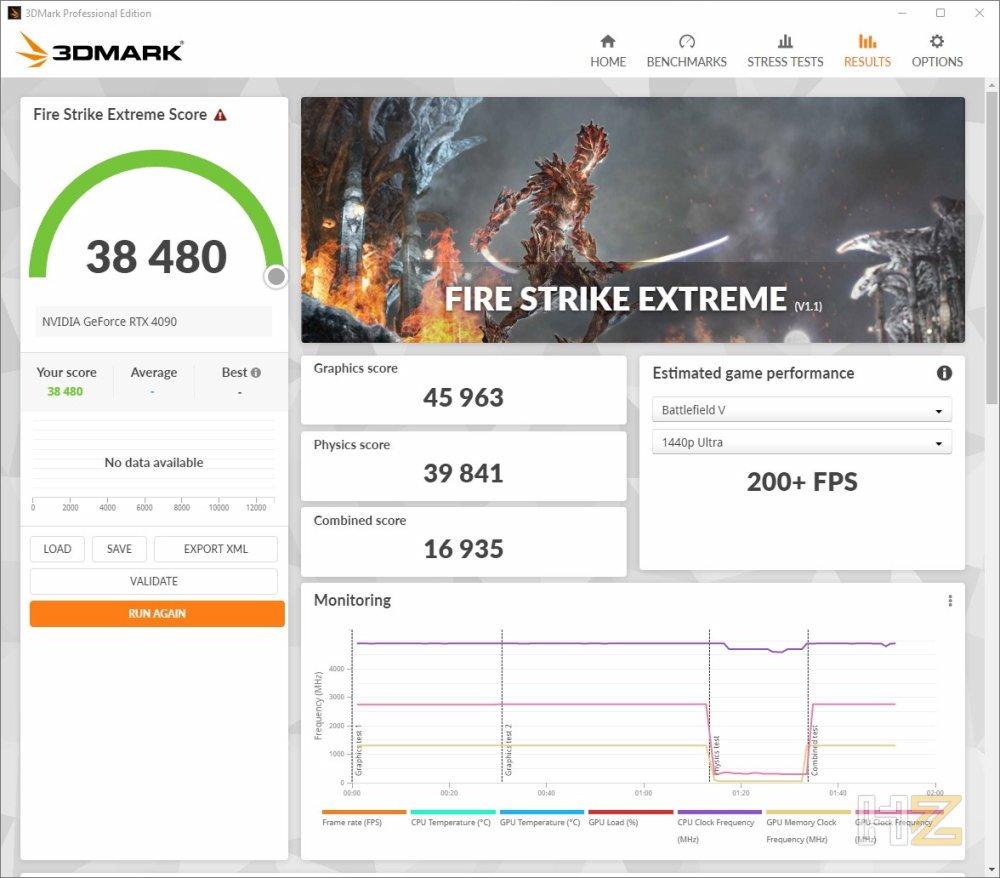

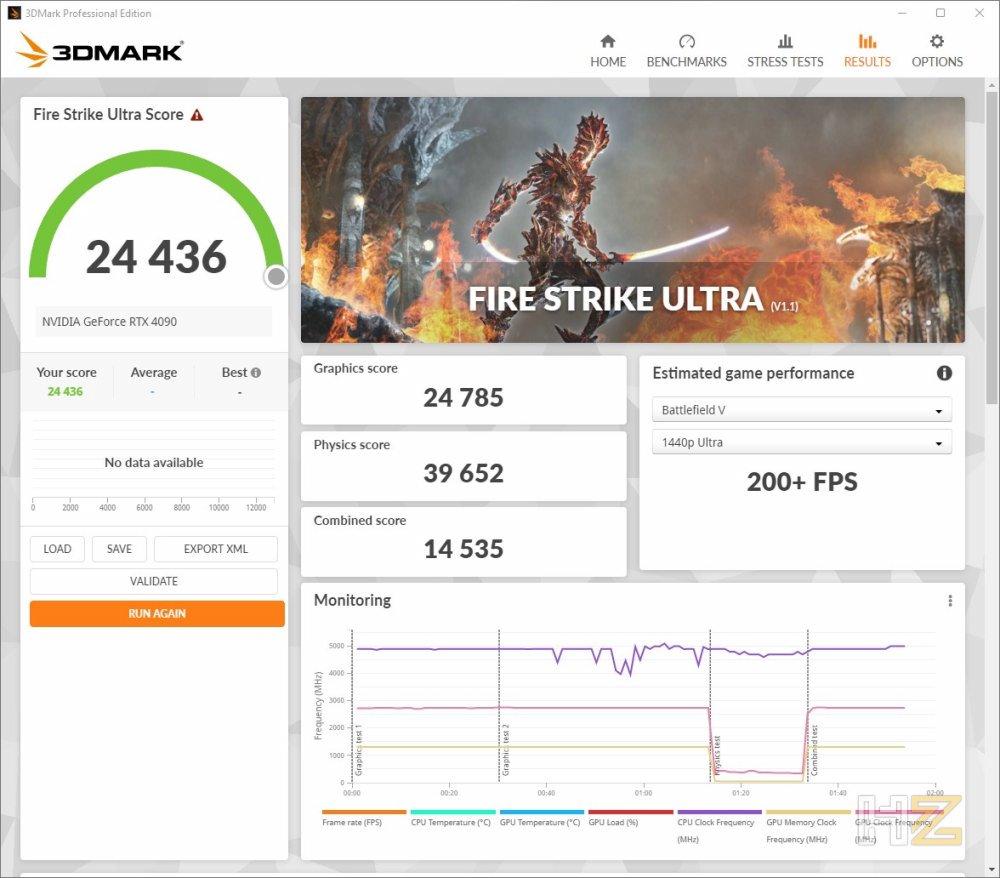

Como de costumbre, vamos a comenzar la batería de pruebas sintéticas de la gráfica con la suite 3DMark, y más concretamente con las tres pruebas Fire Strike. Este ha sido el resultado.

Como estas cifras no os dirán gran cosa, vamos a verlo comparado con otras gráficas que hemos probado exactamente en el mismo banco de pruebas.

Ahora sí, podemos ver una diferencia de rendimiento que es realmente abrumadora, y es que esta RTX 4090 nos está entregando en algunos casos más del doble de rendimiento que una RTX 3070 Ti.

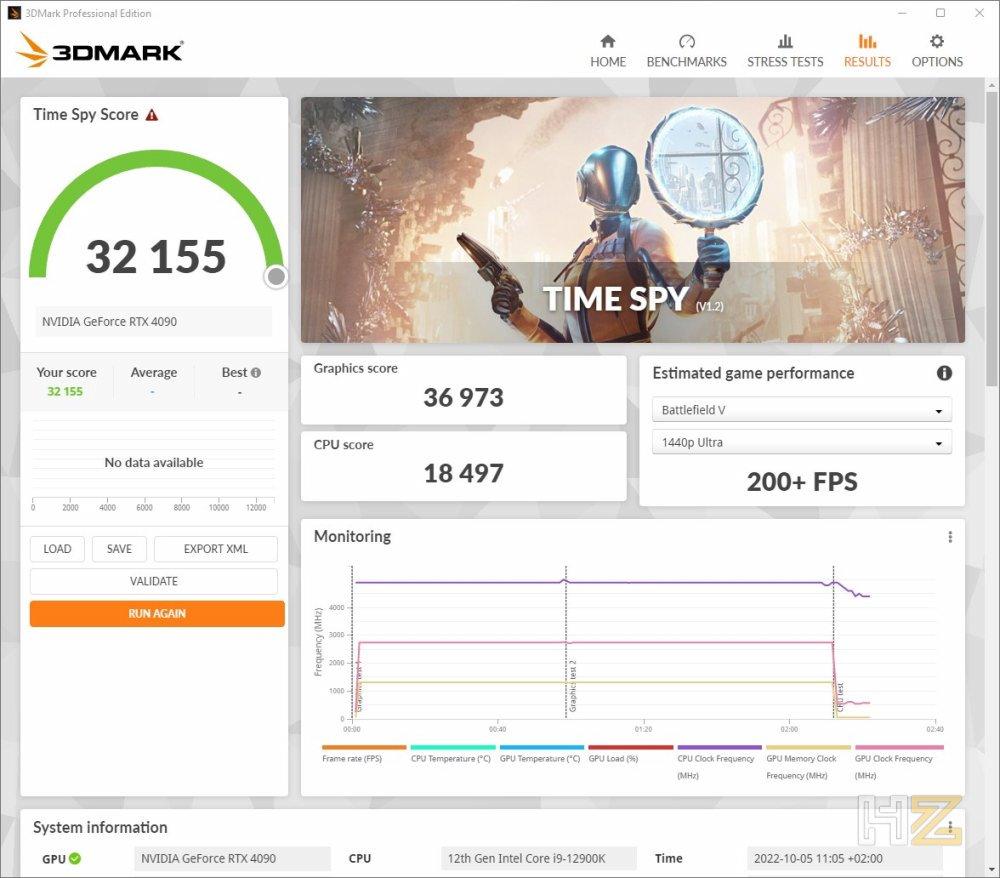

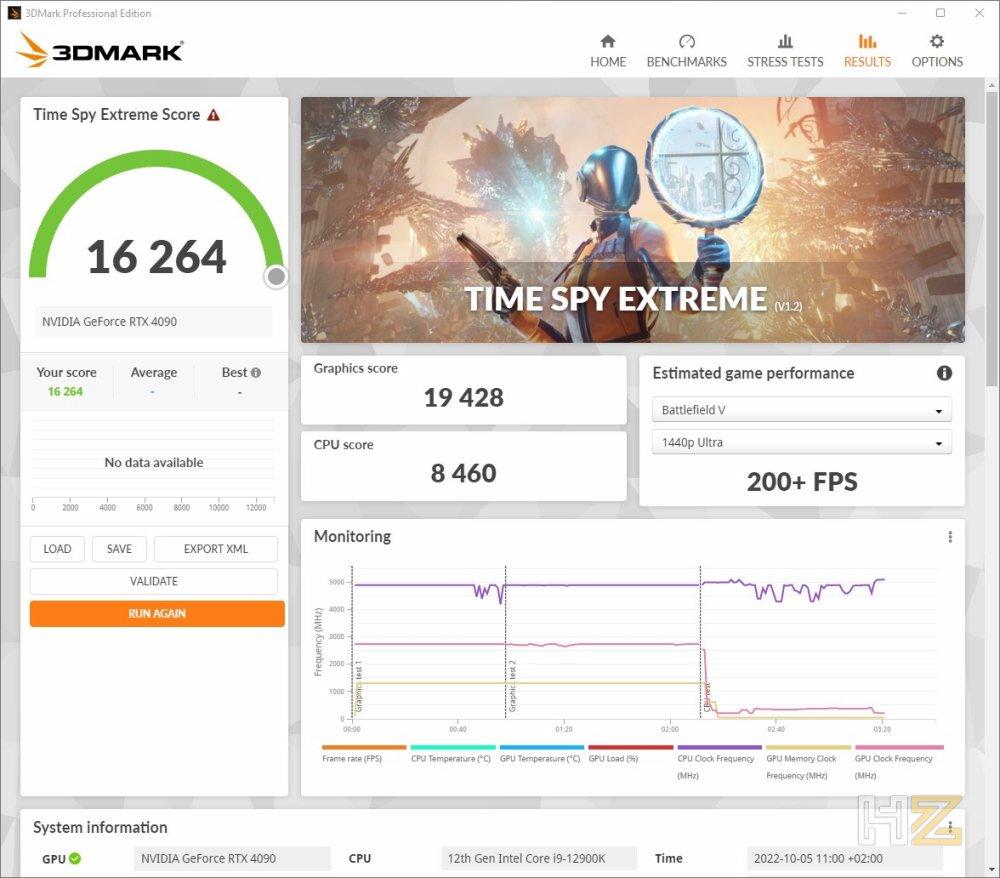

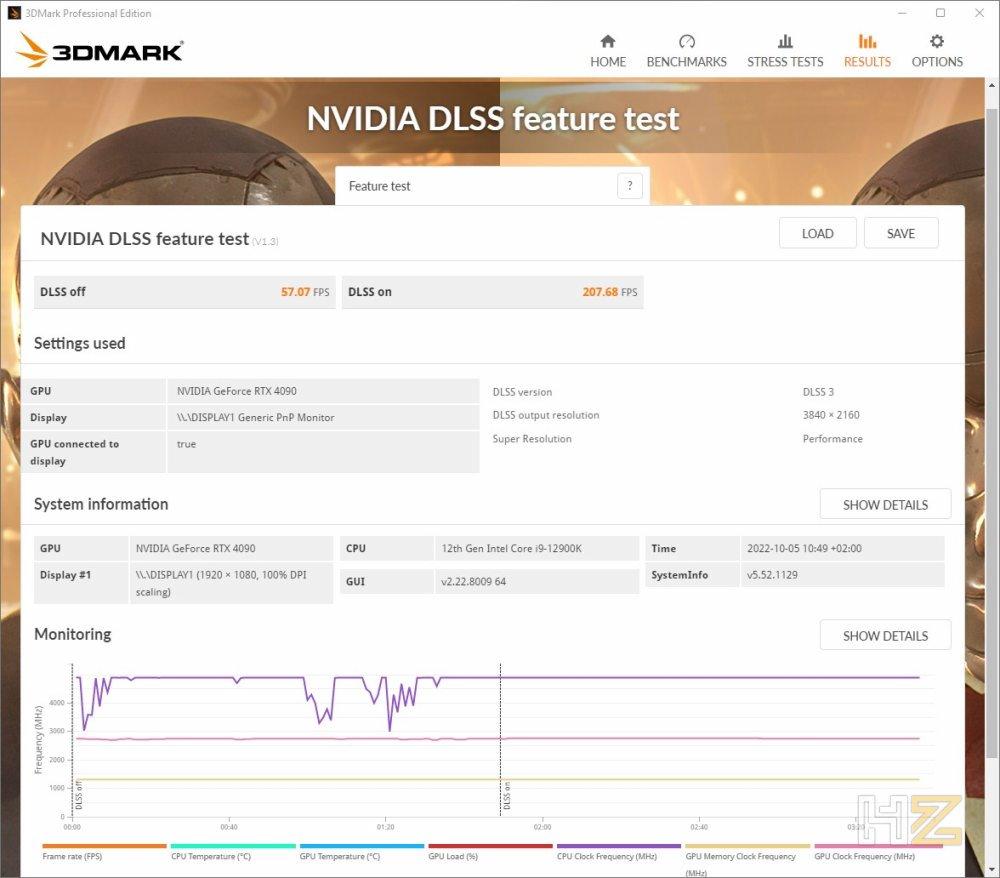

Continuamos ahora con las dos pruebas de Time Spy, donde veremos una medición similar pero con un benchmark que utiliza la API gráfica DirectX 12.

Aquí la diferencia es todavía más abultada, y es que esta RTX 4090 está dejando en la estacada a tarjetas gráficas que incluso a día de hoy siguen teniendo un precio por encima de los 800 Euros, como es la RTX 3070 Ti.

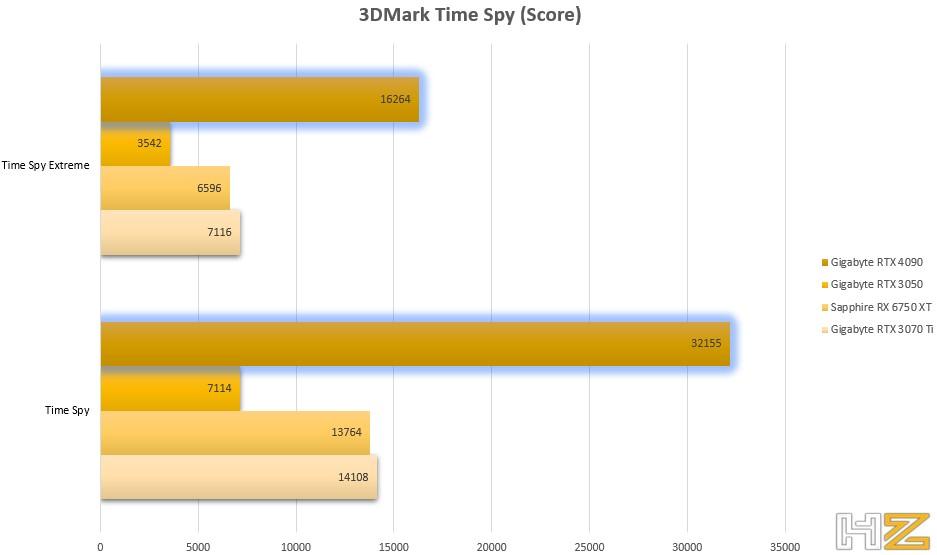

A continuación, y siguiendo con la suite 3DMark, vamos a mostraros una prueba específica para DLSS, donde vamos a poder ver la diferencia de rendimiento en una escena entre utilizar esta tecnología de NVIDIA y no hacerlo.

Como podemos apreciar, estamos literalmente cuadruplicando el rendimiento, tal y como prometía NVIDIA, y hemos pasado de 57 FPS a 207, lo que supone una mejoría de 150 FPS nada más y nada menos. De hecho, podemos deciros de primera mano que lo que veíamos en el monitor durante la prueba mostraba una diferencia abismal en cuanto a fluidez de la escena.

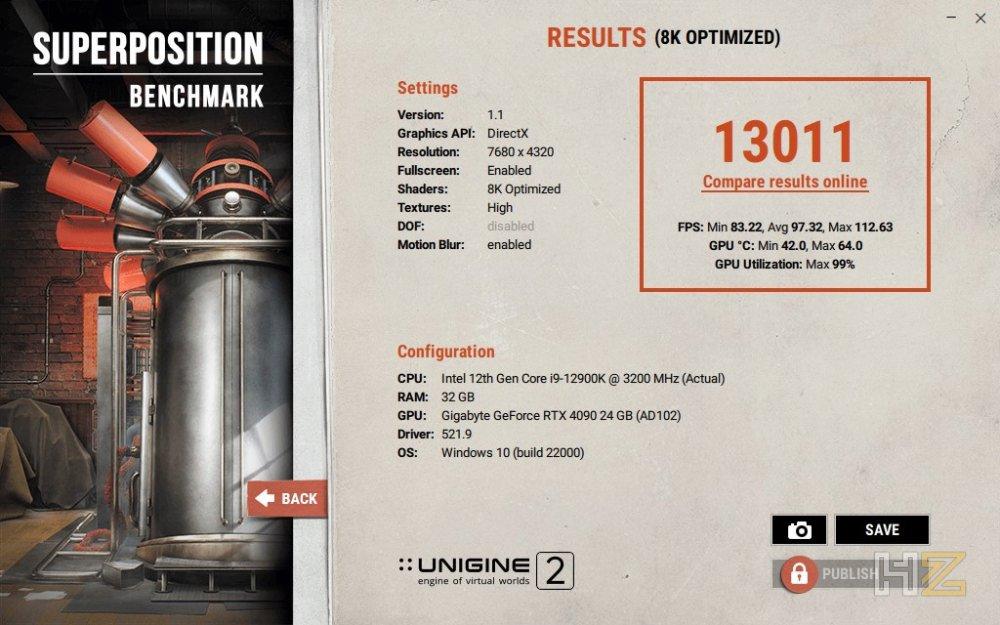

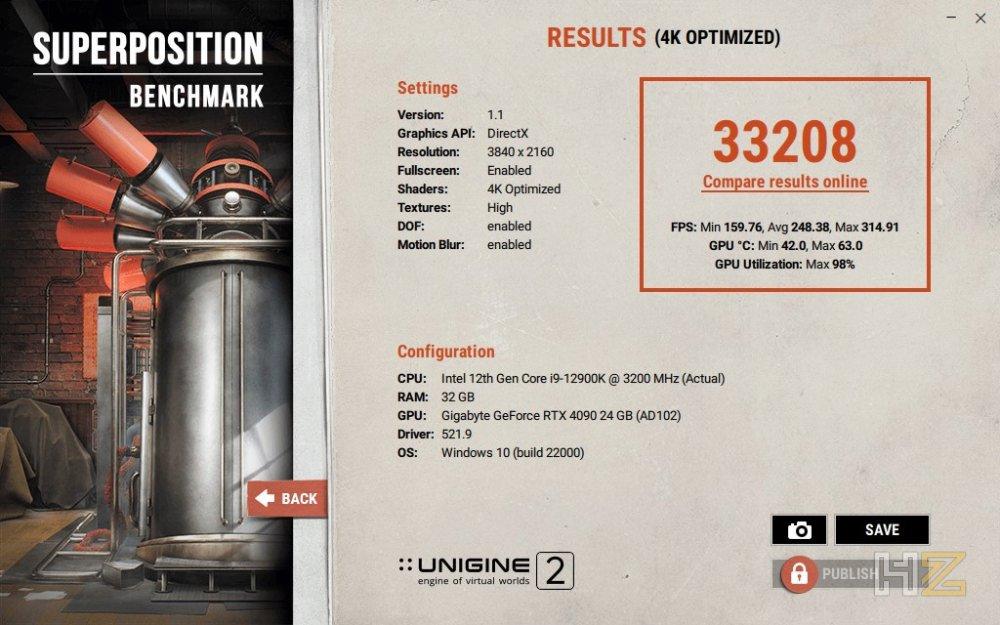

Para terminar con las pruebas sintéticas, queremos enseñaros los resultados que hemos obtenido utilizando SuperPosition Benchmark, una herramienta que ya tiene un tiempo pero que es de las pocas que nos permite emular incluso resolución 8K.

Dejando la puntuación de lado, que es algo subjetivo del propio benchmark, el dato con el que nos podemos quedar aquí es con que a resolución 4K hemos obtenido una media de 241 FPS con 159 FPS como mínimo, mientras que a resolución 8K la media de FPS ha llegado a 97, con 83 FPS como mínimo.

La RTX 4090 en juegos

Antes de mostraros nuestras pruebas habituales con los juegos de siempre, vamos a proceder a mostraros algunas pruebas adicionales que hemos hecho específicamente para este análisis, todas ellas diseñadas para mostrar de lo que es capaz la tecnología NVIDIA DLSS 3. Todas estas pruebas han sido realizadas con los ajustes gráficos al máximo y a resolución 4K a pantalla completa, con el objetivo de demostrar de lo que es capaz realmente esta RTX 4090.

Debes tener en cuenta, no obstante, que para los juegos en los que hemos probado DLSS 3 hemos tenido que seguir unas instrucciones específicas de NVIDIA y hacer uso de versiones preliminares de los juegos que añaden esta compatibilidad. Esto significa que, a pesar de que el rendimiento que te vamos a mostrar a continuación debería ser similar al que conseguiría cualquiera con esta gráfica, en realidad sí que puede ser distinto al estar utilizando nosotros versiones preliminares.

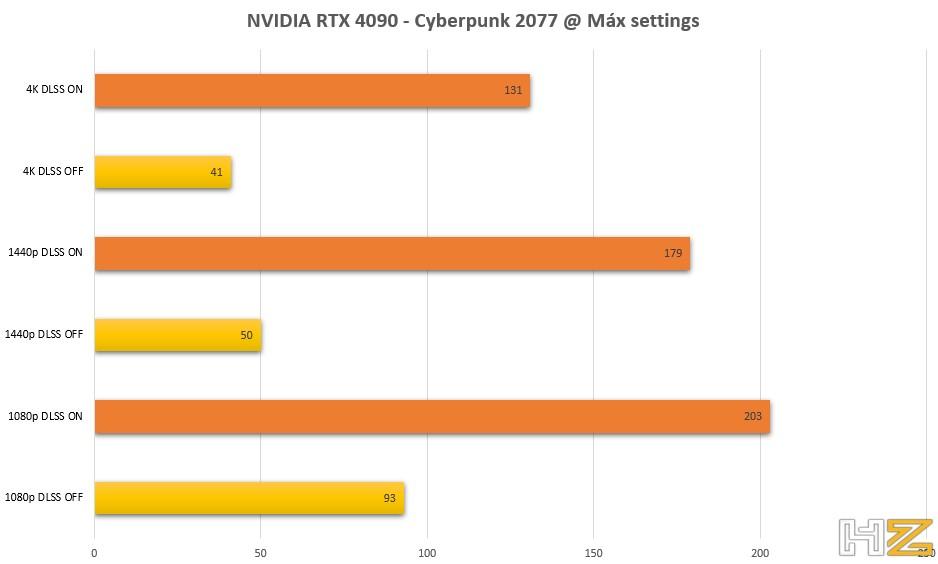

Como primer ejemplo, vamos a ver qué tal se ha comportado esta RTX 4090 con Cyberpunk 2077, un juego bastante controvertido por el rendimiento pero en el que desde que se incorporó la compatibilidad con la tecnología DLSS, mejoró notablemente. Tal y como hemos mencionado, la prueba se ha realizado con todo al máximo, incluyendo la calidad del Ray Tracing, pero con DLSS habilitado también.

Desde luego, el incremento de rendimiento utilizando DLSS 3 es simplemente impresionante, y es que llega a triplicar los FPS en algunos casos como a resolución 4K, que es realmente donde más se nota. Esto nos permite jugar a más de 130 FPS, ¡y con todo al máximo! Se nota muchísimo la increíble potencia bruta que tiene la RTX 4090, pero también se nota mucho las mejoras que se han implementado en esta nueva versión de DLSS.

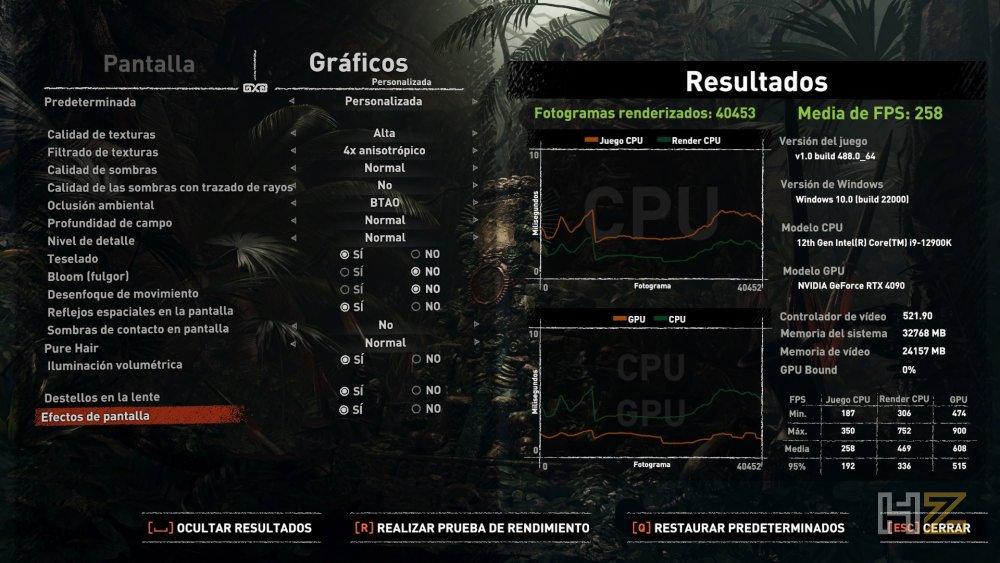

Vamos a proceder a ver ahora algunos otros juegos, ya sin DLSS y ejecutados de manera tradicional, que será lo que al fin y al cabo cualquiera que decida comprarse esta gráfica hará para disponerse a jugar.

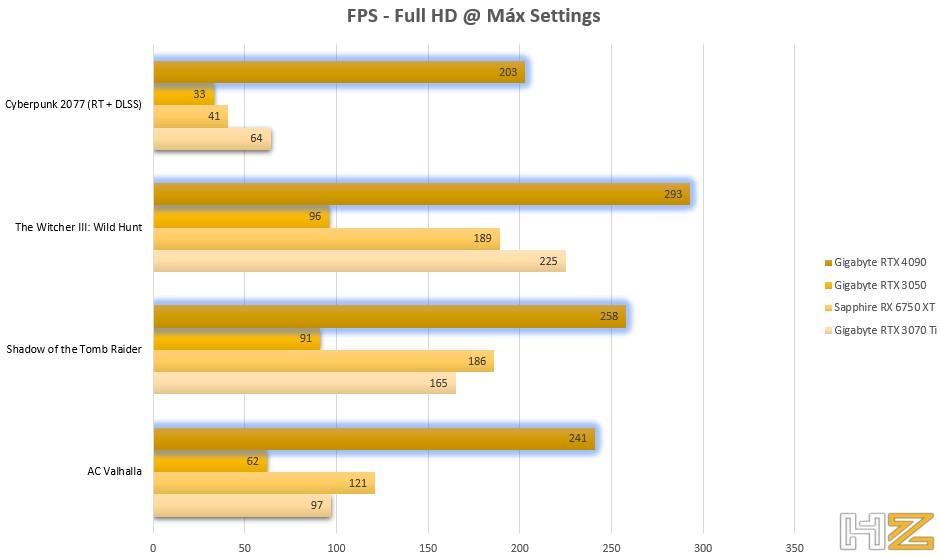

Comencemos viendo el rendimiento a resolución Full HD, si bien es cierto que quien se compre esta tarjeta gráfica muy probablemente no vaya a hacerlo a esta resolución; con todo, está bien tener el dato.

Como podemos apreciar, el rendimiento se desboca, pero vamos a ver qué sucede si lo que tienes es un monitor 1440p.

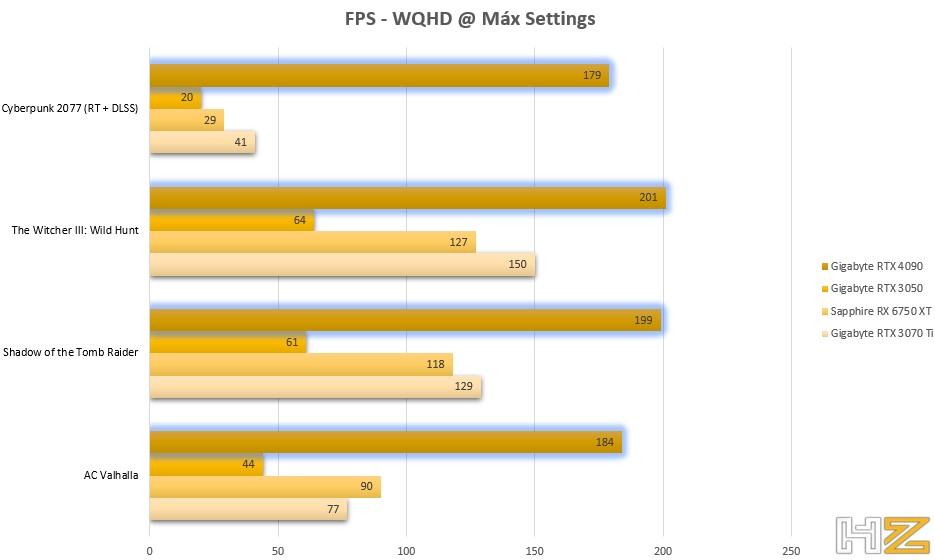

Aquí volvemos a ver que, como era de esperar, el rendimiento de la RTX 4090 es muy superior al de todas las demás, y se ha notado especialmente en títulos como Assassin’s Creed Valhalla, un juego en el que la gráfica sufre bastante. Veamos qué sucede a resolución 4K, que normalmente será a lo que aspiren a jugar quienes se gasten el dineral que cuesta esta gráfica.

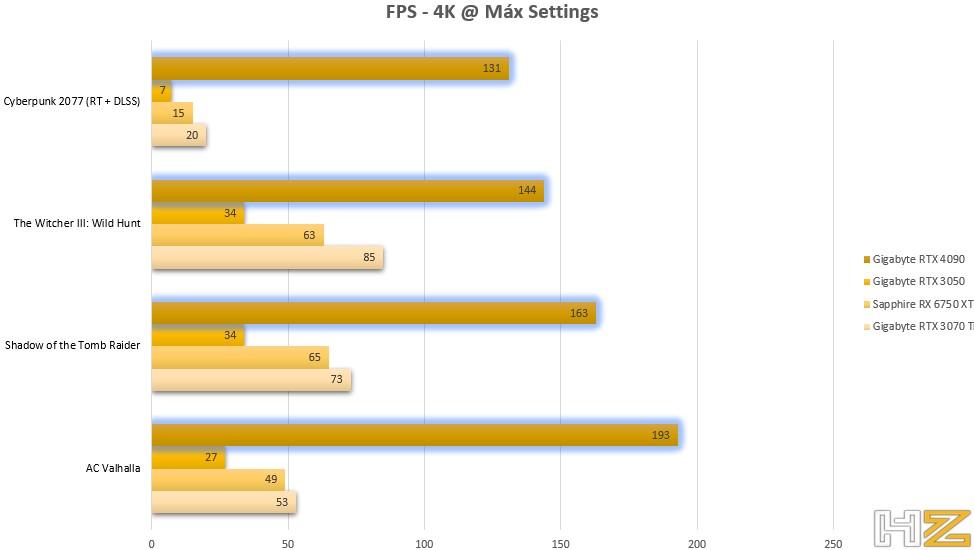

Aquí es donde realmente la diferencia es completamente abrumadora, y ya no solo en Cyberpunk 2077 con DLSS, sino en juegos más tradicionales. Por ejemplo, en The Witcher III: Wild Hunt podemos jugar a unos 85 FPS con una RTX 3070 Ti, pero con esta RTX 4090 esta cifra se eleva a 144 FPS, permitiéndonos además disfrutar mucho más si el monitor cuenta con tecnología G-SYNC.

En definitiva, y como era de esperar, esta RTX 4090 nos proporciona el mejor rendimiento que podemos tener en juegos a día de hoy, y muy especialmente a altas resoluciones.

Conclusión y veredicto

Una vez más, NVIDIA vuelve a coronarse como el fabricante de las tarjetas gráficas más potentes del mundo, y la RTX 4090 es el claro ejemplo de ello. Es una tarjeta gráfica diseñada especialmente para jugar al máximo a altas resoluciones, y se beneficia de todas las nuevas tecnologías de la firma como Reflex o DLSS 3.0 para optimizar al máximo el partido que le podemos sacar.

Honestamente estamos ante una tarjeta gráfica que parece no haber sido diseñada «solo» para jugar, ya que tanto por su ingente potencia de cálculo GPGPU como por su gran cantidad de memoria VRAM dedicada, es idónea también para diseñadores y desarrolladores que buscan poder soportar altas cargas de trabajo.

Eso sí, esta enorme potencia bruta tiene también su parte mala, y es que esta es también la tarjeta gráfica más grande jamás creada, y no es apta ni para todas las cajas de PC, ni para todas las fuentes de alimentación, pues recordemos que necesitaremos una fuente de al menos 850 vatios para poder darle servicio (además de su alto consumo, que repercutirá en la factura de la luz). Por otro lado, también es casi irreverente su precio, 1.959 Euros el modelo base, 2.049,90 Euros el modelo custom de Gigabyte que hemos analizado.

En cuanto al modelo custom de Gigabyte que es el que hemos analizado, solo podemos aplaudir el modo en el que lo ha ejecutado. La gráfica es grande y pesada, sí, pero incluyen un soporte que, si bien no tiene un montaje demasiado sencillo, garantiza que no tengamos problemas por el elevado peso del conjunto. Además, su disipador de triple ventilador es muy silencioso y logra mantener la tarjeta gráfica siempre fresca, lo cual es muy de agradecer. Lo único que no nos ha gustado de este modelo es la iluminación, que hemos terminado desactivando puesto que está integrada bajo las aspas de los ventiladores, y al girar estos crea un efecto estroboscópico que puede llegar a marear.

Por todos estos motivos, la RTX 4090 de NVIDIA se hace merecedora de nuestro galardón de Oro, así como de nuestra recomendación por su increíble rendimiento.