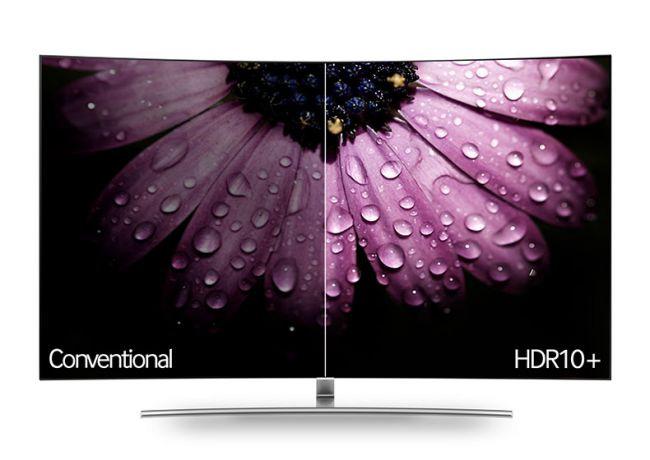

En breve tiempo van a comenzar a llegar al mercado de monitores de ordenador las primeras unidades que emplearán la tecnología HDR10+, la cual va a ser la principal competidora de la actual tecnología Dolby Vision. Es hora que os expliquemos, en este tutorial, cómo funciona esta tecnología y cómo puede ayudar a mejorar la imagen en nuestro monitor.

La llegada de la tecnología HDR (o High-dynamic Range) a los monitores de ordenador, cada vez está cogiendo más fuerza, y cada vez son más los usuarios que optan por monitores que la incorporan. El motivo estriba es que, simplificándolo, gracias a esta tecnología, las imágenes son más realistas y bastante más detalladas que las imágenes que se pueden mostrar en una pantalla normal. Esta tecnología se basa en que, junto con los datos de la imagen, a la vez, se transmiten una serie de metadatos que permiten ajustar el brillo y el contraste de la pantalla, de manera que la imagen resultante sea mucho más agradable de mirar.

La tecnología HDR tiene su origen inicial en las cámaras de fotos, desde la cual evolucionó hacia los televisores para, finalmente, dar el salto final a nuestros monitores. Así que, en el entorno de escritorio, es una tecnología bastante novel, pero que está avanzando con bastante rapidez, dada la gran aceptación que está teniendo por parte de los fabricantes.

HDR10+ será gratuita y competirá con Dolby Vision

Así como el estándar HDR10 tan solo emplea una única serie de metadatos para el archivo que estemos viendo en pantalla, especialmente si se trata de una película, la tecnología HDR10+ emplea metadatos dinámicos. Esto significa que, en lugar de configurar un solo nivel de brillo y contraste para la imagen para una duración determinada, ahora se envían estos metadatos de manera constante al monitor, según vaya cambiando las imágenes en pantalla. De hecho, se pueden cambiar por cada frame que se muestre en pantalla, lo que indudablemente mejora la calidad de la imagen representada.

Hasta aquí, tanto HDR10+ como Dolby Vision parecen hermanas gemelas, entre ambas tecnologías hay una diferencia básica que puede hacer que los fabricantes se decanten más por una de ellas o por la otra. Y es que el estándar HDR10+ es completamente gratuito de implementar para los fabricantes en sus monitores y televisores. Sin embargo, el Dolby Vision no lo es, y el fabricante ha de pagar una pequeña cantidad, en concepto de licencia, a Dolby Laboratories si quieren emplear esta tecnología. La cantidad no es muy alta (3 dólares por cada unidad fabricada), pero cuando esa cantidad la multiplicas por varios miles o decenas de miles de unidades, las cantidades resultantes comienzan a ser altas.

Por otro lado, el hecho de que HDR10+ sea gratuito, significa que los fabricantes no repercutirán ningún sobrecoste en los usuarios. Fijaos si no los «problemas» que tiene la tecnología G-Sync para entrar en el mercado de monitores de ordenador y, por el contrario, lo rápidamente que se está extendiendo la tecnología AMD FreeSync entre ellos.