Construir una IA (Inteligencia Artificial) es algo complicado, pero comprender en qué consiste no tiene por qué serlo. Para ello, en este artículo os vamos a explicar qué son la IA, el Machine Learning y el Deep Learning, así como las diferencias entre ellos.

Por la influencia del cine y la literatura, la creación de la inteligencia artificial nos aterra enormemente; sin embargo, esta se encuentra muy lejos de ser sintiente y poder desarrollar una moral o falta de la misma. Al igual que lo multimedia en los 90, la inteligencia artificial está sufriendo un boom enorme con la llegada de una gran cantidad de aplicaciones de todo tipo y de hardware especializado en forma de nuevos procesadores y para acelerarlas.

¿Qué es la inteligencia artificial?

Entendemos como Inteligencia Artificial a una disciplina dentro de las ciencias de la computación que consiste en el desarrollo de un tipo de algoritmos en el ámbito del software y del hardware para ejecutarlos de la manera más eficiente posible tanto con respecto al consumo energético como de tiempo de ejecución.

La mayoría de algoritmos de IA existentes hacen el uso del hardware para resolver ciertos tipos de problemas, pero lo hacen de una manera concreta. A través de unos datos de entrada, el algoritmo aprende a clasificar la información (en una base de datos) o a hacer predicciones a través de patrones concretos. Es algo que da la apariencia de ser mágico, pero lo que hace es utilizar esos datos para afinar su predicción, siendo esta predicción el algoritmo, el cual en vez de ser estático va variando a medida que entran nuevos datos y se acaba viendo si la predicción es correcta o no.

Explicado de forma clara y concisa: imaginad que una IA es un procesador que tiene una gran base de datos y que basa sus elecciones (las respuestas) por simple estadística. Ni más ni menos.

Tipos de inteligencia artificial

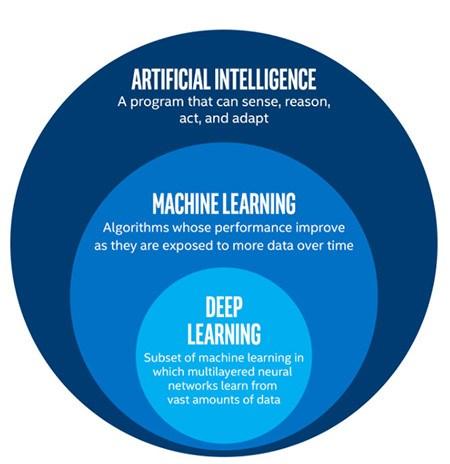

Lo que diferencia a la Inteligencia Artificial de otros programas de ordenador es que no hay que programarla específicamente para cada escenario. Podemos enseñarle cosas (Machine Learning, aprendizaje automático), pero también puede aprender por sí mismo (Deep Learning).

Si bien existen múltiples variantes de cada uno, se pueden definir de manera general de esta forma:

- IA (Inteligencia Artificial): una máquina que es capaz de imitar el razonamiento humano.

- ML (Machine Learning): un subconjunto de Inteligencia Artificial donde las personas «entrenan» a las máquinas para reconocer patrones basados en datos y hacer sus predicciones.

- DL (Deep Learning): un subconjunto de ML en el que la máquina es capaz de razonar y sacar sus propias conclusiones, aprendiendo por sí misma.

A continuación veremos las diferentes categorías de algoritmos relacionados con la inteligencia artificial.

La IA (Inteligencia Artificial)

Hablamos de Inteligencia Artificial cuando un sistema informático es capaz de sacar conclusiones a partir de un conjunto de datos y no ejecutar un simple algoritmo. Siendo estas conclusiones tal y como hemos comentado antes un nuevo algoritmo.

Cuando hablamos de inteligencia artificial nos vienen a la mente realidades distópicas como las que se presentan en Terminator, Matrix y demás películas y relatos de ciencia-ficción en la cultura popular. A día de hoy la IA todavía está bastante lejos de eso; por ejemplo, Alexa puede ser un buen mayordomo, pero no puede pasar el famoso test de Turing. Actualmente, tenemos una forma bastante limitada de Inteligencia Artificial.

Gracias a la progresión que han tenido en los últimos años los chatbots, cada vez se va reduciendo más esta limitación, ya que cada vez se sacan versiones más actualizadas y potentes de los mismos, que permiten a los usuarios mantener una conversación con una IA de la forma más humana posible, principalmente esto se debe a que son capaces de razonar y contestar dependiendo de lo que se les diga o pregunte.

Aún así, siguen siendo incapaces de pensar por si mismos ya que necesitan un comentario previo al que contestar, por lo que nos os preocupéis, ya que estamos lejos de la rebelión de las máquinas que planean esos relatos de ciencia ficción. En realidad, la Inteligencia Artificial es un término tan amplio que realmente es un superconjunto que engloba demasiadas ideas, por lo que es mucho mejor acotar para entender lo que hay en el hardware actual.

ML (Machine Learning)

Toda inteligencia para saber ha de aprender, por lo que necesita datos para sacar conclusiones a partir de los mismos. De la misma manera que el pensamiento lógico se basa en premisas para sacar la información, y es que los sistemas de nuestros ordenadores se basan en la lógica pura y dura. Un programa normal lo que hace es ejecutarse, pero un algoritmo de inteligencia artificial está pensado para aprender y esto significa corregir errores.

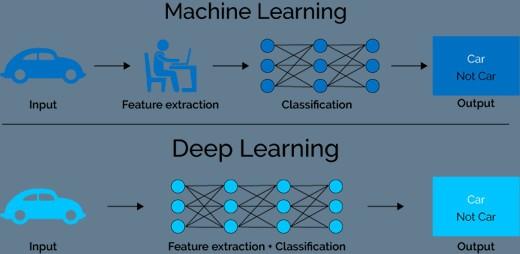

Es decir, esta innovación les da a los ordenadores el poder de resolver las cosas sin que las tengan programadas explícitamente. Como ejemplo de un aprendizaje automático, supongamos que quieres que un programa pueda identificar gatos en imágenes:

- Dale a tu IA un conjunto de características de cómo es un gato, para que sepa reconocerlo. Colores, formas, etc.

- Muéstrale imágenes (si alguna está etiquetada como «gato», la IA podrá identificarla más fácilmente).

- Una vez que el programa haya visto suficientes gatos, debería ser capaz de identificarlos en otras imágenes: «si la imagen contiene ciertas características, entonces hay un 95% de que sea un gato».

Os puede sonar complicado, pero un ejemplo de la capacidad de aprendizaje la tenemos en una serie de utilidades, ya que gracias a ella cosas tan cotidianas como el filtro del correo basura o las recomendaciones de Netflix u otros servicios similares para cada uno de nosotros se hacen posibles, todo gracias a los datos que ha recopilado el sistema.

Es por ello que a día de hoy y con todo el mundo conectado a la red de redes y compartiendo sus datos, el Machine Learning se ha vuelto tan importante, ya que ayuda a las diferentes empresas a tener perfiles de consumo de los usuarios. Aunque no es la única aplicación, pero sí la más sencilla de entender y la que está más al alcance de todos.

DL (Deep Learning)

Desde 2018, esta es la vanguardia de la Inteligencia Artificial. Piensa en ello como un aprendizaje automático con profundas «redes neuronales» que procesan los datos de manera similar al cerebro humano, permitiendo que la propia IA sea capaz de razonar y entender qué es aquello que se le quiere enseñar, sin tener que decírselo explícitamente.

La diferencia clave con respecto a su predecesor es que los humanos no tienen que enseñar al programa cómo son los gatos; simplemente dale suficientes fotos de gatos y será capaz de resolverlo por sí mismo:

- Dale muchas fotos de gatos.

- El algoritmo inspeccionará las fotos para ver qué tienen en común (pista: son gatos).

- Cada foto se deconstruirá en múltiples niveles de detalle, desde formas grandes y generales hasta líneas pequeñas. Si una forma se repite mucho, el algoritmo lo etiquetará como una característica importante.

- Tras analizar suficientes fotos, el algoritmo ya sabrá reconocer los patrones que definen lo que es un gato y podrá identificarlo en cualquier otro escenario.

En resumen: el Deep Learning es el aprendizaje automático, en el que el ordenador es capaz de aprender por sí mismo (aunque va mucho más allá de los gatos, claro, pues actualmente las máquinas ya son capaces de captar muchos más parámetros dentro de las fotos, como el paisaje por ejemplo).

El Deep Learning requiere muchos más datos iniciales y potencia de cómputo que el Machine Learning, eso sí, pero compañías como Facebook o Amazon ya están comenzando a implementarlo.