Los últimos rumores apuntan a que las próximas generaciones de tarjetas gráficas aumentaran de tamaño y consumo. Esto es un problema, al que parece que se ha encontrado una solución bastante ingeniosa. NVIDIA habría desarrollado PrefixRL, un sistema que permite reducir los circuitos y, por consiguiente, hacer que las tarjetas gráficas tengan menor consumo.

Se rumorea que las RTX 40 Series de NVIDIA podrían llegar a tener consumos cercanos a los 600 W en los modelos más potentes. Hablamos de consumos desmedidos, pese a que se reduce el tamaño de los transistores. Este problema es conocido por los fabricantes de gráficas (y procesadores) se están buscando soluciones.

NVIDIA hará que sus futuras tarjetas gráficas sean más eficientes

Diseñar los circuitos de la GPU de una tarjeta gráfica no es nada sencillo. El objetivo siempre es mejorar el diseño para aumentar la potencia, pero al mismo tiempo, hacer el diseño lo más pequeño posible. Reducir el tamaño del circuito supone que sea más rápido y económico de fabricar.

Para ayudar a los ingenieros, NVIDIA ha desarrollado un modelo de IA denominado PrefixRL. Este sistema se presenta como una solución alternativa a las herramientas tradicionales para diseño de circuitos integrados.

Actualmente, se usa EDA (automatización de diseño electrónico) que es ofrecido por proveedores como Cadence, Synopsys o Siemens, entre otros. Cada proveedor utiliza un sistema de IA diferente para la colocación y enrutamiento del silicio. PrefixRL parece que es una solución mucho más potente que permite un nivel de integración superior.

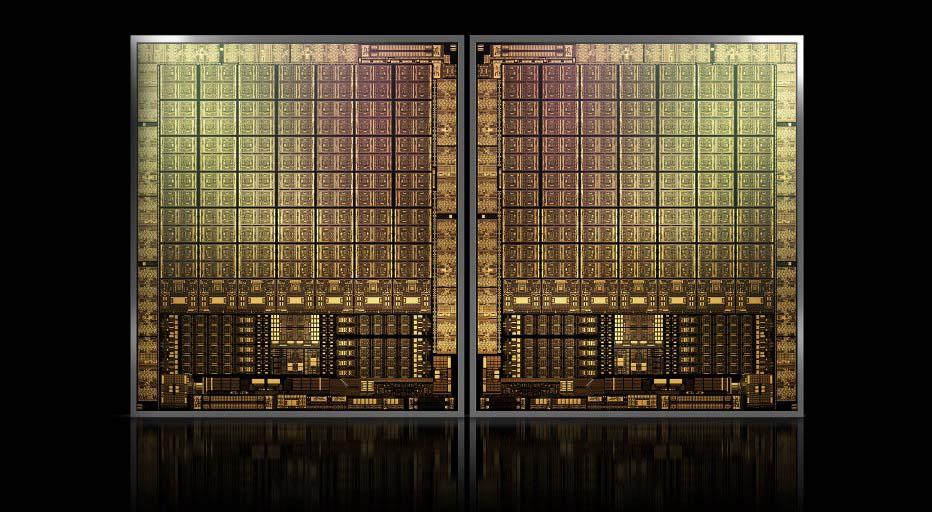

La idea es obtener las mismas características que los sistemas EDA, pero con un tamaño de troquel más pequeño. Según indica NVIDIA, las GPU Hopper H100 hacen uso de 13.000 instancias de circuitos aritméticos diseñados por PrefixRL. El diseño basado en PrefixRL sería un 25% más pequeño que el diseñado por EDA. Siempre con una latencia igual o mejor.

El sistema es bastante complejo y requiere una gran cantidad de hardware para poder hacer el desarrollo. Se ha estimado que para diseñar un circuito sumador de 64 bits se requieren 256 núcleos de procesador y unas 32.000 horas. Obviamente, cuanto mayor sea el número de núcleos, mejor será el tiempo.

¿Cómo afectará a las tarjetas gráficas gaming?

Pues bien, NVIDIA no ha dado datos al respecto, pero es posible que para las RTX 40 Series ya se ha usado esta tecnología. Los rumores apuntan a elevados consumos, aunque no hay constancia a este respecto. Es posible que una hipotética RTX 4090 consuma muchísimo, pero la gama media y, de entrada, tenga consumos similares a las gráficas actuales.

Cabe suponer que a medida que se mejore esta tecnología para diseño de circuitos, se mejore el nivel de integración. A la larga podría conseguir reducir los consumos y aumentar el rendimiento. También ayuda en reducir los tiempos de fabricación, por consiguiente, los costes de fabricación de los chips para las tarjetas gráficas.

Posiblemente, NVIDIA espere a eventos especializados, como la Hot & Chips para dar más datos de esta tecnología y su funcionamiento. Sin duda una solución bastante interesante que puede mejorar las tarjetas gráficas del futuro.