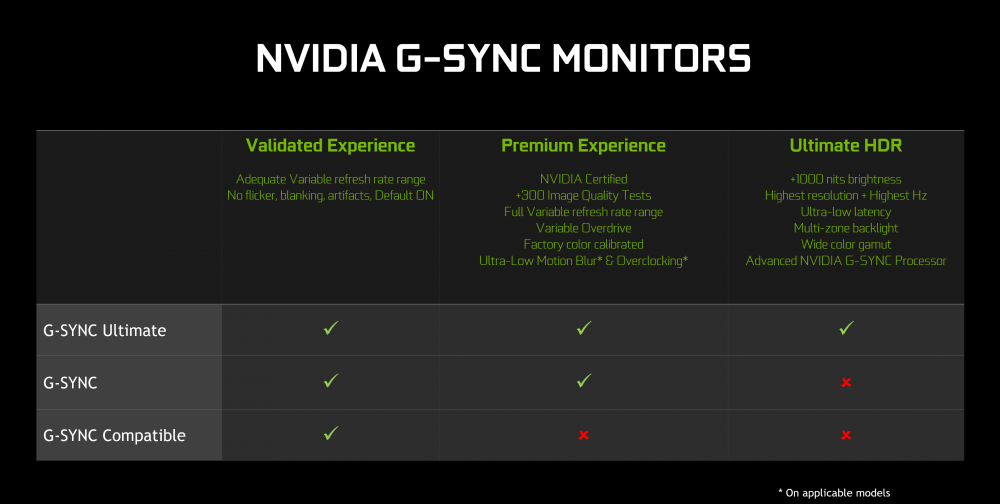

Desde que salió a la palestra la tecnología G-SYNC siempre se ha criticado un aspecto clave de todo aquel monitor que usaba uno de sus módulos: el sobreprecio. FreeSync llegó como la competencia, pero realmente no es tal, ni lo ha sido ni siquiera lo pretende, puesto que no usa hardware físico y es todo sincronización por software como G-SYNC Compatible, y por lo tanto no hay un incremento del precio, pero ¿sabes cuánto cuesta realmente un módulo G-SYNC? Alucinarás.

Si eres uno de esos usuarios que se queja por el precio de más de los monitores G-SYNC, después de este artículo puede que pienses que incluso es un chollo. No vamos a entrar lógicamente en comparativas de lo que vale un monitor FreeSync vs uno con G-SYNC o G-SYNC Compatible, es un sinsentido principalmente porque no compiten por el mismo usuario ni por la misma experiencia de juego, pero a raíz de una pequeña investigación en Igor’s Lab ahora sabemos algo más sobre lo que hace NVIDIA con dichos módulos físicos y chips.

G-SYNC vs G-SYNC Ultimate, distintos módulos

Puede parecer una obviedad como tal, pero la realidad es que por norma general y sobre todo si los monitores a comparar son muy dispares en tamaño y prestaciones, NVIDIA usa distintos módulos G-SYNC mediante el testeo de una serie de cualidades para el panel.

El que vamos a tratar aquí pertenece a lo mejor de la marca, G-SYNC Ultimate, y el monitor a tratar ha sido un AOC Agon AG353UCG, el cual está entre los 1800 euros y los 2300 euros según el país y la tienda donde se mire. En este tipo de monitor y en otros tantos hay un problema bastante serio con el módulo de NVIDIA, y es que este se calienta muchísimo.

Por ello, muchos fabricantes han tenido que recurrir a la disipación activa mediante un pequeño ventilador, no sin antes incluir un sistema de refrigeración que bien podría valer para algunas CPU de gama baja. Lo que podremos encontrar tras este disipador con 6 (que se dice pronto) es una tarjeta MXM con un chip Altera Arria 10AX048H2F34E1HG-ND unido a sendos módulos de VRAM firmados por Micron (en la mayor parte de monitores).

Esta tarjeta es realmente un FPGA que llega firmado por Intel y que curiosamente está fabricado por TSMC a 20 nm, ostentando un voltaje de entre 0,8V y 0,9V para funcionar y con una temperatura para trabajar de entre 0 a 100 ºC. Sin embargo, no se especifica el consumo del mismo.

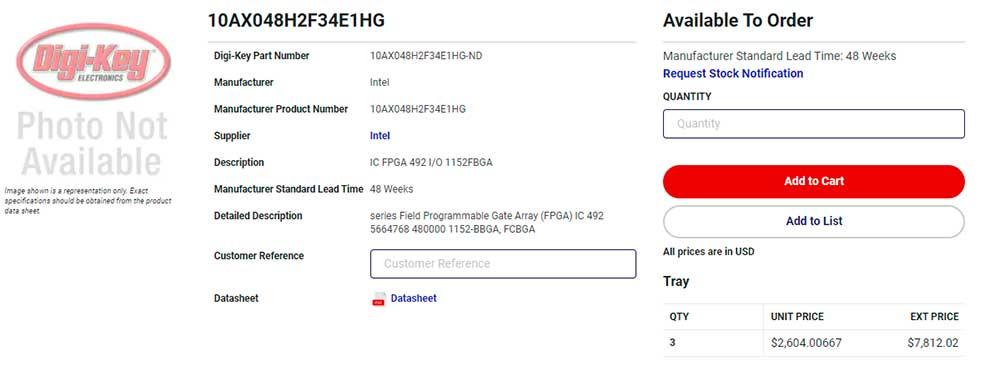

Un precio disparatado para el módulo G-SYNC

Si buscamos dicho chip en cualquier listado de los principales vendedores de componentes para la industria veremos algo realmente sorprendente: 2.604 dólares si decidimos comprar solo uno. Partiendo de la base de que NVIDIA compra literalmente millones de unidades, ¿cuánto puede caer el precio finalmente? No lo sabemos y seguramente jamás tendremos esa información, pero si tenemos en cuenta que actualmente es complicado ver un monitor con módulo G-SYNC por menos de 800 euros… ¿Qué está pasando?

¿Cómo puede NVIDIA ofrecer a los fabricantes una tarjeta MXM con su módulo a un precio interesante y bajo? Si no fuese posible bajar mucho el precio (muchísimo de hecho) ¿quién asume el costo de vender un monitor a precio casi de lo que vale el propio chip?

Y claro, viendo el precio y suponiendo una rebaja brutal por la compra de millones de unidades, ¿por qué NVIDIA no diseña su propio chip FPGA? ¿La compra de ARM puede tener que ver también con esto? Preguntas sin respuesta que de darse los acontecimientos podremos, quizás, conocerlas.

En cualquier caso, puede que ya no nos parezcan tan caros los monitores con G-SYNC después de todo.