NVIDIA G-Sync: os explicamos en qué consiste y cómo funciona

El viernes, NVIDIA presentó su nueva tecnología G-Sync, y considerando los pocos detalles que se saben al respecto hemos considerado necesario redactar este pequeño artículo para explicar de la manera más sencilla posible esta nueva tecnología, en qué consiste y cómo funciona.

Hasta ahora, todo el mundo conocía la sincronización vertical (VSYNC), mediante la cual para un monitor que funciona a 60 Hz de tasa de refresco, se entiende que la tarjeta gráfica tiene que renderizar 60 FPS para una experiencia óptima de juego y visual. Este es el motivo por el cual los FPS en los juegos son tan populares, la gráfica renderiza cada fotograma en línea con la tasa de refresco del monitor que se esté utilizando. Obviamente, esta es una situación ideal, y en el 90% de las situaciones no se llega a cumplir del todo debido a dos temidos efectos: stuttering y tearing (no os preocupéis que ahora os explicamos en qué consisten ambos fenómenos).

¿Qué ocurría hasta G-SYNC?

La tarjeta gráfica siempre está tratando de arrojar tantos fotogramas por segundo como les es posible, pero como ya sabéis aunque tengamos unos FPS óptimos configurados, en realidad éstos varían, digamos entre 30 y 80 FPS. La gráfica renderiza una cantidad de FPS dinámicos. Con respecto a lo que nosotros vemos, o más bien el ojo humano ve, esto no se nota demasiado gracias a las tasas de refresco de lo monitores (vamos a seguir con el ejemplo de los 60 Hz). Así pues, tenemos que la tarjeta gráfica renderiza los fotogramas a una velocidad variable y es el monitor el que se encarga de sincronizarlo a un valor equivalente a su tasa de refresco estática.

Es decir, que si nuestro monitor funciona a 60 Hz, los fotogramas ideales mostrados son 60 FPS, pero esto nunca es así dado que la gráfica renderiza los FPS a una velocidad dinámica, variable. Este es el llamado stuttering. Esto causa un problema adicional cuando la gráfica renderiza menos de 60 FPS, ya que los FPS que esta es capaz de procesar varían dramáticamente dependiendo de la carga de la escena del juego que estemos ejecutando. Esto crea el llamado efecto tearing.

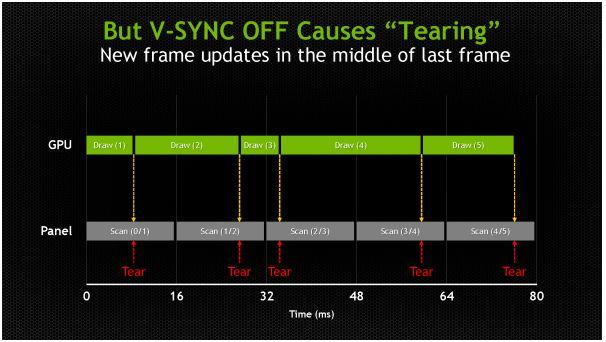

Hasta ahora, estos dos problemas se solucionaban básicamente de dos maneras. La primera es simplemente ignorar la tasa de refresco del monitor y dejar que la tarjeta gráfica renderice tantos fotogramas por segundo como le sea posible, es decir, desactivando la sincronización vertical. En la imagen de abajo podéis ver el efecto real que esto puede tener, donde en un solo ciclo de refresco del monitor se están mostrando dos imágenes y se crea una obvia línea entre ambas.

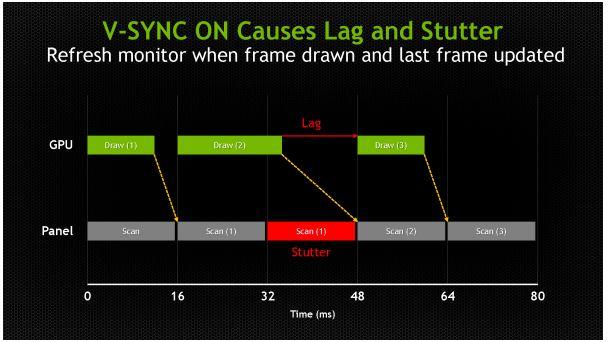

La solución al tearing es activar la sincronización vertical (VSync) para forzar a que la tarjeta gráfica retrase las actualizaciones del monitor hasta que los ciclos de refresco de éste comienzan. Pero claro, este retraso causa stuttering cuando la GPU no es capaz de renderizar estos 60 frames por segundo, y además se aumenta la latencia (el tiempo de respuesta), también llamado input lag.

Es decir, que o tenemos tearing o tenemos stuttering. Este es el motivo por el cual los gamers siempre quieren una tarjeta gráfica lo más potente posible para que sea capaz de procesar al menos 60 FPS en todos los juegos y en todo momento. Con la VSync activada, solo tendremos picos mínimos de stuttering.

La solución es NVIDIA G-Sync

Una vez explicados los actuales problemas, NVIDIA nos proporciona su solución: G-Sync. Tenemos que las tarjetas gráficas renderizan los fotogramas a una velocidad dinámica mientras que los monitores muestran las imágenes a una tasa de refresco estática. Los monitores que están equipados con este hardware adicional (ya habréis visto qué es físicamente G-Sync) se convierten automáticamente en «esclavos» de la tarjeta gráfica, dejando que sea esta la que controle la tasa de refresco del monitor, es decir, que ésta se vuelve dinámica al igual que los FPS. De esta manera, cada vez que la gráfica renderiza un fotograma, automáticamente se alinea con la tasa de refresco del monitor, es decir, ambos estarán en una sincronización constante, por lo que se elimina completamente tanto el stuttering como el tearing.

Pero eso no es todo. Sin stutter ni tearing, incluso en monitores LCD con tasas de refresco de 30 Hz la experiencia de juego será óptima igualmente. De hecho los monitores de gama alta que funcionan a 177Hz también tendrán soporte para G-Sync, así como los monitores de nueva generación con resolución 4K.

¿Y esto tiene algún inconveniente?

En realidad solo uno, y es que si tu tarjeta gráfica es, digamos, «lenta», y no puede renderizar de ninguna manera más de 10 FPS, el juego se verá realmente extraño. Imaginad que en un momento dado de un juego tenemos 4 FPS nada más porque nuestra gráfica no es capaz de renderizar los fotogramas más rápidamente. El juego se verá más o menos como una presentación de powerpoint. Por ello, G-Sync sería recomendado solo para tarjetas gráficas de gama media-alta como mínimo. Eso, o bien siempre podemos configurar los ajustes gráficos de los juegos para tratar de asegurar unos FPS mínimos (recordad que el ojo humano es capaz de captar entre 28 y 34 fotogramas por segundo de media).

Esperamos que este pequeño artículo os ayude a comprender en qué consiste la tecnología G-Sync de NVIDIA. Si tenéis dudas como siempre podéis utilizar los comentarios del artículo para preguntarnos.