Una de las limitaciones que tienen las tarjetas gráficas para PCs de escritorio y portátiles es la incapacidad de poder funcionar en varios sistemas operativos al mismo tiempo o máquinas virtuales. Esta diferenciación que tienen algunas GPU se le llama virtualización y en este artículo os vamos a explicar qué es y que cambios requiere en el hardware.

Antes de la llegada del ordenador personal la gente trabajaba en terminales conectadas a un mini-ordenador central, el cual se encargaba de realizar todas las tareas. Con la llegada de la computación en la nube ejecutando varios sistemas operativos en máquinas virtuales no solo se hace necesaria la virtualización en CPUs, sino también en GPUs.

¿Por qué es necesaria la virtualización en GPUs?

La virtualización es la capacidad que tiene un hardware de crear varias versiones de sí mismo para que lo pueden utilizar varias máquinas virtuales. Por ejemplo una parte de una CPU que haya sido virtualizada será vista por un sistema operativo corriendo en una máquina virtual, mientras que otras máquinas virtuales verán otras partes de la CPU como una CPU única y diferenciada. En ese caso hemos virtualizado la CPU, ya que hemos creado una versión virtual de cada sistema operativo que se ejecuta en el sistema.

En el caso de las GPUs las listas de comandos para gráficos y computación se escriben en ciertas partes de la memoria en concreto y en general las GPUs que montamos en nuestros PCs están pensadas para funcionar en un solo sistema operativo sin ninguna máquina virtual por el medio.

Este no es el caso de las tarjetas gráficas para centros de datos, donde habitualmente se ejecutan varias instancias distintas, máquinas virtuales, de un sistema operativo y se hace necesario para cada cliente acceder a la GPU. Es en este caso donde se hace necesaria la virtualización en GPUs

Virtualización desde el lado de la GPU

Las GPUs también necesitan cambios a nivel de hardware a la hora de soportar virtualización. Debido a esto las tarjetas gráficas con esta capacidad suelen venderse solo para mercados lejanos al de los PCs de escritorio y tienen por ello un precio mucho más alto que las GPUs para escritorio. A día de hoy se puede contratar la potencia de una GPU en la nube para acelerar ciertos trabajos científicos, renderizar una escena remotamente para una película o una serie, etcétera.

SR-IOV

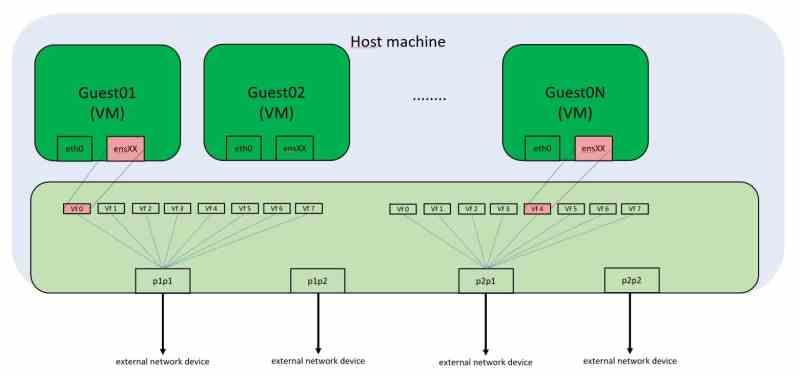

Cada periférico PCI Express tiene una dirección de memoria única en el mapa de memoria de cada PC. Lo que hace que si estamos utilizando un entorno virtualizado no podamos acceder muchas veces al hardware que está conectado a estos puertos como lo son las tarjetas gráficas. Habitualmente las máquinas virtuales que ejecutamos en los PCs de escritorio no tienen la capacidad de utilizar la tarjeta gráfica, la cual será solo accesible para el sistema operativo huésped.

La solución a esto es el SR-IOV, el cual virtualiza el puerto PCI Express y permite que varias máquinas virtuales puedan acceder de manera simultánea a dichas direcciones de memoria. En el PC la comunicación los periféricos es hace a través de llamadas a ciertas direcciones de memoria. Aunque a día de hoy esas llamadas no corresponden a direcciones de memoria físicas, sino virtuales, la regla inviolable es que el contenido de una dirección de memoria no puede ser manipulada por dos clientes al mismo tiempo, ya que entonces hay conflictos en cuanto al contenido de los datos.

El SR-IOV para funcionar necesita un controlador de red integrado en el dispositivo PCI Express, en el caso que nos ocupa la tarjeta gráfica, el cual recibe las peticiones de las diferentes máquinas virtuales que necesitan acceso a sus recursos.

Cambios en las unidades DMA para virtualización en GPU

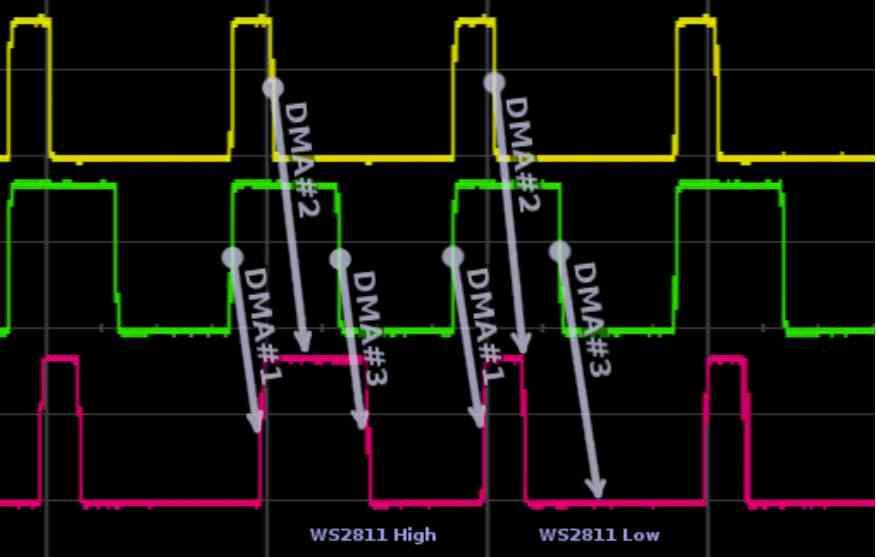

El primer cambio se produce en las unidades DMA, estas unidades suelen venir en pares en las GPUs que utilizamos en los PCs y le dan acceso a la RAM del sistema, no confundir con la VRAM, a través de un canal alternativo. En cada fotograma la GPU que acceder a leer la lista de pantalla en una parte de la RAM o tendrá que copiar los datos desde la RAM a la VRAM por si necesita esos datos más tarde. Para ello se utiliza una unidad DMA en cada dirección. ¿En el caso de las GPUs con virtualización? Utilizan varias unidades DMA en paralelo o una unidad DMA con varios canales de acceso simultáneos.

El uso de los diferentes canales por parte de las GPUs virtuales es gestionado por el controlador de red integrado, el cual se encarga de gestionar las peticiones a memoria RAM, ya sea de forma física o a otro periférico también conectado al puerto PCI Express. Por lo que si las diferentes GPUs virtuales han de acceder por ejemplo a un disco SSD lo hacen a través de las unidades DMA.

Cambios en el procesador de comandos de la GPU

El segundo cambio es en el procesador de comandos. Todas las GPUs de cara a la computación sin gráficos por el medio están acostumbradas a trabajar en varios contextos al mismo tiempo, esto es debido a que son listas de comandos muy pequeñas que se solucionan en poco tiempo, en cambio si hablamos de gráficos la cosa cambia por completo, ya que se suele utilizar una única lista de comandos.

¿Qué ocurre en las GPUs sin virtualización que utilizan varias pantallas? No es lo mismo que utilizar varios sistemas operativos en máquinas virtuales, ya que la lista de pantalla viene en estos casos de un solo sistema operativo que le indica a la GPU la salida de vídeo por la cual ha de transmitir cada imagen.

Por lo que se hace necesario la implementación de un procesador de comandos gráficos especial, el cual trabaja en conjunto con las unidades DMA y el controlador de red integrado para funcionar no como una GPU, sino como varias distintas y de forma virtual.

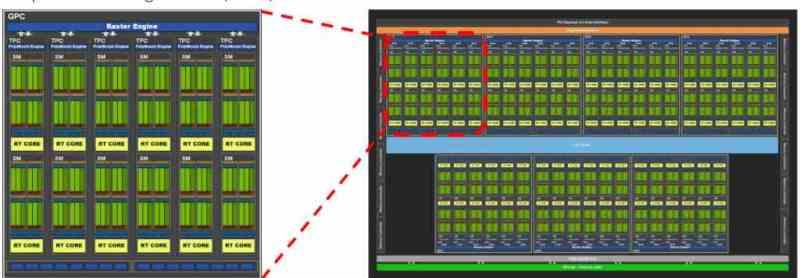

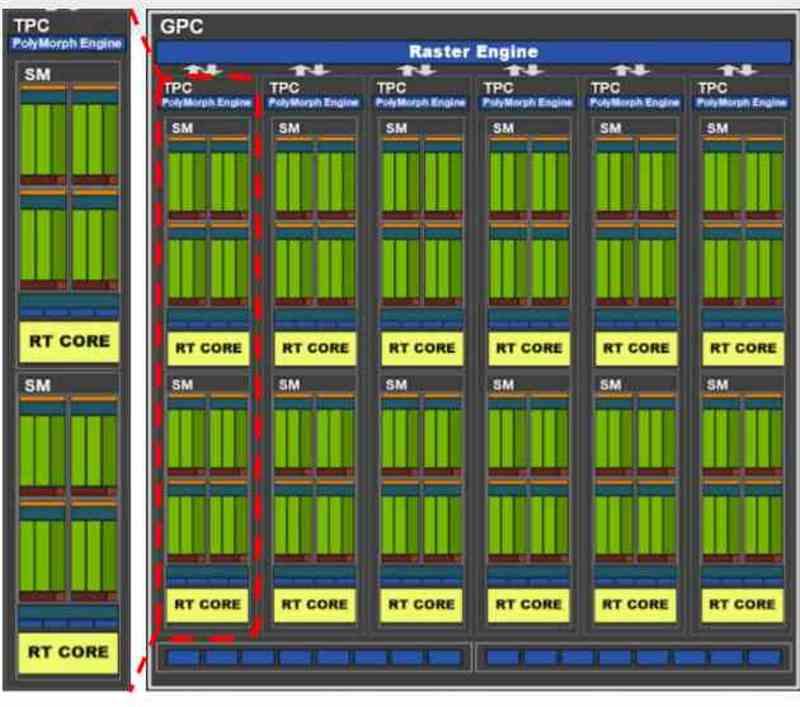

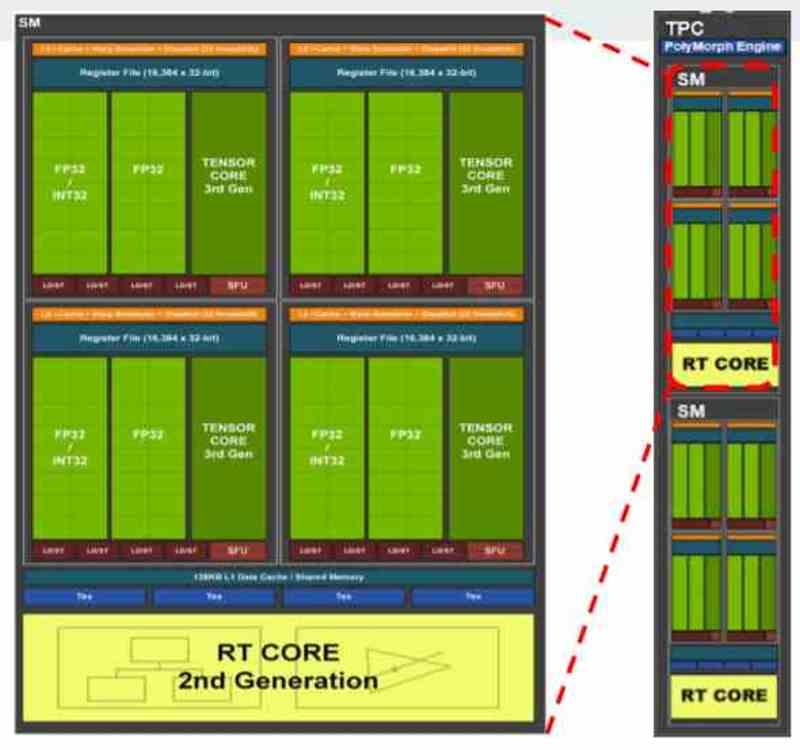

Los recursos de la GPU se distribuyen en virtualización

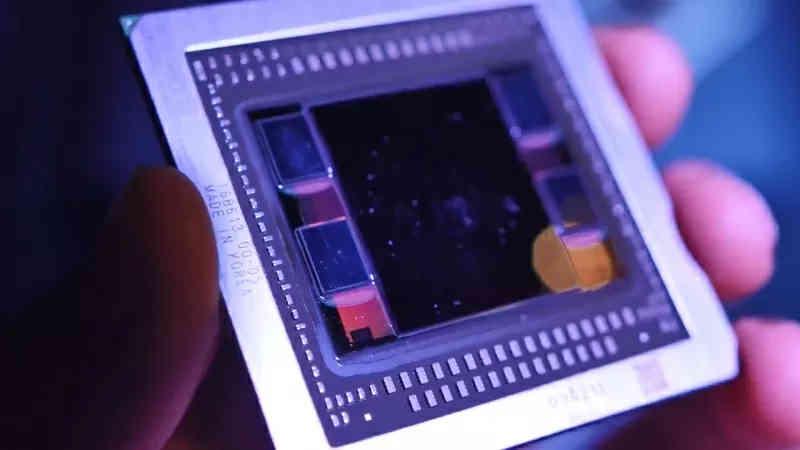

Todas las tarjetas gráficas contemporáneas suelen dividirse en varios bloques dentro de otros bloques, por ejemplo si tomamos la GA102 de las NVIDIA RTX 3080 o 3090 veremos que de entrada esta compuesta por varios GPC, dentro de la cual hay varios TPC y en cada TPC tenemos 2 SM.

Dependiendo de como se haya planteado la distribución de los recursos por parte del fabricante nos podemos encontrar con una distribución en el que a cada máquina virtual le corresponde un GPC, por lo que en el caso de la GA102 estaríamos hablando de una virtualización de la GPU en 7 distintas. Aunque también sería posible hacerlo a nivel de TPC, en ese caso se pueden crear hasta 36 máquinas virtuales, pero como se entiende la potencia para cada una sería muy distinta.

En las GPUs se asigna lo que en NVIDIA es una GPC al completo o lo que en AMD se conoce como Shader Engine, ya que cada una de estas partes tienen todos los componentes necesarios para funcionar como una GPU por sí mismos. En los casos en los que la GPU virtualizada no se usa para renderizar sino para computación entonces la distribución es a nivel de TPC o su equivalente en AMD RDNA, los WGP.