El robo de información de los servidores de NVIDIA ha aumentado el ruido previo al lanzamiento de su próxima generación de tarjetas gráficas para gaming. Y es que entre otras cosas ha servido para que tengamos la información sobre ellas semanas o meses antes de que empezarán a filtrarla. ¿Las últimas habladurías? Se habla de soporte GDDR7 para las RTX 40. ¿Es verdad o estamos ante una malinterpretación de los datos?

Los rumores acerca de la siguiente generación de gráficas GeForce, y la tercera bajo las siglas RTX, se están disparando a la espera de su presentación que podría hacerse este año. Y es que al igual que las olimpiadas y los mundiales cada cuatro años parece que se ha hecho tradición que cada dos años tengamos nueva arquitectura. El último de todos habla del uso de memoria GDDR7 para la RTX 40, lo cual en teoría sería clave para poder alcanzar el doble de rendimiento respecto a la RTX 30 en rasterización e incluso más con el Ray Tracing.

Memoria GDDR7 en las RTX 40, ¿es eso posible?

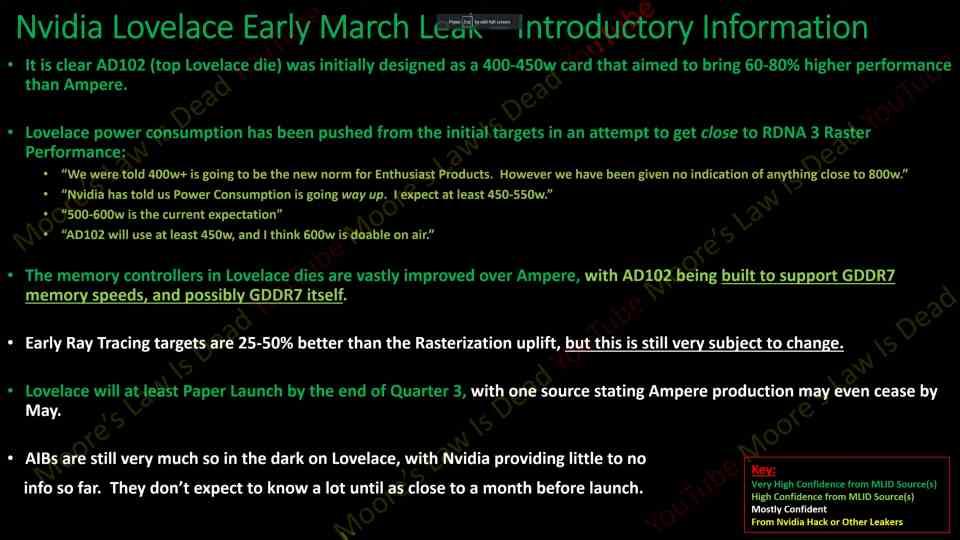

Por lo visto NVIDIA habría mejorado los controladores de memoria en las RTX 40 para darles la capacidad de soportar velocidades de hasta 32 Gbps, las cuales se esperan para la GDDR7 e incluso se dice que este tipo de memoria podría ser soportada por el mismo para las futuras RTX 50. Esta atrevida afirmación parte de un problema bien claro y es que el estándar de la JEDEC de la GDDR7 no se ha finalizado y, por tanto, no existen las especificaciones completas y finales para crear un controlador y una interfaz de memoria con la misma.

Otra cosa es poder alcanzar los 32 Gbps, y aquí hemos de partir del hecho de que el consumo a doble de velocidad de reloj en cualquier dispositivo semiconductor se cuadriplica si tenemos voltaje constante. ¿El problema? Llegar a ciertas velocidades requiere más voltaje y, por tanto, el consumo es aún más alto que ese x4. Es por ello que en esos casos es preferible tener más pines de conexión para datos, bits por ciclo de reloj, que no aumentar la velocidad. No olvidemos de paso que esto también es un aumento considerable del TDP.

Se ha de tener en cuenta que uno de los motivos por los cuales la GDDR6X consigue alcanzar velocidades de hasta 21 Gbps sin llevar el consumo hacia arriba es por el uso de la codificación PAM4 en vez de la clásica NRZ, lo que le permite funcionar a menos velocidad de reloj y, por tanto, consumir menos y requerir menos voltaje. Esto no lo sabemos, pero es posible que en vez de GDDR7 las RTX 40 continúen con el empleo de la GDDR6X o adopten la GDDR6+ de Samsung.

¿Se ha visto NVIDIA forzada a aumentar la velocidad de la memoria?

Con relación a la sección anterior es posible que las RTX 40 necesiten un ancho de banda concreto que no pueden conseguir con los buses que les han sido asignados. ¿La causa? El alto precio del nodo de 5 nm de TSMC que habría hecho que NVIDIA recorte el área de sus chips limitando el perímetro y los controladores de memoria. ¿La consecuencia? velocidades para la memoria más grandes para compensar y con mayor consumo.

Ya no se habla de 800 W de consumo

Poco a poco los rumores se salen de lo imposible para acercarse más a la realidad y es que no olvidemos que la arquitectura Lovelace de las RTX 40 lleva en desarrollo desde mucho antes de que el conector PCI Express 5.0 de 600 W se hiciera oficial. Por lo que el objetivo inicial de NVIDIA para su tarjeta gráfica top es que esta funcionase en un entorno de 450 W desde el principio. La posibilidad de utilizar un mayor consumo con el conector 12+4 tiene que haber permitido mejorar la velocidad de reloj de GPU y memoria, pero también replantearse todo el sistema de alimentación y refrigeración de la misma.

Por no decir que a partir de ciertos consumos es necesaria la refrigeración líquida, lo cual es un encarecimiento. Esto no significa que no vaya a existir una RTX 40 de 600 W o posiblemente más, pero creemos que NVIDIA va a querer aprovechar en lo máximo el conocimiento adquirido y la infraestructura para crear la RTX 3090 Ti. Lo cual a nivel de costes y fabricación a gran escala tiene toda la lógica del mundo.

Ya para terminar, no tiene sentido que una arquitectura de la que se dice que es una continuación de las actuales RTX 30 y que va a hacer un salto de casi dos nodos de fabricación, si tenemos en cuenta que parte de los 8 nm de Samsung, acabe siendo menos eficiente. Más bien la lógica marca que el aumento en el consumo vendría por la VRAM utilizada.