De las tres grandes compañías de hardware es AMD la que parece estar más fuera del mundo de la inteligencia artificial. No obstante esto no significa que los de Lisa Su no estén interesados en este lucrativo y en constante evolución campo del hardware. Esto lo demuestra una patente publicada recientemente donde hablan de un procesador neural apilado para IA. ¿A qué se refieren exactamente?

Por el momento la única implementación de hardware para la inteligencia artificial son las Matrix Core Unit en las GPU CDNA para la computación de alto rendimiento. En el caso de las GPU actuales, RX 6000 con arquitectura RDNA 2, dicho tipo de unidades no se encuentran en su interior y no hay referencias de su implementación para RDNA 3.

Pues bien, la respuesta podría estar en un procesador neural apilado encima de la GPU e incluiría tanto memoria caché de último nivel como una CPU dedicada en su interior.

El procesador neural apilado de AMD

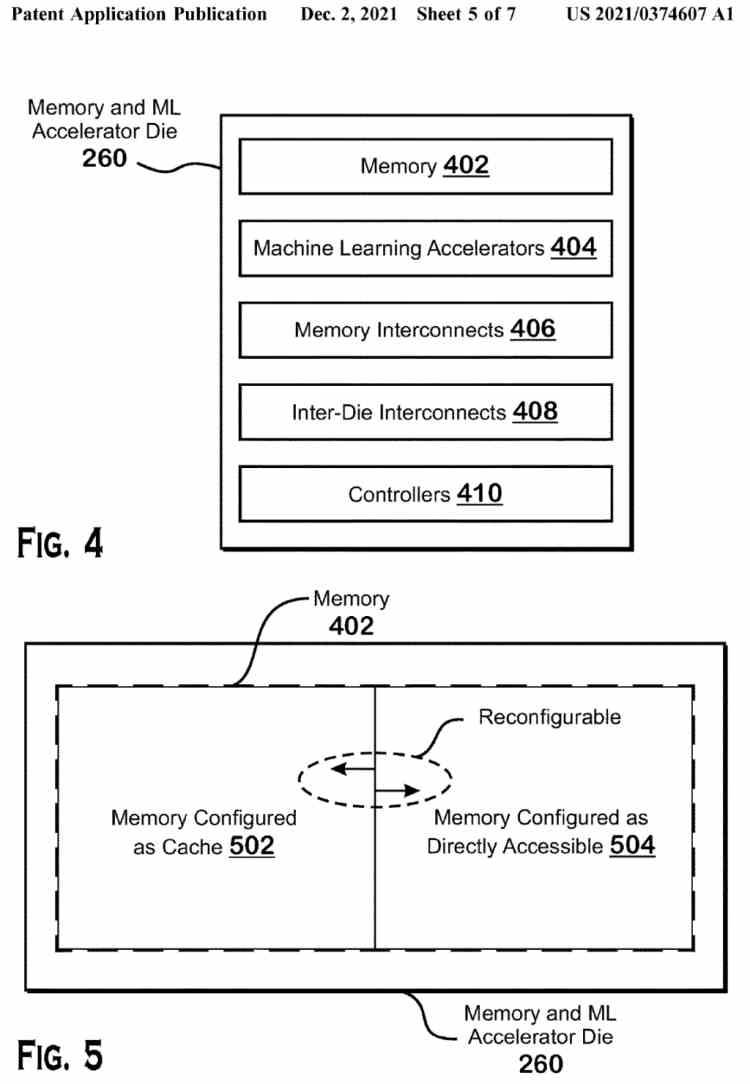

Bajo el título de Stacked Dies For Machine Learning Accelerators, AMD ha publicado una patente que nos describe un chip de memoria con procesador neural integrado que iría encima de sus GPU. Lo cual sería una evolución de la V-Cache utilizada en sus CPU Ryzen, pero que estaría pensada para sus procesadores gráficos y por tanto para aumentar la capacidad de la Infinity Cache. ¿La particularidad? La implementación de un procesador neural para la IA en el otro extremo de la pila.

En realidad una variante de esta patente con configuraciones 2,5DIC ya se publicó hace unos meses, y es que como en dicha patente podemos ver la memoria apilada puede ser configurada como caché o RAM normal, para así permitir su uso por parte del procesador neural. No olvidemos que este tipo de procesadores requieren un alto ancho de banda para funcionar.

¿Cómo es que AMD no lo va a integrar dentro de las Compute Units de su GPU? Pues lo desconocemos, no obstante, algo nos dice que es una forma por parte del Radeon Technology Group para acelerar la implementación de este tipo de unidades en sus GPU lo más rápido posible y sin tener que devolver el resto del chip a la mesa de diseño.

Diferencias con los Tensor Cores de NVIDIA

Los Tensor Cores de NVIDIA son arrays sistólicos integrados en las unidades shader de la GPU y que comparten recursos con el resto de unidades de ejecución como son registros, cachés y accesos a estos. En cambio, el procesador neural apilado de AMD sería un acelerador que se sumaría a los utilizados como controlador de pantalla, códec de vídeo por hardware, etcétera. Por lo que esto significa que el procesador neural de AMD al contrario de los Tensor de NVIDIA podrá funcionar en paralelo al no compartir los recursos dentro de la GPU.

Ya para terminar, no sabemos cuál será la potencia total del procesador neural apilado de AMD en comparación con lo que tenemos ahora en el mercado. No obstante la construcción de un chip 3DIC es siempre caro y no olvidemos que RDNA 3 será la primera GPU para gaming de AMD basada en chiplets, por lo que complicarla demasiado su diseño.

¿Veremos su implementación en las próximas GPU Gaming de AMD? Quien sabe, solo el tiempo nos lo dirá. ¿Quizás para RDNA 4? Es más que probable viendo la fecha de publicación de la patente.