La AMD Instinct ha destrozado todo lo visto hasta ahora y ha supuesto un golpe en la mesa tan brutal que eclipsar como término al referirse a ella puede quedarse corto. Es cierto que es una GPU destinada a DL, pero es un esbozo por otra parte de lo que nos espera con RDNA 3 (en teoría al menos y salvando las distancias). La respuesta de NVIDIA ha visto hoy la luz en forma de una tarjeta gráfica llamada misteriosamente GPU-N, la cual es extremadamente peculiar y estaría por detrás de AMD pero…

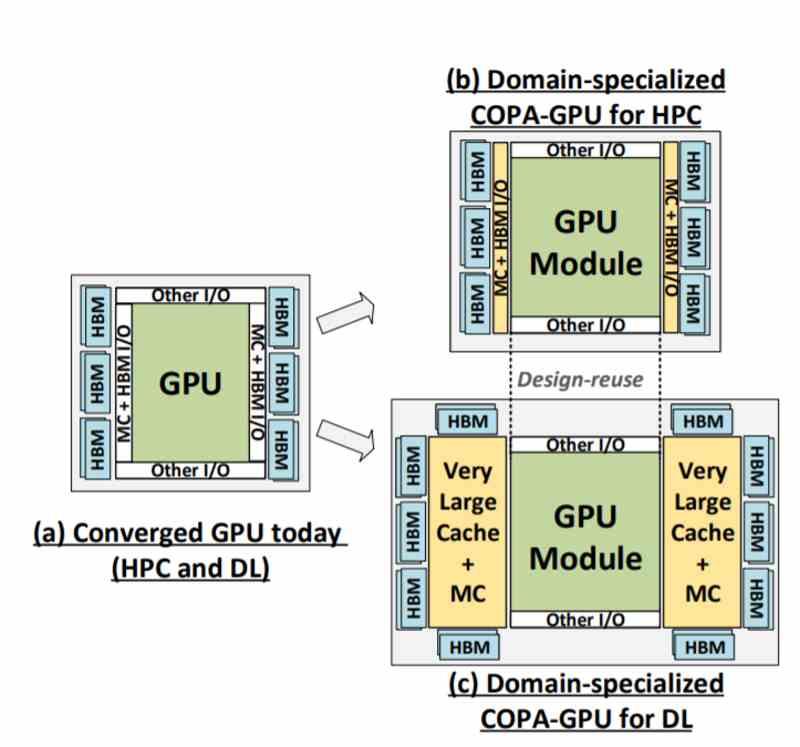

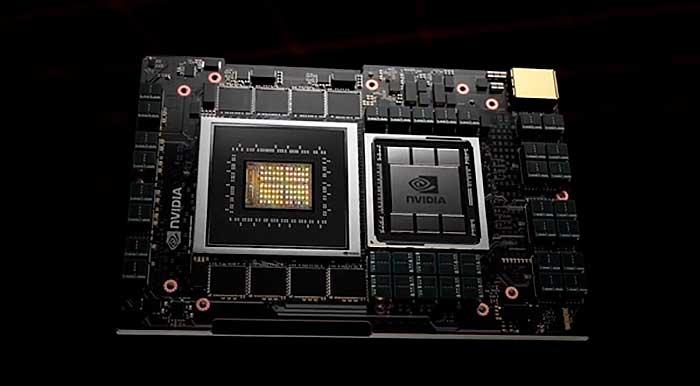

Han pasado muchos meses (abril) desde que habláramos de las llamadas COPA-GPU Exascale de NVIDIA, que no es otra cosa que la denominación que los de Huang le dan al llamado Composable On Package, un circuito integrado 2.5DIC o 3D (dependiendo del diseño en concreto, nada novedoso hay que añadir) que llegaría con la arquitectura Hooper.

Con esto en mente se ha filtrado lo que podría ser el nuevo chip GH100 basado en esta nueva arquitectura dedicada a DL e IA, sobre todo el primero, donde como ya sabemos se prima el rendimiento matemático matricial de baja precisión, o dicho de otro modo, FP16. Dicho chip se ha especificado con GPU-N y lo visto desde luego no decepciona si no olvidamos su fin.

Dos diseños, dos objetivos, una arquitectura

Solo por repasar lo que vimos a principios de año, lo que NVIDIA pretende es lanzar dos arquitecturas distintas enfocadas a cada propósito:

- Gaming -> Ada Lovelace

- DL e IA -> Hooper (MCM y monodie)

Pero dentro de esta última habrá dos diseños distintos de GPU que serán COPA y que se diferencian por sus capacidades y enfoques. Esta supuesta GPU-N estaría enfocada a DL y por ello sería la sustituta natural de la actual NVIDIA A100, lo cual es importante para comprender los datos que vamos a ver ahora, ya que no es una GPU MCM como tal, sino uno de los módulos en exclusiva, por lo que se comprende que habrá tarjetas gráficas multi die y mono die.

¿Por qué GPU-N está por detrás de AMD?

https://twitter.com/Redfire75369/status/1470607260715917317

Esta tarjeta gráfica es mono die, por lo que de entrada va a ser más lenta que la MI250X, pero es que además su objetivo no es la IA como tal, donde para ello si encontraríamos diseños MCM, esto es distinto, es un mercado más específico.

GPU-N tendrá 134 SM, lo que de mantenerse la estructura actual en Shaders de NVIDIA con Ampere nos daría nada menos que 8.576 Cores, o lo que es igual, un +24% frente a su predecesora. Dados estos datos se especula lógicamente con los 5 nm de TSMC, pero la frecuencia en cambio se mantendría en 1,4 GHz, curioso cuanto menos. Lo que sí cambiará es su L2 que se verá aumentada a 60 MB (+50%) que junto con el aumento a 100 GB de HBM2E que tendrá nos daría un ancho de banda (a misma frecuencia se entiende) de 2,68 TB/s.

Esto es debido al ancho de banda de 6144 bits, lo que podría significar tamaños de más del doble de capacidad en memoria. El problema de todo esto es que la comparativa con la MI250X no es realmente justa aunque compartan ciertos parecidos, ya que esta GPU-N conseguiría 24,2 TFLOPs en FP32, solamente un 24% más que la GPU a la que sustituye.

En cambio, logra 2,5 veces el rendimiento en FP16 con 779 TFLOPs y aquí está lo importante por el sector donde va dirigida. La AMD Instinct MI250X consigue 95,7 TFLOPs en FP32 y 383 TFLOPs en FP16 (-2,15x).

Un chip de gama media-alta

https://twitter.com/Redfire75369/status/1470607263245029377

Estos datos lo que evidencian es que no estamos ante la GPU más rápida para DL de NVIDIA, puesto que se espera que la configuración completa del die tenga 144 SM y no 134. Esto lo sabemos por las filtraciones del supuesto H100 que este sí es el encargado de competir contra la MI250X de AMD en base a 288 SM con interposer y 18.432 Shaders.

Así que ahí veremos el potencial de la arquitectura, pero por ahora los datos son prometedores para este sector y no están lejos de la mejora de 3x que hemos ido comentando según las filtraciones. Hasta que sea presentada como bien sabemos cualquier parecido con la realidad es pura coincidencia, así que cojamos estos datos con un poco de sal y tengamos paciencia, ya que podría ser presentada en el CES2022.