Una de las cosas que más preocupan a nuestros lectores son las noticias del aumento en el consumo energético en el hardware. En especial con las noticias del potencial aumento de la factura de la luz por las tarjetas gráficas. Y es que el motivo de ello es que muchos modelos necesitarán usar el nuevo conector de 12+4 pines, conocido como ATX12VO, con la capacidad de alimentar a la gráfica con 600 W de potencia. ¿Debemos preocuparnos realmente por el aumento de la factura de luz por nuestra tarjeta gráfica, o se trata de una exageración?

Una de las limitaciones en cuanto al diseño de hardware con el que se enfrentan los diseñadores de hardware es el consumo energético. Se busca siempre poder llegar a cierto rendimiento bajo un presupuesto concreto. ¿El problema? Los usuarios buscamos siempre la tarjeta gráfica que nos dé mayor cantidad de frames en nuestros juegos favoritos, así como una mejor calidad gráfica. Lo que provoca que cada cierto tiempo la cantidad de energía consumida tenga que subir.

¿Por qué tu tarjeta gráfica encarecerá la factura de la luz?

De todos los componentes que se encuentran dentro de tu ordenador, el que tiene un impacto más alto sobre la factura de luz es la tarjeta gráfica. No en vano, mientras que en el caso de un procesador central consumiendo cerca de 200 W se considera exagerado, en el caso de la tarjeta gráfica esto se considera algo normal. Incluso tenemos modelos que se acercan a los 400 W y pronto tendremos el uso del conector ATX12VO o de 12+4 pines que puede duplicar el consumo y, por tanto, hacer que el tener encendida nuestra tarjeta gráfica nos cueste el doble.

La GPU central aumentará su consumo energético

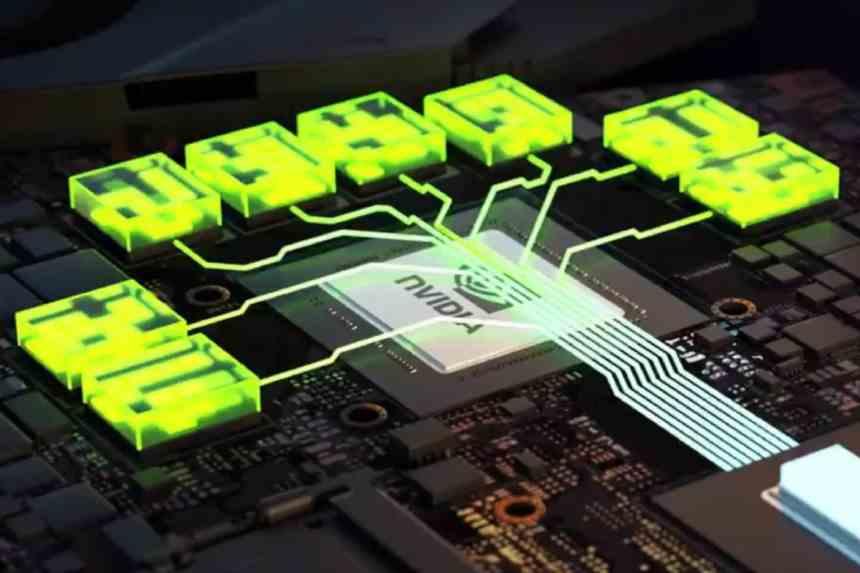

El principal componente de toda tarjeta gráfica es su GPU central, las cuales en comparación con un procesador central se componen a día de hoy de decenas de núcleos e incluso hay casos que ya van por los cientos. En todo caso, hemos de partir de la idea de que se trata del generar gráficos es una tarea que requiere de un gran paralelismo. Por ejemplo, si tenemos que generar una imagen en Full HD tendremos 2 millones de píxeles que tratar simultáneamente y si hablamos de una resolución 4K entonces la cosa sube a los 8 millones.

Debido a que cada píxel o cualquier otra primitiva gráfica para componer la escena es independiente al resto, es cuando un diseño con una gran cantidad de núcleos se hace importante. Claro está, que con un presupuesto fijo en lo que a consumo energético se refiere. Así pues, de una generación a otro, los ingenieros de Intel, AMD y NVIDIA se han de romper la cabeza para poder colocar una mayor cantidad de núcleos bajo un mismo presupuesto y poder alcanzar mayores velocidades de reloj. Esto era posible gracias a los efectos de adoptar un nuevo nodo de fabricación, sin embargo, esto se ha convertido en el factor limitante y se quieren alcanzar ciertas tasas de rendimiento, es necesario aumentar el consumo de las tarjetas gráficas.

Para entenderlo mucho mejor, pensad en un barrio de casas que se renuevan cada cierto tiempo. En el que poco a poco no solo se van aumentando la cantidad de viviendas, pero bajo la misma central eléctrica. Llegará el punto en que será necesario renovarla para poder darle electricidad a todas.

La memoria VRAM también juega un papel importante

Aparte del chip gráficos tenemos una serie de chips de menor tamaño que están conectados a la GPU y que le sirven como memoria para almacenar datos e instrucciones. Este tipo de memorias se diferencian de las que usamos como RAM central en el hecho de que le dan más importancia a la cantidad de datos que pueden transmitir por segundo que al tiempo de acceso a los datos. Pues bien, esto es uno de los problemas de cara al consumo y que nos va a llevar a la adopción de memorias caché de gran tamaño dentro del chip central de la gráfica con tal de recortar el coste energético de acceso a los datos.

El problema es que los volúmenes de información necesarios que ha de manejar la gráfica son tan grandes que es imposible colocar tal cantidad de memoria dentro del chip. Por lo que continuamos necesitando memoria externa. Aunque el objetivo a futuro es ir aumentando el tamaño de las cachés de último nivel hasta el punto en que se llegue al punto en que cerca del 100% de las instrucciones tengan un consumo de menos de 2 picoJoules por bit transmitido. ¿Lo que consumen las memorias VRAM? Pues en la actualidad 7 picoJoules por bit transmitido, pero la cosa se podría ir a los 10 en un futuro.

Teniendo en cuenta que el consumo energético, medido en vatios, es la cantidad de Joules por segundo, entonces queda muy claro el problema. Además, a medida que se aumenta la complejidad gráfica en los juegos y con ello el número de núcleos también lo hace el ancho de banda necesario.

Tú factura de la luz no subirá tanto como con tu futura tarjeta gráfica

Si te preocupa el aumento de la factura de la luz por tu tarjeta gráfica, entonces deja que te tranquilicemos un poco. Solo los modelos tope de gama que estarán pensados para ejecutar juegos a 4K con Ray Tracing activado o con tasas de frames en el término de las centenas van a consumir más que las tarjetas gráficas actuales y, por tanto, van a usar el nuevo conector de 12+4 pines. El resto de las gamas se van a mantener dentro de los consumos actuales, los cuales van de los 75 W a los 375 W.

Por lo que si tu pantalla tiene una resolución de 1080p e incluso a 1440p y buscas jugar a juegos a 60 FPS, entonces no deberás preocuparte por el aumento en el consumo de tu tarjeta gráfica. Ya que no será necesario que compres una que consuma 450 W o más. Más bien, son los más entusiastas, los que quieren el máximo rendimiento a cualquier precio, los que se deberán preocupar más sobre el aumento de la factura de la luz.