Hace apenas una semana avisábamos de las repentinas muertes que estaban sufriendo muchas GPU de la serie RTX de NVIDIA. No es algo ni mucho menos normal, sobre todo teniendo poco más de un mes de vida. El problema se ha extendido a las tres gráficas que NVIDIA tiene en el mercado y hoy sabemos algo más sobre el problema y sus posibles causas: ¿es la GDDR6 la culpable?

NVIDIA habla de un problema no generalizado y Micron no se pronuncia

Cuando una GPU se rompe el usuario necesita buscar culpables, sobre todo si no ha habido mala praxis por su parte. Pero si encima la tarjeta en cuestión supera por mucho el SMI en un país como el nuestro, puede ser que el enfado sea monumental.

Donde algunos medios han apuntado a un problema de NVIDIA nosotros vamos a dirigir dicho problema a unos datos que llevamos recopilando durante el fin de semana y que sin culpar directamente a nadie, vamos a exponer como posible causa de los males que asolan a las RTX de NVIDIA.

En los foros de NVIDIA y en Reddit muchos han sido los usuarios que estaban reportando fallos de lo más variopinto, pero todos parecían tener un eje común.

Fallos como el que vais a ver en el vídeo de abajo se han sumado a pantallas en negro, reinicios esporádicos, mayor número de artifacts etc …

Por lo que según nuestra experiencia en overclock, dicho tipo de fallos es muy común cuando la memoria de la tarjeta gráfica termina fallando, sea por velocidad o temperatura.

Pero ¿qué hay de cierto en esto? Bueno, para hacer una correcta recapitulación de los datos hemos de discernir con que hardware estamos tratando.

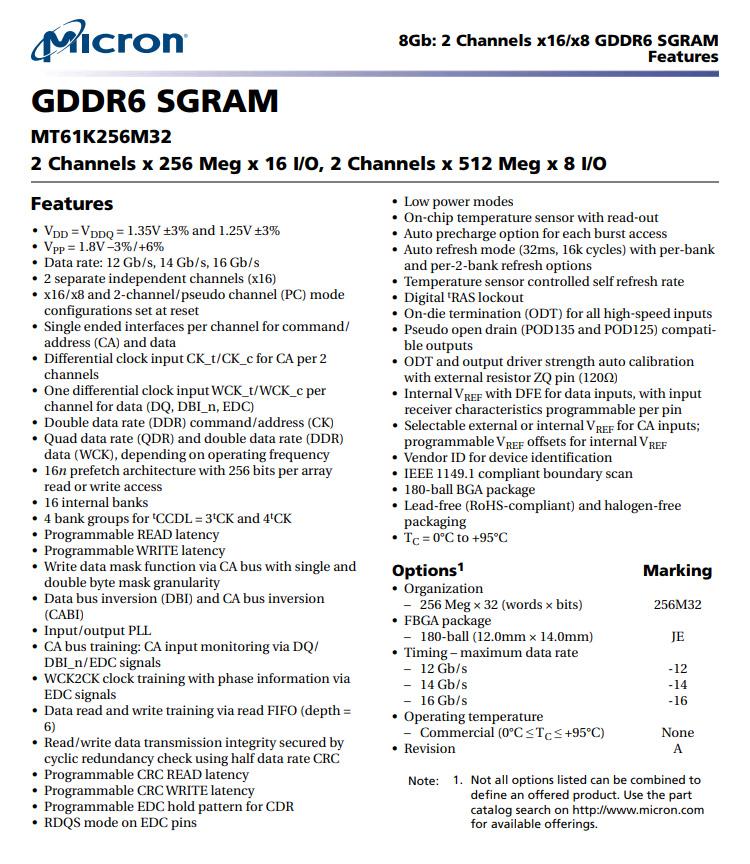

En el caso de toda la serie RTX de NVIDIA el fabricante para todos los AIB o Founders Edition es Micron. Su GDDR6 pasa por tres modelos distintos que comparten muchas similitudes y pocas diferencias, entre ellas la capacidad de sus módulos.

Las similitudes vienen desde el voltaje, pasando por la velocidad o su pinout. En las RTX 2080 Ti la versión de los módulos instalados pasa por el modelo 8RA77 D9WCW (8PA77 en otros modelos), mientras que para las RTX 2080 y RTX 2070 el modelo es la variante 80A77 D9WCW, ambos modelos figuran como MT61K256M32 según la propia Micron.

Si nos vamos a sus datasheet encontramos cosas muy interesantes:

Desde su VDD de 1.35 voltios hasta su VPP de 1.8v pasando por lo que realmente nos interesa, on-chip temperatura sensor with read-out y temperature sensor controlled self refresh rate para terminar en su Tc desde 0ºC hasta +95ºC.

Muchos de estos datos ya los conocíamos, pero el parámetro que entra en debate es la temperatura. ¿Acaso las GDDR6 son capaces de llegar a esta temperatura en una tarjeta gráfica de NVIDIA? Bueno, veámoslo:

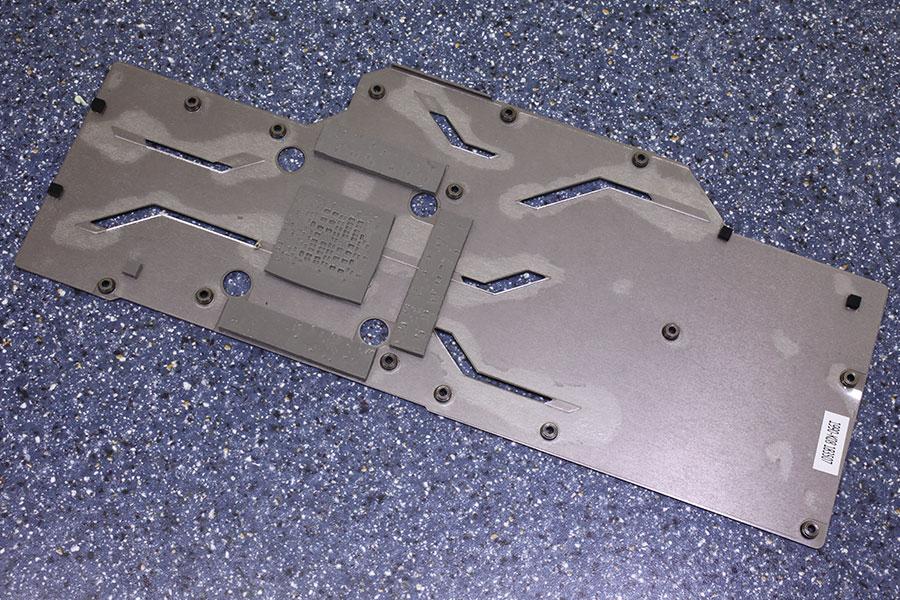

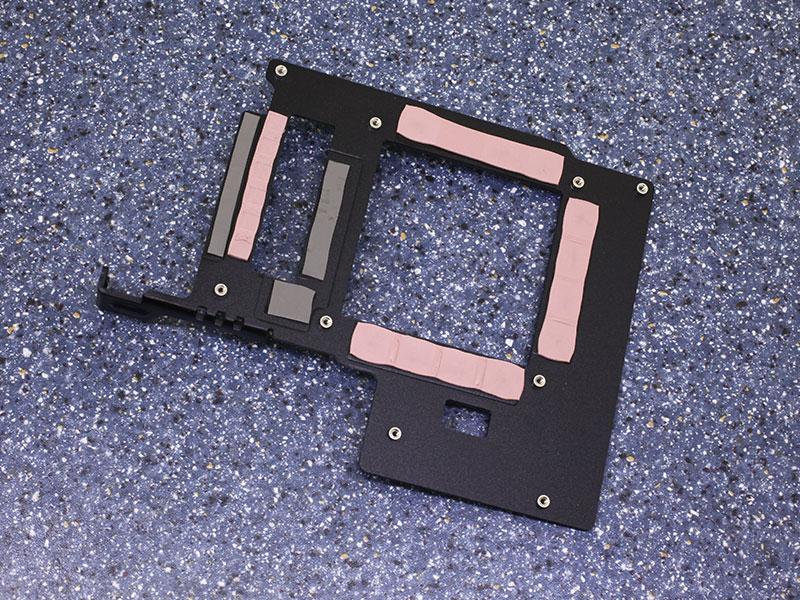

En el caso del vídeo en concreto hablamos de una MSI RTX 2080 Ti Gaming X Trio, un modelo custom muy bien refrigerado y que cuenta con midplate exclusivo para las VRAM GDDR6 y además el apoyo del backplate para refrigerarlas por la parte trasera del PCB, tal y como podemos ver en estas imágenes:

El problema no ha sido detectado como tal hasta ahora debido a que la mayoría de tarjetas se prueban con su configuración por defecto, es decir, si incluye backplate se testea con este, como por otra parte es lógico.

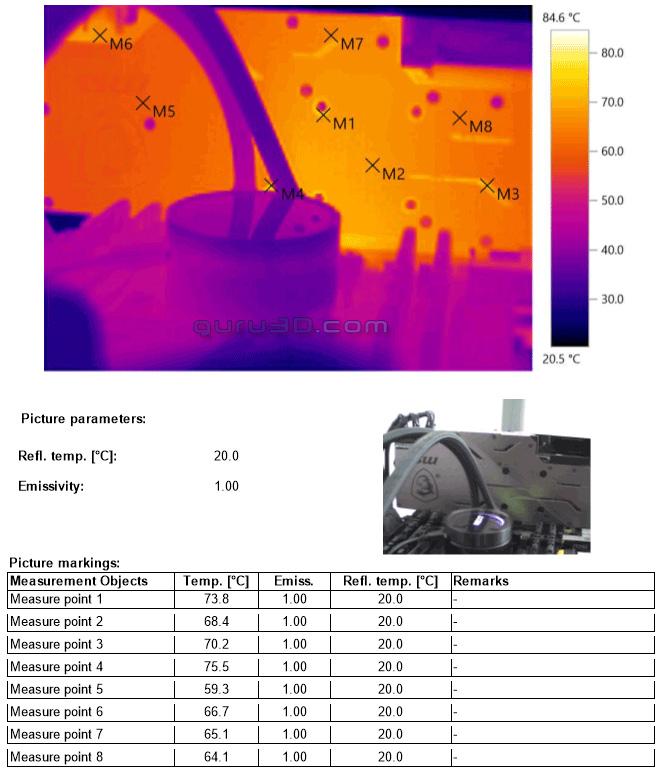

Esto evidencia problemas ocultos que el backplate esconde, como se puede ver en la siguiente captura térmica:

Los backplates ocultan el problema

Así, se aprecia como el punto de medición 4 alcanza los 75,5 ºC que es justo la zona de mayor temperatura disponible ya que centra una de las filas de VRAM y justo al lado tenemos a las fases y VRM:

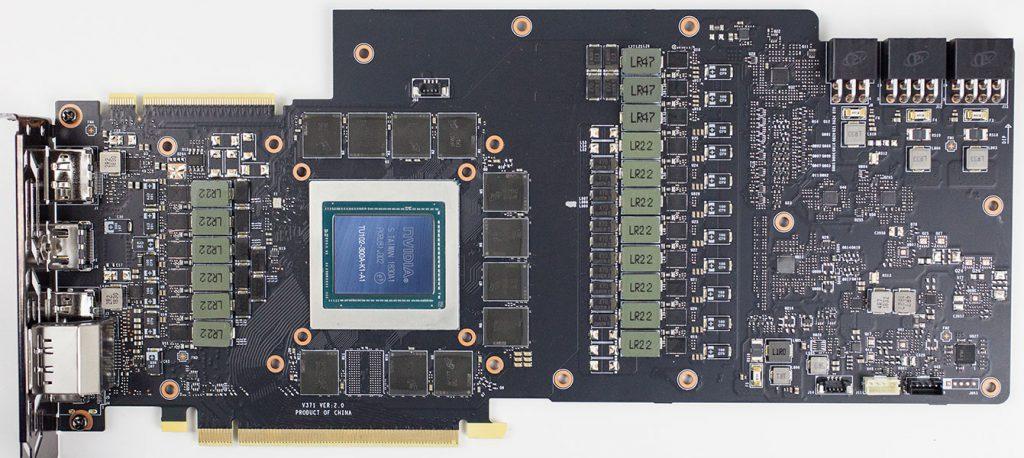

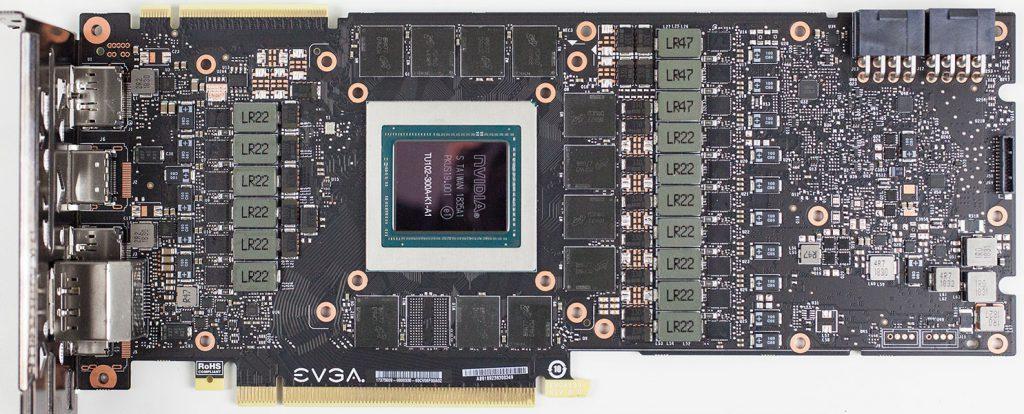

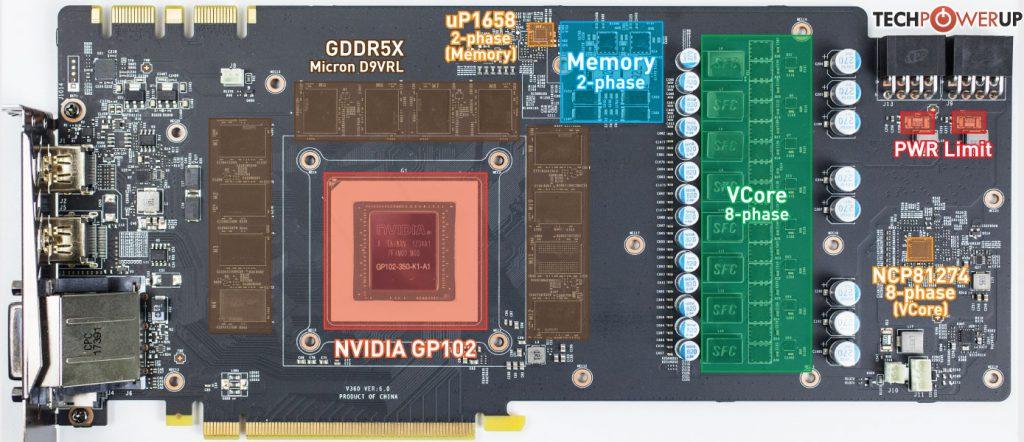

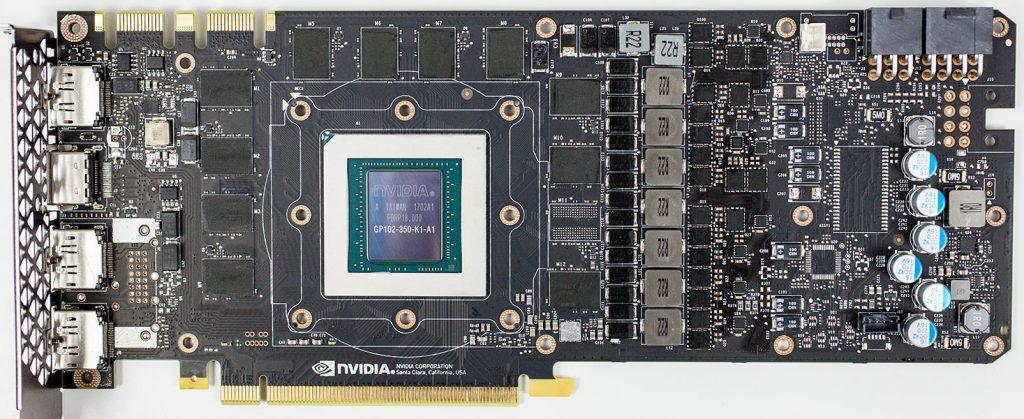

En este caso el diseño de MSI ha priorizado separar lo máximo posible las VRAM de las fases y VRM, pero este diseño no es lo común actualmente, ya sea en otras tarjetas custom como en el PCB de referencia como se muestra justo debajo.

En cambio si nos fijamos en el diseño de las tarjetas homólogas Pascal encontramos una sutil diferencia:

Si miramos la MSI GTX 1080 Ti Gaming X Trio vemos que la distancia es aun mayor y además un detalle marca la diferencia.

En la columna derecha de las GDDR5X el módulo que falta para cumplimentar los 12 GB de las Titan está estratégicamente colocado en todos los modelos GTX 1080 Ti para evitar aumentar el calor y permitir una mejor disipación.

Mientras que como hemos visto en la serie RTX dicho módulo «vacío» se encuentra en la parte inferior de las tarjetas, junto al PCIe.

Esto es un «problema» de diseño de NVIDIA, ya que los fabricantes por norma general no alteran ni la orientación del die ni la disposición de buses o líneas de interconexión con la VRAM, es un diseño cerrado por así decirlo que NVIDIA impone.

Pero entonces ¿qué se puede hacer ante esto?

Lo principal en este tipo de casos es escoger bien a la hora de comprar nuestro modelo, más que nunca la refrigeración cuenta a la hora de alargar o mantener la vida de nuestra GPU.

Pero para los que ya posean alguna de las tres variantes de la serie RTX, existe por lo menos una solución paliativa a corto plazo. Muchos usuarios que han experimentado problemas de los arriba mencionados han afirmado que bajando los clocks de la VRAM GDDR6 manualmente entre 50 y 100 MHz han conseguido evitar los problemas y poder jugar sin artifacts, pantallas en negro o reinicios.

Esto tiene sentido desde el punto de vista de la temperatura, bajar clocks sin duda influye directamente en un menor estrés, consumo y por ende menores grados centígrados en las VRAM.