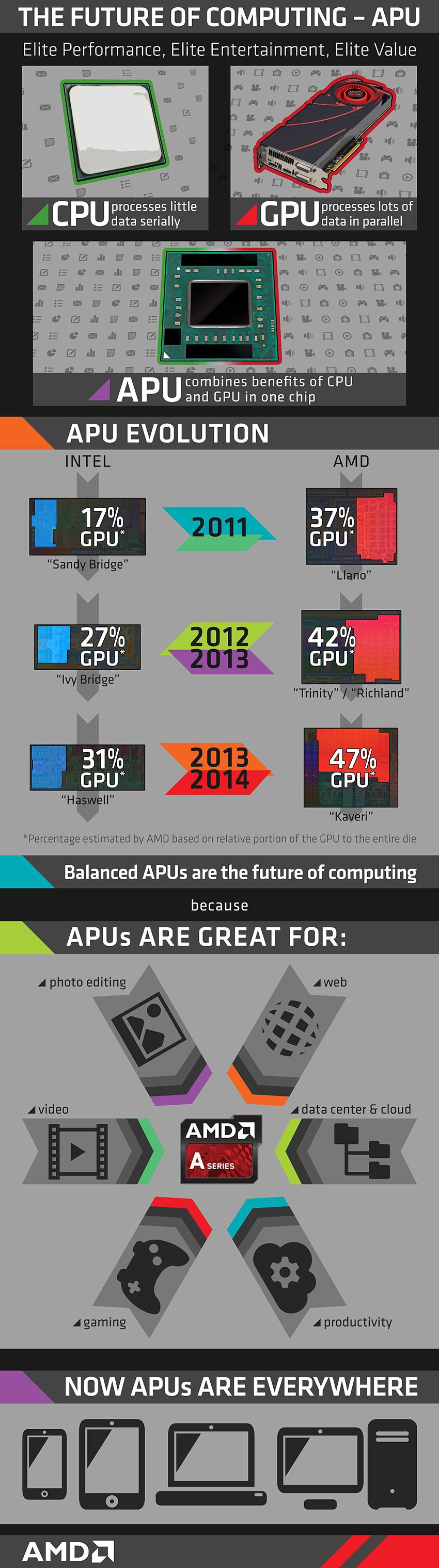

AMD tiene muy claro que el futuro de la informática está en los procesadores que combinan CPU y GPU en un solo chip, es decir, las APUs, y lo muestra en forma de infografía comparando la evolución de éstas con los chips de la competencia. Una vez más vemos una comparativa AMD vs Intel aunque en esta ocasión sin cifras ni rendimiento de por medio.

Un dato es innegable, y es que en esta evolución de las APUs, AMD está tomando ventaja ya que cada vez más porcentaje de sus chips está ocupado para la GPU, y no en vano llevan tiempo desarrollando tecnologías de memoria unificada para CPU y GPU y, de esa manera, mejorar el rendimiento entre ambas y por ende del sistema completo. En esta infografía veremos reflejado este dato, donde allá por 2011 Intel lanzó Sandy Bridge, una arquitectura que contaba con un 17% aproximadamente del chip dedicado a la gráfica integrada, mientras que la arquitectura homónima de AMD de aquella época, Llano, ya contaba con un 37% del chip dedicado para la GPU.

Estemos o no de acuerdo con la visión de AMD, enfocada en hacer ver que las APUs son mejores para todo tipo de usos como indican en la infografía, lo que sí es cierto es que la compañía lleva ya tres años enfocándose precisamente en esto, y según pintan las cosas, parece que de momento no le va nada mal.