Intel rescata del olvido su tecnología Hyper-Threading, adaptada a los tiempos que corren para no ser el fiasco anterior en los tiempos del Pentium 4. ¿Realmente lo han conseguido o es simple marketing? Los chicos de VR-Zone se han puesto manos a la obra.

Un poco de historia.

Antes de nada explicaré brevemente en qué consiste esta tecnología, para los que se hayan incorporado recientemente al mundo del Hardware y desconozcan su función y orígenes.

El Hyper-Threading fue una tecnología lanzada por Intel y que implementó en algunos núcleos de sus Pentium 4 (Northwood, Prescott, Cedar Mill, Prestonia, Gallatin, etc), denominados P4 HT para el gran público.

Es una instrucción del procesador, por la cual 1 núcleo tiene 2 hilos de operación paralelos (en un sistema operativo que lo soporte), es decir, hacer creer al sistema que tenemos 2 procesadores en vez de 1 y agilizar las operaciones.

En teoría la idea era buena, ya que que se reducían los ciclos de reloj vacíos (sin ejecutar ninguna operación) y se ganaba rendimiento al mantener el procesador más operativo. La realidad fue bien distinta, ya que el aumento de rendimiento era pequeño, en torno al 5% en la mayoría de aplicaciones, en alguna hasta un 20% y en otras hasta se perdía rendimiento.

Algunos de vosotros recordaréis como lo desactivábamos para poder hacer overclocking tranquilamente, jeje.

Situación actual:

Intel ha vuelto a implementar el HT en los Core i7, y como veremos a continuación, con resultados dispares según el artículo de VR-Zone:

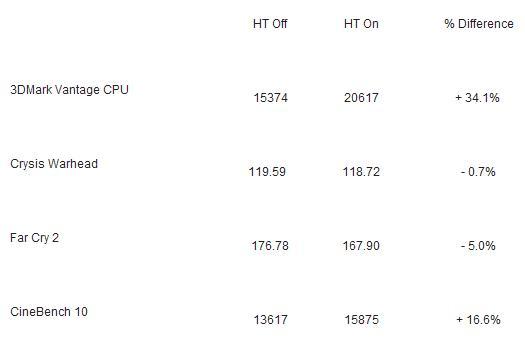

El aumento en 3DMark Vantage tes de CPU es muy notable, 34.1%, también mejora bastante el resultado en Cinebench R10, 16.6%. La parte negativa viene con los juegos, Crysis Warhead y Far Cry 2 ven reducidos sus FPS en un 0.7% y 5% respectivamente.

Podéis ver los benchs detallados en la página original.

Fuente: VR-Zone