Estamos en plena época de tecnología de imagen y realismo sin precedentes en la historia de las televisiones y monitores gaming para el usuario y mercado común. Entre ellas la que más destaca es sin duda el llamado HDR, una tecnología que ya tiene diferentes estándares, pero ¿qué es realmente HDR y por qué es importante tenerlo a la hora de comprar un monitor gaming para jugar?

Antes de comenzar a explicar qué es HDR, debemos tener en cuenta una apreciación que puede no estar realmente clara para el usuario menos entendido sobre este tipo de tecnologías. Y es que HDR no va ligado a la resolución de la televisión o monitor de turno, es decir, HDR no trata de exprimir los píxeles en pantalla para mejorar con ello la nitidez de las imágenes por lo que no es un estándar vinculado a las pantallas UHD/4K, 8K, etc.

Es una tecnología independiente de la resolución y como tal, un complemento, un añadido que tiene otras funciones que enriquecen la experiencia del usuario, y es que al final es la experiencia de usuario la finalidad de esta y otros tipos de tecnologías de mejora de imagen. Porque, efectivamente, lo que es, es una tecnología para mejorar la imagen, ni más ni menos.

HDR: la tecnología de vanguardia

HDR es el acrónimo de las siglas High Dynamic Range, es decir, alto rango dinámico y como su propio nombre indica es la capacidad que tiene un monitor, televisión o simplemente una pantalla o panel de lograr mostrar más gradaciones entre la oscuridad de una imagen y la luz que se muestra en ella. Lo que vienen siendo los pequeños detalles de toda la vida, esos que se pierden cuando hay demasiada luz o demasiada oscuridad.

Es decir, es capaz de representar en la pantalla una definición más alta en gradientes entre colores oscuros y claros, mostrando una disparidad mayor entre distintas intensidades de color. Esto no significa que se logre más brillo como tal, es importante no confundir los términos, ya que en muchos informes se cita el brillo como una de las características de HDR, pero realmente no es así, sino literalmente la diferencia entre el negro más oscuro y el blanco más claro.

Tampoco tenemos que caer en la trampa de pensar que HDR implica una mejora en el color, por el hecho de que esto es un factor del panel y su tecnología de representación y no una característica que integre HDR en sí misma. Si bien es cierto que HDR implica ciertos cambios en el color, no es una mejora per se, es decir, no mejora el color en su base, sino que logra mejores gradientes de color y contraste, lo que el ojo percibe lógicamente como una mejora visual de color general.

Esto se explica desde el punto de vista del panel de cada televisión o monitor, ya que si por ejemplo, un monitor tiene una paleta de colores pobre, HDR no logrará una mejora sustancial en la calidad de la imagen. En cambio, un panel con una paleta muy rica verá muy mejorada la experiencia visual. Esto es importante comprenderlo, porque lógicamente HDR no se aplica del mismo modo en unos paneles que en otros, algo que suele frustrar a algunos usuarios que piensan que con HDR van a conseguir la calidad y variedad de colores con un panel de gama baja frente a uno de gama alta, cuando no es así.

En resumidas cuentas, cuando un monitor o TV tienen certificación HDR (alto rango dinámico) significa que es capaz de generar un brillo muy elevado, de tal manera que se producen mejores gradientes de color, con colores más vívidos y nítidos y, en general, mejorando mucho la calidad global de la imagen. Pero hay algunas consideraciones a tener en cuenta, que es lo que os vamos a explicar en la siguiente sección de este artículo.

Brillo, profundidad de color y gama dinámica

Volvemos a insistir en el hecho de que en ninguno de los tres factores está implicado directamente HDR, sino que depende del panel en concreto. Pero sí es cierto que HDR influye en cada uno de ellos por separado.

Por ejemplo, al mismo contraste 1000:1, brillo de 250 cd/m2 y profundidad de 8 bits, HDR mejorará estos parámetros ofreciendo mayor brillo en los colores (consigue un mejor gradiente entre negro y RGB), un contraste más pronunciado debido al aumento del brillo comentado antes y por último logrará una mejor tonalidad entre colores en paneles más limitados en bits.

Así, se logran colores más intensos, uniformes y realistas, mejorando la experiencia visual a cada escena. Por lo tanto, HDR es considerada una de las tecnologías que representa mayor mejora en los paneles actuales, logrando potenciar las características que cada uno es capaz de ofrecer a un coste cada vez menor y mejorando en gran medida lo que paneles de gama alta ofrecen.

Actualmente, empresas como Netflix o YouTube ofrecen contenido HDR de calidad, así como películas en Blu-Ray y otras plataformas que están comenzando a implementarlo, por lo que es una tecnología que aunque ha tardado en despegar para la industria de la producción, ahora comienza a estar justificada a la hora de comprar un monitor gaming o televisión, ya que los juegos también implementan apartados específicos a cada nuevo título que se lanza al mercado.

Además, HDR ha evolucionado hacia una serie de estándares muy interesantes y con otras propiedades que complementan tanto las carencias que tenía como base como las que pueden tener los distintos tipos de paneles, pero esto es algo que veremos en un artículo específico.

Certificaciones HDR

Una vez entendido lo que es HDR y lo que implica, seguramente estés un poco confundido debido a la gran cantidad de estándares diferentes que hay alrededor de esta tecnología. Y es que tanto VESA como otros han querido estandarizar las características de esta tecnología, pero el problema es que luego los fabricantes de monitores y televisores han contratado los servicios de unos y otros indistintamente, sin llegar a un consenso global al respecto, haciendo que luego los consumidores terminemos confundidos cuando menos.

Seguramente los cuatro estándares (porque hay más) más importantes y extendidos son los cuatro que podéis ver en la imagen.

- HDR10: técnicamente está limitado a un brillo máximo de 10.000 nits, pero el contenido bajo este estándar está realizado a entre 1.000 y 4.000 nits.

- HDR 10+: sus características son las mismas que el anterior, pero es un estándar propietario de Samsung que simplemente es capaz de añadir un sistema dinámico de metadatos. Nada que lo diferencie del anterior de cara a los consumidores.

- Dobly Vision: utiliza metadata y es capaz de representar hasta 10.000 nits de brillo, si bien la certificación requiere que el contenido tenga como mínimo 1.000 nits nada más.

- HLG: la diferencia con los anteriores es que este estándar contempla también imágenes estáticas, no solo vídeos. Tiene una profundidad de color de 10 bits y no utiliza metadatos.

Si buceáis por la red seguramente veréis otras alternativas que son obra de empresas que afirman que tienen un HDR mejor todavía que los que están certificados. Es el caso de HDR-X, de Tekno3D, que afirman que tiene un mayor rendimiento pero, hasta el momento, no es considerado como un estándar que puedan aplicar todos los fabricantes en sus dispositivos.

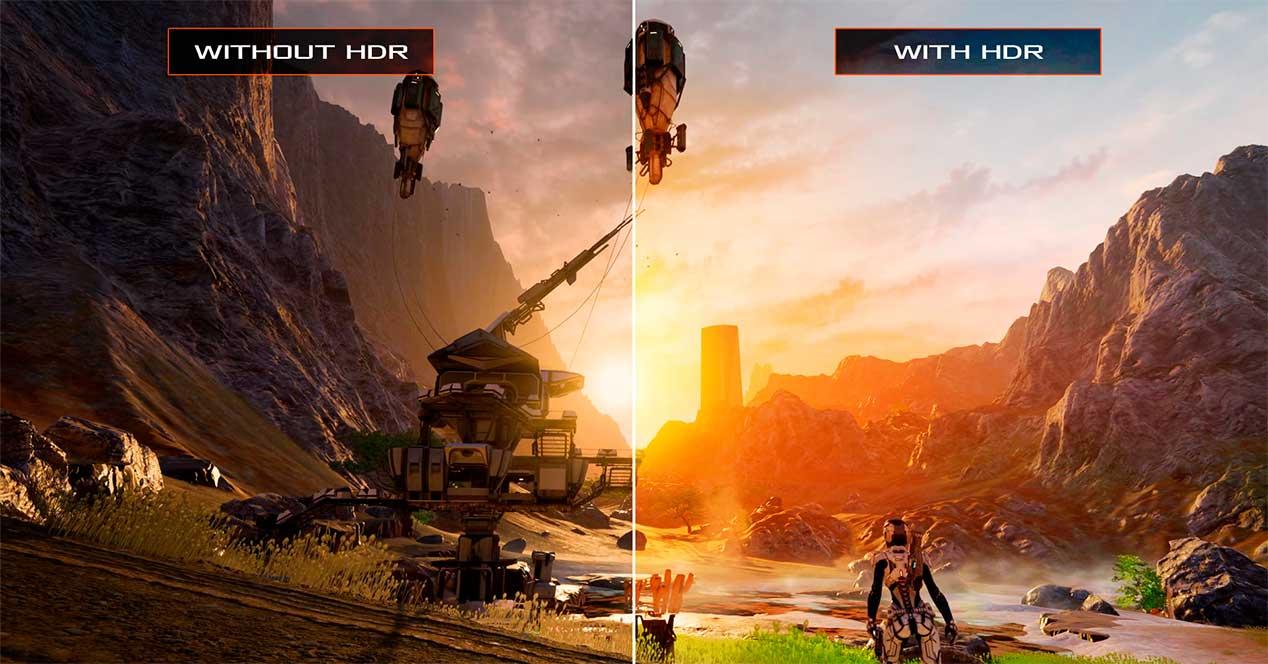

En resumen, la diferencia entre un monitor HDR y uno que no lo tenga es muy importante como podrás haber observado. Piensa en un juego oscuro o de guerra, donde tendrás que localizar a los enemigos, si el fondo está muy oscuro o brillante es posible que no lo puedas ver con claridad, mientras que tu compañero, desde el mismo sitio y con un monitor mejor, sí lo hará. Parece una tontería, pero a veces no solo influye la calidad y resolución de imagen. De nada sirve una pantalla 4K si por muy bien que se vea no vamos a apreciar los detalles. Así que ten este pequeño detalle en cuenta a la hora de adquirir una nueva pantalla. Te aseguro que se nota.

Cómo saber si un monitor tiene HDR

A la hora de activar el HDR primero debemos saber si nuestro monitor es compatible con esta tecnología, ya que obviamente, como hemos explicado anteriormente, no todas las pantallas son compatibles con ella. Podemos fácilmente encontrar si una pantalla dispone de HDR en las propias especificaciones que vienen en las propias instrucciones del dispositivo, pero hay ocasiones en las que podemos habernos deshecho de la caja original, aun así, es sencillo conocer si nuestra pantalla es compatible con esta tecnología directamente desde nuestro sistema operativo Windows.

Para ello, tan solo debemos ir a la configuración que tiene el propio SO sobre esta tecnología donde nos mostrará si nuestro monitor es compatible o no con el HDR, a continuación, os explicamos cómo hacerlo:

- Buscamos y abrimos el menú «Configuración» de Windows desde el buscador integrado.

- Nos desplazamos a la ventana de «Sistema» que aparecerá a la zona izquierda.

- Una vez aquí, abrimos el panel de «Pantalla»

- Nos dirigimos a la sección «Brillantez y color» y seleccionamos «HDR».

- Una vez aquí nos permitirá seleccionar la pantalla que queramos, indicándonos si es compatible con esta tecnología.

A la hora de activar esta tecnología mediante Windows no hay más misterio que seguir los mismos pasos para comprobar si tenemos el HDR disponible en nuestra pantalla, ya que tan solo tendremos que seleccionar la opción para poder activarla. Una vez hecho esto, podremos disfrutar al máximo de la calidad que es capaz de ofrecer esta función, permitiéndonos mejorar en muchos juegos, videos e incluso imágenes los colores que son capaces de mostrar, algo que de normal no se suele tener mucho en cuenta, pero que ofrece una inmersión superior, motivo de sobra para comprar una pantalla que permite el uso de esta tecnología.