El consumo de las GPU de NVIDIA y AMD se dispara, ¿no bastan los 5 nm?

Ya vimos los últimos rumores acerca de lo que nos espera con RDNA 3 y sobre todo con Ada Lovelace de AMD y NVIDIA respectivamente: un consumo desmesurado y nunca antes visto de serie para una sola tarjeta gráfica no dual. Ahora, con algo más de información al respecto vamos a tratar los porqués y, sobre todo, ¿qué está pasando para que el consumo de las GPU a 5 nm se eleve hasta los 480 vatios?

No menos de 400 vatios, una cifra que muchos temen, puesto que representaría una fuente de alimentación de una cantidad de vatios y una calidad que no pueden permitirse. Este es el escenario que vamos a ver en menos de un año según los rumores y como tal, hay que indagar en todos los motivos que conocemos a día de hoy para intentar poner blanco sobre negro. ¿Por qué no se reduce el consumo si se estrena nuevo nodo?

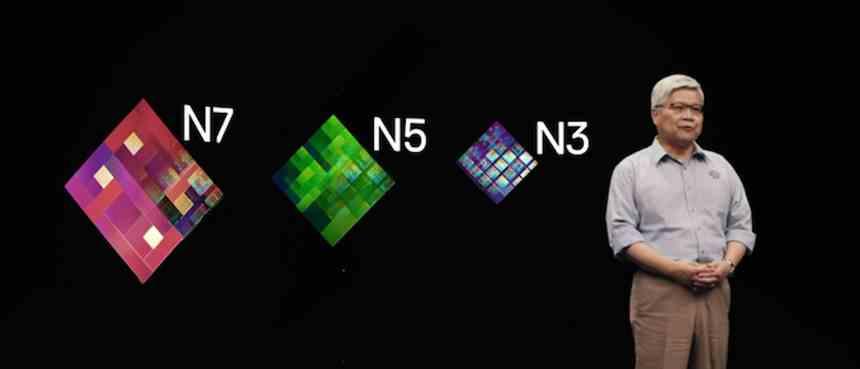

El nodo de TSMC a 5 nm no es tan bueno como lo pintan, Intel tiene una oportunidad

Lo cierto es que AMD y NVIDIA van a apostar todo a los nuevos 5 nm de los taiwaneses debido a las mejoras que trae este proceso litográfico de nueva factura, ya con EUV en su haber. Si la lógica imperaba que los consumos volverían a la normalidad de los 250-280 vatios por tarjeta, la realidad va a mostrar lo contrario.

Hay dos motivos principales que explican tanto esto como lo que está por venir, al menos en mayor o menor medida en los próximos años. Tanto Intel como TSMC como Samsung están enfocados en áreas específicas de los nodos debido al paso de FinFET a GAA, lo que está suponiendo un desafío y por lo tanto, se necesitan ciertas mejoras en campos que no priman la eficiencia.

Consumo de las GPU a 5 nm, mejor nodo no es sinónimo de mejor consumo

Para ser concretos, los tres grandes están luchando contra dos problemas y defectos:

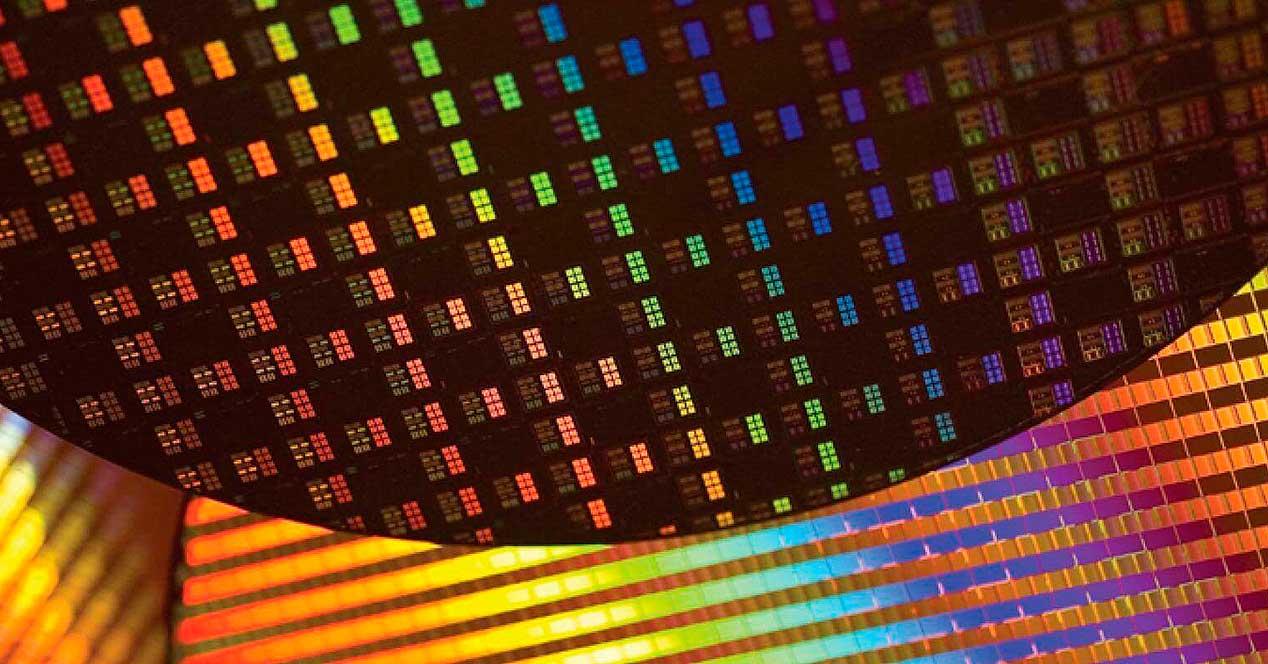

- Los nuevos procesos litográficos no están orientados para conseguir una reducción de consumo o simplemente mantener el consumo en la misma ganancia que el espacio que se logra. La densidad conseguida por la reducción de los transistores no es equivalente ni equitativa con el consumo por mm2.El problema aquí es que tanto AMD como NVIDIA van a necesitar fabricar chips sin los denominados «Silicios oscuros», es decir, sin partes del silicio no usables, por lo que necesitan todos los mm2 hasta el filo de cada die para introducir el mayor número de transistores.

- Y aquí llega el problema número dos: la competencia entre AMD y NVIDIA. A diferencia de otras generaciones AMD ahora sí es rival de NVIDIA, por lo que ninguna de las dos se va a guardar nada bajo la manga y van a poner todo lo disponible en sus nuevas arquitecturas, hasta el límite. Un salto de hardware tan brusco (+-70/80% más de transistores) supone un reto en cuanto a consumo, porque las frecuencias sí que tienen a mantenerse o incluso subir.Lo que se logra aquí es lo mejor que técnicamente pueden ofrecer ambas compañías, lo que sumado al punto uno da como resultado un aumento de rendimiento bestial comparado con años anteriores, pero un consumo de energía también mayor.

Por lo tanto, tanto Navi 31 como AD102 van a volver a cambiar el paradigma y el mercado de GPUs mundial, el problema para el usuario (precio y disponibilidad a un lado) va a ser los requerimientos de PSU para unos monstruos que van a tocar techo en los 480 vatios. ¿Necesitaremos fuentes de 1000 o 1200 vatios para mantenerlas a raya? ¿Sufrirán una vez más problemas las tarjetas por los peaks tan rápidos y tan agresivos por no tener PSUs listas para ello?