Hace unas horas se ha publicado una nueva patente de AMD en la que se describe un nuevo tipo de chiplet, esta vez dedicado a la inteligencia artificial, que viene a complementar la patente del chiplet dedicado a la GPU que supuestamente veremos en RDNA 3. Hemos encontrado la patente del chiplet para IA de AMD lo suficientemente interesante para desgranarla para vosotros.

La Inteligencia Artificial es un mercado en el que AMD ha estado ausente durante mucho del mercado de los procesadores para la inteligencia artificial, por eso la aparición de una patente por parte de AMD donde se habla de un procesador dedicado para esta tarea sorprende, aunque tampoco es la primera apuesta que hacen si tenemos en cuenta CDNA.

Las GPUs y la Inteligencia Artificial

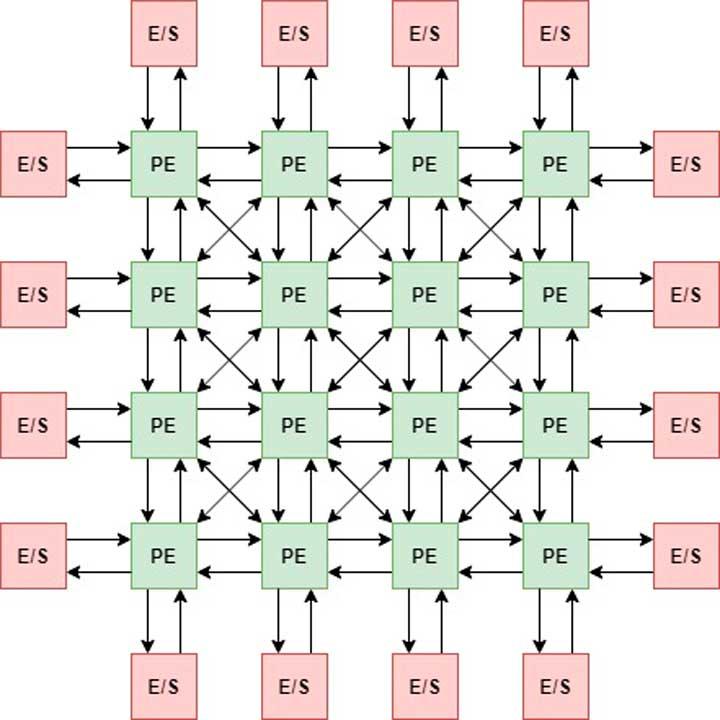

Desde NVIDIA añadiese sus Tensor Cores, los cuales no son más que ALUs del tipo array sistólico, el uso de las GPUs para la inteligencia artificial ha crecido exponencialmente y ha abierto con ello nuevos mercados para estos dispositivos. Claro esta que en el mercado doméstico la utilidad de la inteligencia artificial se ha visto ciertamente limitada a unas utilidades concretas como es la cancelación de ruido durante las conversaciones, la eliminación de fondos para el streaming y especialmente el aumento de resolución a tiempo real.

En el caso de AMD, la IA ha brillado por su ausencia en sus RDNA, pero las GPU de la familia CDNA, las cuales carecen de las unidades de función fija para gráficos, si que tienen arrays sistólicos en sus Compute Units, por lo que la especulación de cara a RDNA 3 se basaría en la implementación de la unidad de los CDNA en las Compute Units de RDNA 3, lo que le daría a las GPUs de AMD para PCs la capacidad de poder ejecutar algoritmos similares a los que en la actualidad ejecutan los Tensor Cores de NVIDIA.

Desgranando la patente del chiplet para la IA de AMD

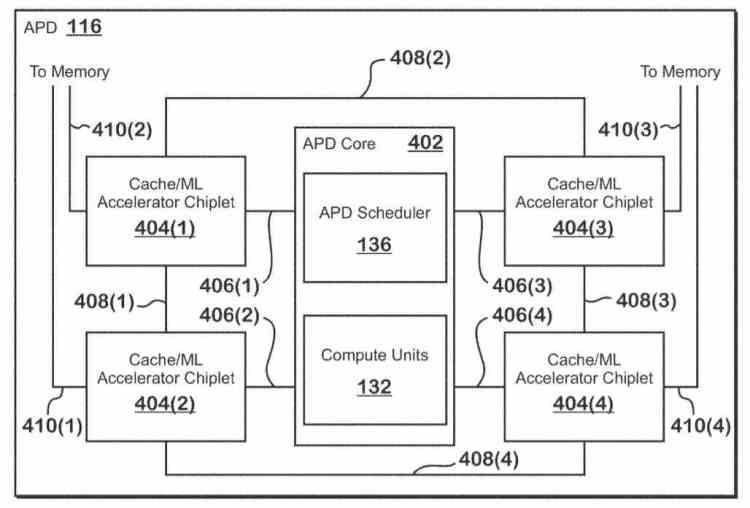

La patente que acaba de aparecer describe una GPU con 5 chiplets diferenciados, compuestos por una GPU central y 4 chiplets para inteligencia artificial, los cuales cumplen además la funcionalidad de cache de último nivel entre la GPU central y la memoria externa, por lo que estamos ante un circuito electrónico muy complejo, lo que nos hace pensar que no se trata de un diseño pensado para servidores, especialmente centros de datos.

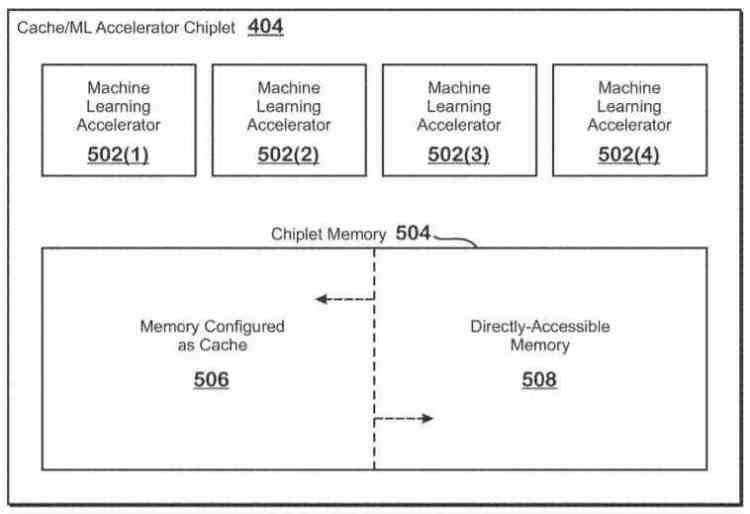

Cada uno de los chiplets esta compuesto de dos partes, por un lado se puede configurar para funcionar tanto como la memoria RAM de los procesadores para inteligencia artificial embebidos en el propio chiplet, por el otro podemos hacer que se configure como cache de último nivel. Esto le permite a los Chiplets actuar como coprocesadores de la GPU o funcionar de manera independiente a esta según como configure la memoria.

Lo cual nos recuerda a lo que las AMD Vega pueden hacer a través del High Bandwidth Cache Controller, en el que la memoria HBM pasa de hacer de memoria final para la GPU a hacer de cache para los accesos a la RAM del sistema y un SSD conectado al los puertos PCIe del sistema, pero no se aplicaría a nivel de la GPU central sino de cada acelerador.

No obstante esto no significa que estemos hablando de memoria HBM, ya que el chiplet aparte de la memoria tiene integradas cuatro unidades que son nombradas como «Machine Accelerator Units», las cuales son descritos como multiplicadores de matrices en la patente. por lo que no son más que arrays sistólicos, por lo que estamos ante un caso claro de procesador integrado en la memoria.

La patente no da más detalles sobre las cuatro unidades para inteligencia artificial, pero dado que son unidades fuera de las Compute Units no pueden compartir la unidad de control con el resto de la Compute Unit, lo que significa que el chiplet funciona como un procesador completo y no son simples «Tensor Cores». Dicho de otra forma, tienen su propia unidad de control y por tanto cada chiplet para la IA es un procesador independiente.

Esto significa que al igual que la GPU ejecuta una lista de comandos gráficos y/o de computación que es enviada por la CPU, esto significa que los chiplets para la IA pueden acelerar algoritmos para la IA sin la necesidad de necesitar utilizar una GPU con unidades para la IA para ello. Lo cual se traduce en que AMD podría vender de cara a ciertos mercados, especialmente los de servidores y los de centros de datos, estos chiplets para la IA.

¿Los veremos en el mercado doméstico? Lo dudamos, el motivo es el sobrecoste para el usuario que resulta añadir un chip adicional a la ecuación del coste, por lo que pensamos que la IA en RDNA 3 será más bien con unidades especializadas dentro de las Compute Unit de cada GPU, como ocurre actualmente con NVIDIA.