AMD intenta justificar los 16 GB de la Radeon VII: ¿son necesarios en juegos?

AMD ha recibido bastantes críticas con su Radeon VII, ya que en principio dicha tarjeta estaría posicionada mucho más cerca de la gama alta de NVIDIA que de la media-alta. Rendimiento aparte, un aspecto también criticado ha sido su precio, el cual viene por la inclusión de los 16 GB de HBM2, pero ¿son realmente necesarios para jugar? Según Scott Wasson sí, y para ello AMD ha facilitado ciertos datos.

La creciente lucha entre recursos de hardware y software

En un artículo escrito por el propio Scott Wasson, Sr. Manager de productos de AMD, comenta que a pesar de que el hardware aumenta su capacidad de cómputo y espacio físico con el tiempo, el software existente siempre pide más recursos.

Por ello, diseñaron la Radeon VII con una cantidad de memoria HBM2 de 16 GB y un TB/s de ancho de banda, ya que algunas cargas de trabajo son muy exigentes con los jugadores y creadores de contenido.

Para ofrecer datos concretos, el equipo de AMD para dichas pruebas estuvo compuesto por un i7-7700K, 16 GB DDR4 3000, su Radeon VII y todo bajo Windows 10 64 bits. Es curioso que usen dicha velocidad en RAM para un equipo Intel, puesto que fuerza al IMC a introducir divisores poco óptimos y fuera del buscado 1:1 real.

Además, introdujeron otro equipo distinto en las pruebas que veremos a continuación para HBCC, siendo este: Intel Core i7-5960X (3.0GHz), Gigabyte X99-UD5 WiFi, 16GB Corsair Vengeance LPX (2x8GB) DDR4-2666MHz, Windows 10 versión de 64 bits 1809.

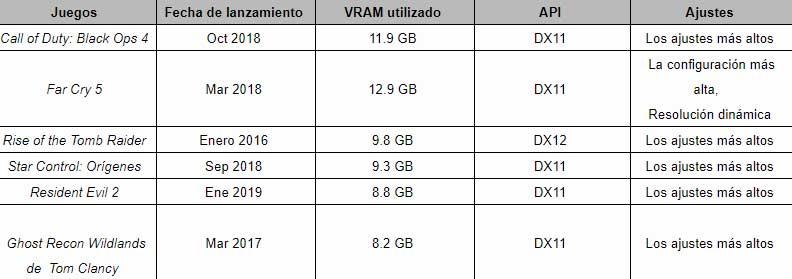

En cualquier caso, la Radeon VII fue probada en varios juegos: Call of Duty: Black Ops 4, Far Cry 5, Rise of the Tomb Raider, Star Control: Origins, Resident Evil 2 y Tom Clancy´s Ghost Recon Wildlands, además de Adobe Premiere.

Codificación de vídeo en 4K y 8K en

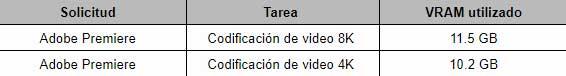

La codificación de vídeo en Adobe Premiere en dos configuraciones distintas en cuanto a su resolución, dio bajo 4K un uso de VRAM de 10,2 GB, cifra que se elevó hasta los 11,5 GB en 8K.

Aunque estas cifras variarán según la carga de trabajo, tal y como afirma AMD, los formatos avanzan, HDR amplía las gamas de colores y se añadirán mayores opciones y efectos, pero es realmente complicado encontrar una carga de trabajo que muestre bajo Premiere los datos que Wasson facilita.

Juegos

Los desarrolladores siempre buscan nuevas técnicas para optimizar sus juegos, los monitores añaden mayores características y además amplían sus resoluciones (sobre todo los 21:9), admiten HDR y mayores profundidades de color etc.

Esto puede ser un obstáculo para ciertas GPUs y ciertas resoluciones, no cabe duda, pero lo que AMD muestra aquí es realmente unas condiciones muy rebuscadas y poco específicas, pero antes de comentarlas conozcamos los datos:

En primer lugar, no se especifica resolución alguna para ninguno de los juegos mostrados (entendemos que 4K) y en segundo lugar, por «ajustes más altos» podemos entender perfectamente un preset Ultra, o en cambio ser literales y creer que todos los ajustes posibles se han llevado al límite, pero entonces ¿incluirán la escala de resolución? ¿SMAA o TAA?

Esto es un problema porque tampoco se especifica en ningún momento, por lo que las pruebas no son ni mucho menos reproducibles en cualquier otro equipo. Pero, sobre todo, no sabemos si AMD está jugando al despiste, ya que en la mayoría de los juegos si los settings se han llevado al límite, con SMAA X4 no se puede directamente jugar con una GPU y se requieren sistemas SLI o Crossfire.

Esto puede sacar de contexto los 11,9 GB de BO4 o los 12,9 GB de Far Cry 5, ya que primero primarán los FPS que busquemos y luego tendremos que mirar la VRAM consumida.

¿Qué ocurre cuando un juego sobrepasa la VRAM de la GPU?

En la mayoría de los casos y juegos las desarrolladoras usan sistemas internos de MEMCACHE propios, guardando mucho espacio en memoria virtual como archivo de paginación del sistema, totalmente independiente y que volcará las texturas entre RAM y VRAM si es preciso.

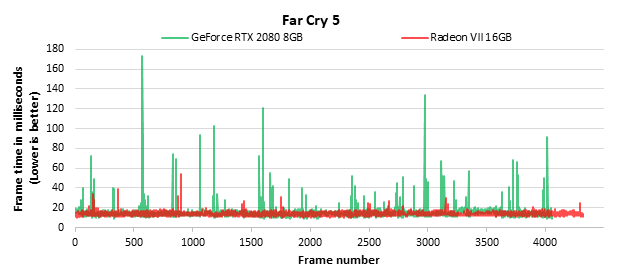

AMD muestra mediante un FrameTime lo que ocurre si superamos la asignación máxima enfrentando en ello a la RTX 2080 contra su Radeon VII, la primera con 8 GB y la segunda con los mencionados 16 GB.

Lo que vemos aquí es un claro caso de asignaciones externas de memoria, donde la RTX 2080 sufre bastante stutter en ciertos puntos, mientras que la Radeon VII es mucho más constante y aun así tiene algunos picos considerables.

Lo mostrado evidencia que se debe estar jugando a unos 60 FPS de media (16,6 ms), pero se obvia que la RTX 2080 no es una GPU para 4K, ya que para eso NVIDIA ya tiene la RTX 2080 Ti con 11 GB y donde el escenario será completamente distinto.

AMD compara su Radeon VII contra la RTX 2080 porque es la GPU que compite en rendimiento y precio, pero expone un escenario poco realista siendo honestos.

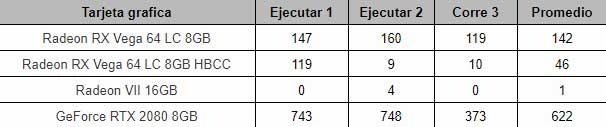

Por último, tenemos los frames que sobrepasan los 50 ms:

Evidentemente, a menor número de frames que sobrepasen los 50 ms más suavidad tendremos en nuestro juego. Donde curiosamente la RX Vega con los mismos 8 GB que la RTX 2080 obtiene mucho mejores resultados, incluso sin activar HBCC.

Esto es realmente chocante, puesto que la RTX 2080 es mucho más rápida, aunque ambas estén limitadas. Además, el ancho de banda de la RX Vega 64 es de 483,8 GB/s, mientras que la RTX 2080 consigue 448 GB/s, es decir, solo las separan un 7,39%.

¿Cómo es posible que a misma cantidad de RAM y un ancho de banda casi calcado las diferencias en Frames por encima de 50 ms sean tan sumamente abultadas? ¿cómo se explica que con tan poca diferencia de ancho de banda y mucha más de potencia de cálculo la tarjeta de NVIDIA siendo más rápida acabe tan mal parada cuando comprime mucho mejor las texturas?

Grandes preguntas que AMD debería de explicar, pero sobre todo ser mucho más específica a la hora de aportar datos, settings y resoluciones varias.