NVIDIA se enfrenta a Intel y la acusa de hacer trampas y falsear datos

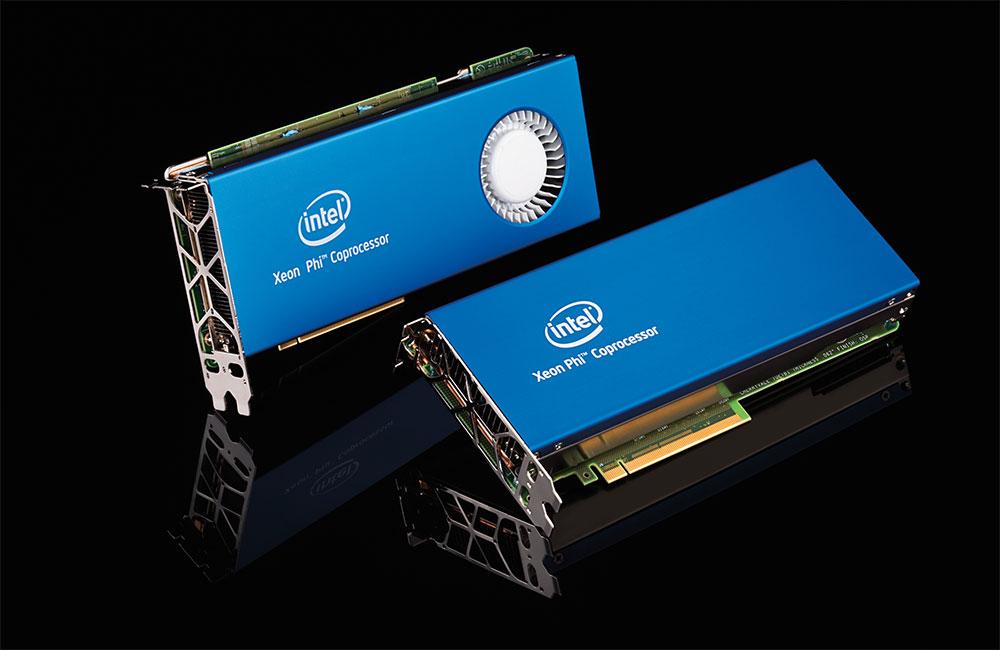

Si normalmente estamos acostumbrados a ver “disputas” entre NVIDIA y AMD o AMD e Intel, en éste caso nos toca ver algo que al menos es poco convencional. NVIDIA ha acusado a Intel de hacer trampas y falsear las gráficas de rendimiento que presentaron en el ISC 2016, donde las tarjetas aceleradoras Xeon Phi (Knights Landing) salían mejor paradas que las gráficas Maxwell de NVIDIA.

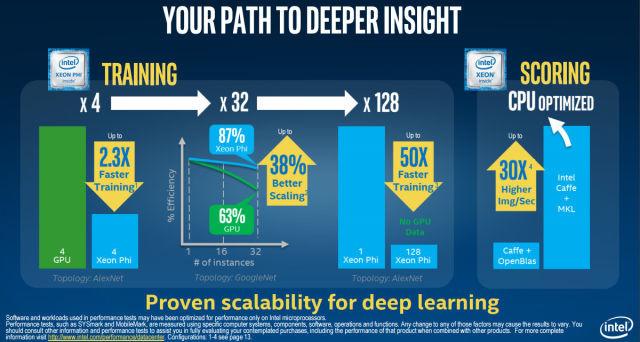

El tema es el siguiente: Intel realiza su presentación habitual en el evento ISC 2016, y muestra una presentación con una serie de diapositivas enseñando los datos habituales. En varias de éstas diapositivas se mostraban datos de rendimiento teórico de las tarjetas aceleradoras Xeon Phi “Knights Landing”, incluyendo gráficas comparativas de éstas con las GPUs NVIDIA Maxwell de anterior generación. Concretamente, según Intel, para cálculo de redes neuronales (en otras palabras, deep learning) los aceleradores Xeon Phi proporcionan 2.3 veces el rendimiento y una escalabilidad un 38% superior a las gráficas Maxwell.

Claro, con el fuerte enfoque que NVIDIA está dando en los últimos tres años al desarrollo de deep learning, la compañía se ha sentido ofendida y ha saltado al quite para acusar a Intel de mentir y negar los datos proporcionados por el gigante del silicio.

Concretamente, NVIDIA ha argumentado que Intel ha empleado la “técnica clásica” (palabras literales) de utilizar benchmarks antiguos para sus pruebas. Los de verde afirman que si Intel hubiera utilizado la última versión del mismo benchmark empleado para tomar los datos de rendimiento de redes neuronales (llamado Caffe AlexNet), las mismas GPUs Maxwell habrían obtenido un resultado un 30% superior a los productos de Intel.

Además, claro está, NVIDIA ha dejado bien claro que Intel ha tratado de engañar a la gente comparando su nueva generación de aceleradores gráficos con la pasada generación de NVIDIA, y que si hubieran utilizado la generación actual (Pascal), habrían obtenido fácilmente un resultado un 90% superior al de los aceleradores Xeon Phi de Intel.

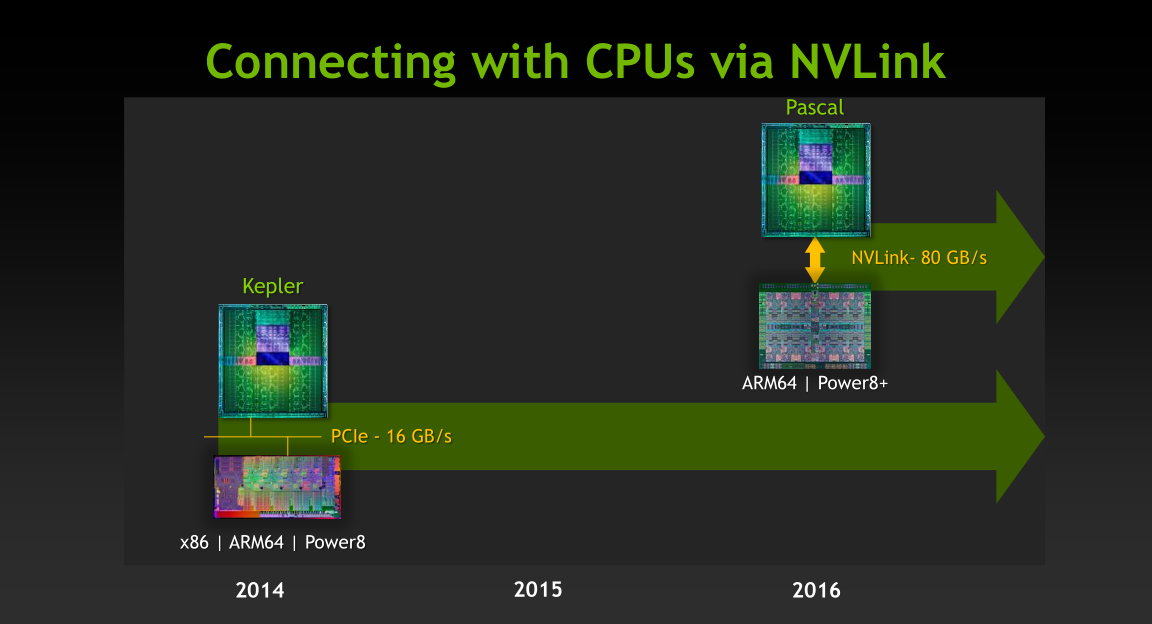

Pero esto no termina ahí, pues NVIDIA ha querido meter el dedo en la llaga y ha dejado ver que Intel ha comparado la potencia de 32 de sus nuevas tarjetas aceleradoras de última generación ante servidores de hace cuatro años que utilizaban GPUs KVIDIA Kepler, de hace dos generaciones (usadas en el super ordenador Titan de ORNL). Pascal es capaz de escalar hasta 128 GPUs gracias a NVLink, proporcionando la solución de deep learning más potente que se puede comprar a día de hoy.

Personalmente, no sé si los datos que proporcionan una y otra compañía son más o menos exactos, pero lo que sí es cierto y le doy la razón a NVIDIA es que Intel no ha jugado limpio comparando sus últimos productos con los penúltimos de NVIDIA, y utilizando la versión del benchmark que les favorece a ellos y no la última disponible.