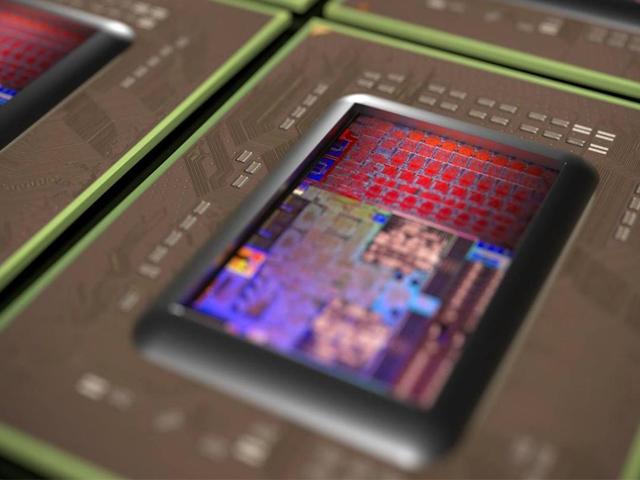

A través de algunas filtraciones de benchmarks en Compubench, ya se conoce algo más de información sobre las próximas arquitecturas de GPU Polaris y Vega de AMD, especialmente en lo relativo a sus unidades de cómputo (CUs) y el número de stream processors con los que contarán. En éste artículo os lo contamos todo sobre la información filtrada y sacamos nuestras propias conclusiones al respecto.

Vamos por partes, y empezamos por los números. VideoCardZ asegura que tras analizar los datos filtrados en Compubench, han determinado que las GPUs AMD Polaris 11 partirán de tan solo 16 CUs. Con esta información y partiendo de la base que los CUs de la arquitectura Graphics Core Next cuentan cada uno con 64 stream processors (así ha sido en las tres últimas generaciones), podemos sacar las siguientes conclusiones:

- Las GPUs AMD Polaris 11 “Baffin” podrían tener unos 1.024 stream processors en 16 CUs.

- Polaris 10 “Ellesmere” por su parte tendría 2.304 stream processors en 36 CUs.

- Vega 10 contará finalmente con 4.096 stream processors, ya que tendrá 64 CUs.

El chip Baffin (Polaris 11) será el relevo generacional del actual chip Curacao, y será el que potenciará la gama media de gráficas de AMD. Se espera que utilice todavía memoria GDDR5 con un bus de 128 bits. Por su parte, el chip Ellesmere (Polaris 10) será el que sucederá al actual Tonga y conformará el segmento de gama media-alta de AMD. Ya contará con gráficas de hasta 8 GB de memoria GDDR5X con un bus de 256 bits.

Finalmente, las GPUs Vega 10 serían las teóricas sucesoras de Fiji, y estarían lógicamente orientadas al segmento de la gama alta. Contarán por fin con memoria gráfica HBM2 y se verán con capacidades de 16 GB fácilmente. Según AMD, éstas gráficas no llegarán hasta principios del año que viene, y prometen un incremento de la eficiencia (rendimiento por vatio) de 2.5X veces el de la arquitectura GCN 1.2 (chips Tonga y Fiji entre otros).

Con estos datos en la mano podemos sacar una conclusión clara: AMD buscará éste incremento de eficiencia para meter un menor número de cores en sus próximas GPUs, lo que les permitirá mantener o mejorar el rendimiento con chips más pequeños y que se calienten menos.

De ser así, pienso sinceramente que AMD no se va a llevar el gato al agua. Los usuarios no necesitamos eficiencia ahora mismo, sino rendimiento. Necesitamos productos capaces de mover juegos a tope a 4K y 60 FPS. AMD, si nos puedes proporcionar esto, ¿por qué sigues empeñada en mejorar la eficiencia cuando lo que hace falta es rendimiento bruto? Pienso, personalmente, que quien quiere jugar a tope a 4K y 60 FPS no se va a preocupar por la eficiencia de la gráfica. Es como decir que quien se compra un Ferrari se va a preocupar por el consumo de combustible, ¿no creéis?