Análisis de rendimiento gráfico en Battlefield Hardline

A pesar de los problemas encontrados en el DRM de Battlefield Hardline a la hora de hacer cambios de hardware en nuestro equipo, finalmente hemos podido realizar pruebas suficientes como para mostraros nuestro particular análisis de rendimiento gráfico en el último juego lanzado por EA. Así pues, a continuación podréis ver, como hemos realizado en otros juegos anteriormente, un análisis de rendimiento gráfico de Battlefield Hardline utilizando varias tarjetas gráficas para que veáis qué tal funciona dependiendo de la configuración del sistema.

Todas las pruebas las hemos realizado en el mismo equipo, cambiando únicamente la tarjeta gráfica y lógicamente los drivers en consonancia con la marca de ésta. Así pues, hemos empleado los drivers Catalyst Omega con las gráficas de AMD y los Forceware 347.88 con las gráficas de NVIDIA. El sistemas operativo empleado en todos los casos ha sido Windows 8.1 x64 con todas las actualizaciones instaladas, y el hardware empleado para las pruebas ha sido el siguiente:

- Intel Core i7-2600K @ 4.4 Ghz.

- Asus Sabertooth P67 B3.

- Noctua NH-D15.

- 2×8 GB Kingston HyperX Savage 2133 Mhz.

- Thoshiba HG6 512 GB SATA3.

- Cooler Master Silent Pro Hybrid 1050W.

- 2x WD Black 2Tb SATA3.

Las tarjetas gráficas empleadas en nuestras pruebas han sido las siguientes:

- NVIDIA:

- MSI GeForce GTX 970 Gaming 4G.

- Gigabyte GeForce GTX 770 OC WindForce 3X 2Gb.

- PNY GeForce GTX 760.

- AMD:

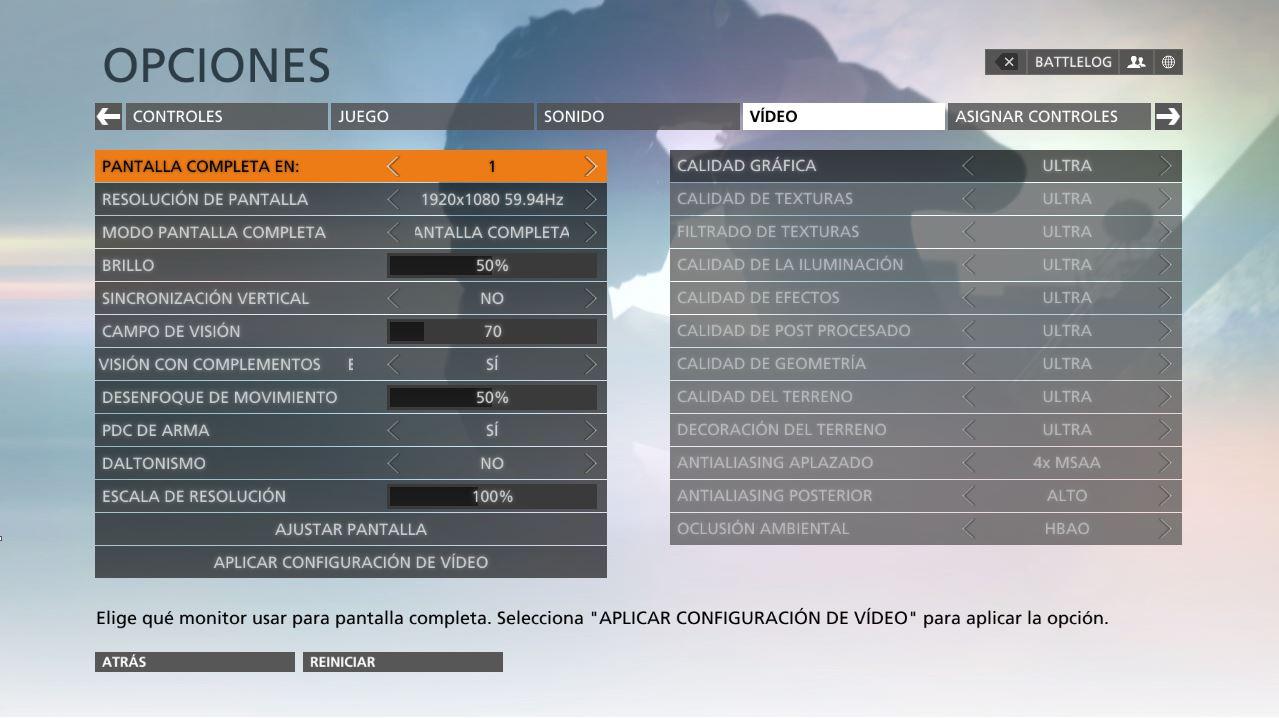

Para testear Battlefield Hardline, en todos los casos hemos jugado el primer capítulo del modo Campaña completo, en resolución Full HD y con todos los ajustes gráficos al máximo (Ultra), en pantalla completa y con la sincronización vertical deshabilitada. Lo podéis ver en la siguiente captura de pantalla.

Nota: La API gráfica empleada ha sido DirectX 11 en todos los casos. No se ha utilizado Mantle.

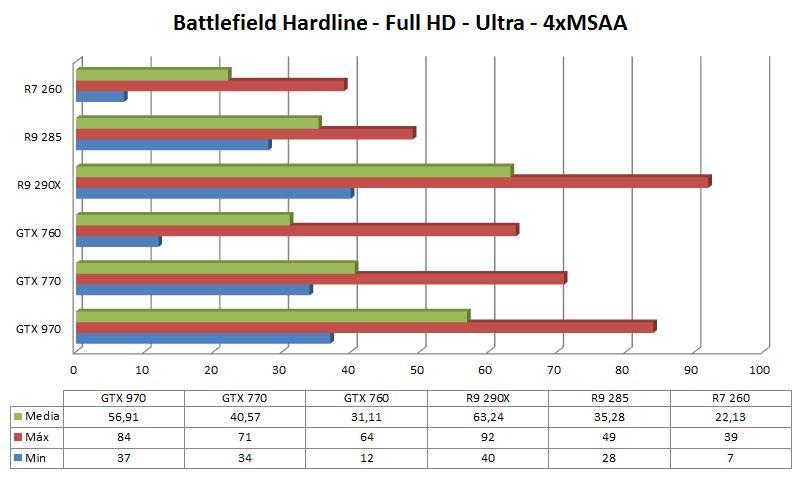

Resultados de rendimiento gráfico en Battlefield Hardline.

Los resultados obtenidos han sido medidos con la utilidad benchmarking de FRAPS, y reflejan los FPS (frames por segundo) medios, máximos y mínimos en el juego.

Hay que destacar que en un juego como Battlefield Hardline, en cuanto los FPS bajan de 40 la experiencia de juego es realmente mala, por lo que debemos de ser bastante exigentes en este sentido y esperar que nuestra gráfica sea capaz de darnos estos 40 FPS de media como mínimo para una experiencia de juego satisfactoria. También reseñamos que hay una diferencia abismal de rendimiento cuando estamos en escenas exteriores y cuando estamos dentro de un edificio, denotando que el juego está bastante mal optimizado en este sentido.

Conclusión

A pesar de haber utilizado DirectX 11 y no Mantle para testear Battlefield Hardline, la Radeon R9 290X de 4 GB se ha mostrado como la top 1 de entre las gráficas que tenemos en nuestro laboratorio (sentimos que la gráfica NVIDIA más potente a nuestro alcance sea una GTX 970, pero es lo que hay. No obstante es la que compite en precio con la R9 290X a día de hoy así que la comparativa es justa). Además habrá que esperar porque muy probablemente AMD lance drivers «Game Ready» optimizados para Battlefield Hardline, al igual que hizo NVIDIA.