Según afirman diversos medios coreanos, a falta de confirmación oficial por parte de Samsung, esta compañía acaba de llegar a un acuerdo con AMD para ser la encargada de suministrar, en exclusiva la memoria HBM3E para las GPUs enfocadas al entrenamiento de Inteligencia Artificial de AMD.

Este acuerdo, valorado más de 3.000 millones de dólares supone una importante victoria para Samsung, empresa que siempre se ha considerado de segunda clase en el desarrollo de memorias HBM3, siempre por detrás de SK Hynix, quien tiene un acuerdo también exclusivo con NVIDIA para las memorias de sus GPUs.

Entre los detalles del acuerdo filtrados, se menciona que Samsung comprará estas nuevas GPU para mejorar su modelo de aprendizaje automático que ya se encuentra disponible tanto en la nueva gama de SmartTV que presentó hace unos días como en la gama Galaxy S24.

Samsung suministrará las memorias de las GPU de AMD

De momento, Samsung todavía no ha comenzado a producir este nuevo tipo de memoria de 12 capas, pero sus planes pasan por hacerlo en los próximos meses antes de acabar 2024.

El primer modelo que implemente este nuevo tipo de memoria es la Instinct MI350, una GPU que cuenta con arquitectura CDNA 3 que utiliza un proceso de fabricación de 4nn de TSMC. CDNA 3 ofrece un rendimiento en Inteligencia Artificial superior al 500% con respecto a CDNA 2

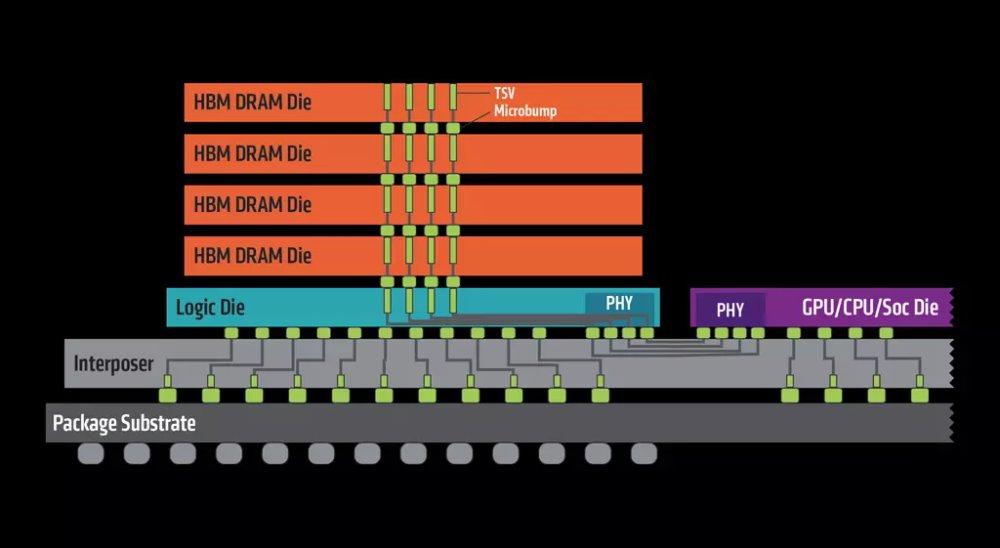

Además, este nuevo estándar de memoria que utilizará las futuras GPU de AMD es un 50% más rápido que el HBM3, y cuenta con ancho de banda por sistema de 10 TB/s y un ancho de banda por chip de 5 TB/s con capacidad para 141 GB.

Lo que está claro es que AMD tiene mucho que hacer para convertirse en una alternativa real en el segmento de las GPU para centros de datos y, de momento, sigue por detrás.

Esta no es la primera colaboración de AMD y Samsung. En el pasado, ambos colaboraron en el diseño de la GPU con arquitectura RDNA de los procesadores Exynos de Samsung, aunque los primeros resultados de la colaboración no dieron el fruto que esperaban, sin embargo, ambas empresas siguen en este proyecto.

Mucho camino por delante

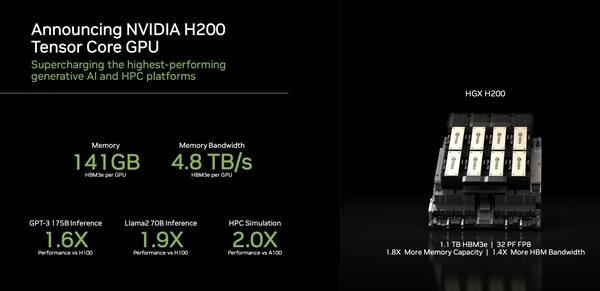

Precisamente ayer, tal y como os hemos informado unas horas antes, el máximo responsable de NVIDIA, Jensen Huang, ha entregado (de forma simbólica) la primera GPU DGX H200 al CEO de OpenAI, Sam Altam, aunque es Microsoft quien está pagando las facturas de OpenAI (ya podían haber contado con Satya Nadella).

Este modelo cuenta con 141 GB de memoria HMB3A fabricada por SK Hynix y cuenta con una velocidad de procesamiento de hasta 4.8 TB/s. Prestaciones similares la MI350 de AMD, sin embargo, mientras que la producción de la H200 ha comenzado, AMD no tiene previsto iniciar la producción hasta dentro de unos meses.

Según afirmó Huang en la presentación de este nuevo modelo de GPU este ofrece un rendimiento superior a un 60% en con GPT-3 y de hasta un 90% en Llama 2. Llama la atención que la comparación la hiciera con GPT-3 y no con GPT-4 la versión más actual o incluso con GPT-4.5, que, en teoría, será la próxima versión de GPT.