La Inteligencia Artificial se ha convertido en un término habitual en muchas conversaciones del día a día gracias a ChatGPT, el chat conversacional de OpenAI con el que podemos saciar nuestra curiosidad sin buscar en Google, crear documentos completos y mucho más donde el límite está en la versión GPT.

ChatGPT se basa actualmente en GPT-4 un modelo de lenguaje grande (LLM) que, desde su lanzamiento se ha convertido en la referencia a seguir por los demás competidores como Llama de Meta o Claude de Anthropic, modelos que han mejorado considerablemente en los últimos meses, aunque todavía tienen un largo camino por recorrer.

El paso de GPT-3.5 a GPT-4 supuso un paso de gigante para ChatGPT, ampliando considerablemente el número de funciones que es capaz de hacer al haber sido entrenada con muchos más parámetros, por lo que mantenerlo en funcionamiento es mucho más caro, económicamente hablando, que GPT 3.5, de ahí que este sea gratuito mientras que GPT-4 es de pago.

Cada nueva versión de GPT, al igual que las nuevas versiones de Claude y Llama, van asociadas a mayores consumos de energía y a una mayor potencia necesaria para poder gestionar todos los parámetros a tener en cuenta. Según afirma el director del Centro para la Seguridad de la IA, Dan Hendryks, con cada solicitud a ChatGPT basado en GPT-4, el número de recursos necesarios es 10 veces mayor al número de recursos necesarios con GPT-3.5.

Cuál será la próxima versión de GPT

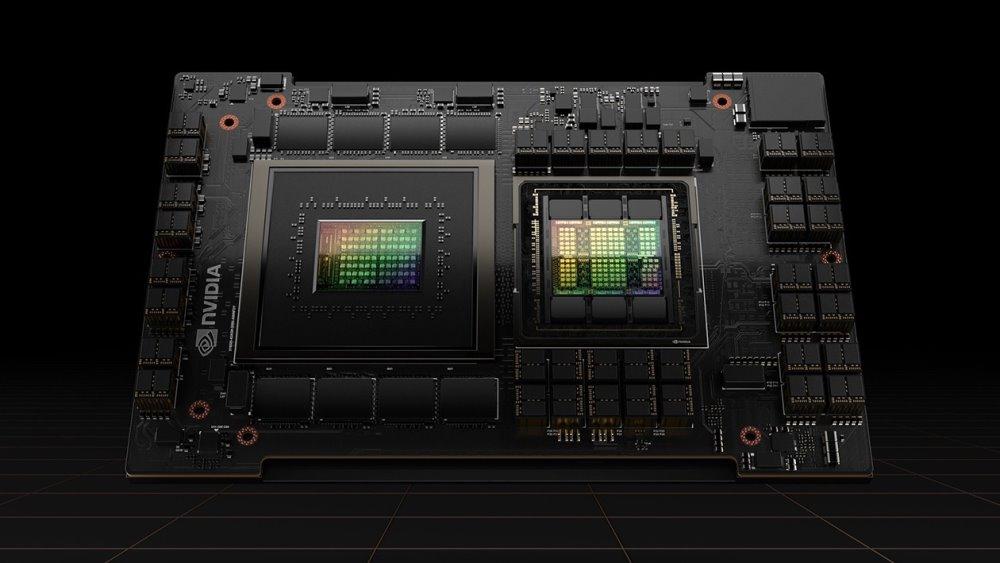

Teniendo en cuenta el consumo de recursos, si OpenAI se saltara GPT-4.5 y fuera directamente a GPT-5, el consumo de recursos computacionales se incrementaría en 100 veces a los que actualmente requiere GPT-4, lo que equivale a 1 millón de GPUs H100 de NVIDIA trabajando durante 3 meses.

Eso sin contar el enorme consumo de energía que sería necesario, uno de los apartados más negativos de la Inteligencia Artificial que mucha gente no está teniendo en cuenta. Según afirma un estudio, el total de GPUs que NVIDIA pretende vender del modelo H100 en 2024 tendrán el mismo consumo de electricidad que actualmente tiene países como Guatemala o Lituania, sobre unos 13.000 GWh.

Para 2027, si el desarrollo de la IA sigue a este ritmo, el consumo de los centros de datos se disparará entre 85 y 134 TWh (no GWh), superando al consumo energético de muchos países del mundo.

El máximo responsable de Anthropic, Dario Amodei, afirma que, en la actualidad, entrenar un LLM tiene un coste de 1.000 millones de dólares, un coste que para 2026 se disparará hasta los 10.000 millones de dólares.

Teniendo en cuenta estas cifras de consumo y recursos necesarios, no sería de extrañar que las versiones de pago de estos LLM sean cada vez más caras y que, en un futuro, estén limitadas en entornos empresariales ya que serán los únicos que podrán permitirse mantener el desarrollo de la Inteligencia Artificial.

Respecto a la pregunta de qué versión de GPT llegará antes. Teniendo en cuenta el salto de recursos necesarios para GPT-4.5 y GPT-5, las posibilidades de que esta última sea la próxima versión GPT son ínfimas.