La última revolución en los monitores y los televisores es la gran implantación que se está produciendo del estándar HDR (High Dynamic Range) en ellos. Especialmente en los televisores y monitores con resolución 4K, que están viviendo, desde hace algún tiempo, una gran cantidad de ventas a nivel de los usuarios. En este tutorial, vamos a ver si realmente es necesario tener HDR en nuestros equipos.

A pesar de todas las ventajas que aporta el HDR a la hora de visualizar mejor los contenidos en nuestras pantallas, ya sean monitores o televisores, no podemos obviar que es una tecnología relativamente joven. De hecho, el espacio del HDR está ocupado, en su gran mayoría, por dos tipos de tecnologías que prometen hacer lo mismo: HDR, que es el estándar promocionado por VESA, y Dolby Vision, que está promocionado por Dolby Laboratories. El estándar HDR tiene a su favor que es gratuito, con lo cual los fabricantes de las pantallas no tienen que pagar ningún extra a nadie. Por contra, Dolby Vision es un estándar propietario de Dolby, la cual recibe una cantidad por cada modelo que se vende que emplee su tecnología, en concepto de royalties.

Al final, esto se convierte un poco como el dilema que hubo en su momento entre la tecnología HD-DVD y el Blu-Ray: hasta que no haya un ganador definido, no deberíamos de decantarnos por ninguna de estas tecnologías. Pero, por si fuera poco, ahora también está en la palestra el estándar HDR10+ que está promocionando un grupo de empresas, de entre las cuales, Samsung es su principal valedora.

Existen varios problemas con el HDR

Uno de los problemas que podemos encontrar con el HDR es la relativa falta de contenidos que hay en el mercado que pueden hacer uso de él. Y es que, a diferencia de los monitores y televisores tradicionales, el contenido para HDR ha de ser fabricado específicamente para que realmente se pueda notar la diferencia en la calidad de imagen. Tanto Netflix, como Amazon Prime Video son dos compañías que está apostando con fuerza por el estándar gratuito. Sin embargo, las empresas cinematográficas prefieren optar el estándar Dolby Vision.

Curiosamente, para complicar más las cosas, en el terreno de los videojuegos, no solo tenemos los estándares HDR y Dolby Vision, sino que también tenemos el estándar FreeSync 2 HDR, el cual es propietario de AMD. Esto en cuanto a los ordenadores de sobremesa. Porque si nos movemos al territorio de las consolas, todas soportan el estándar HDR. Sin embargo PlayStation 4 Pro soporta solo el estándar HDR10 pero, luego Microsoft también añadió el soporte para Dolby Vision el pasado mes de octubre de 2018.

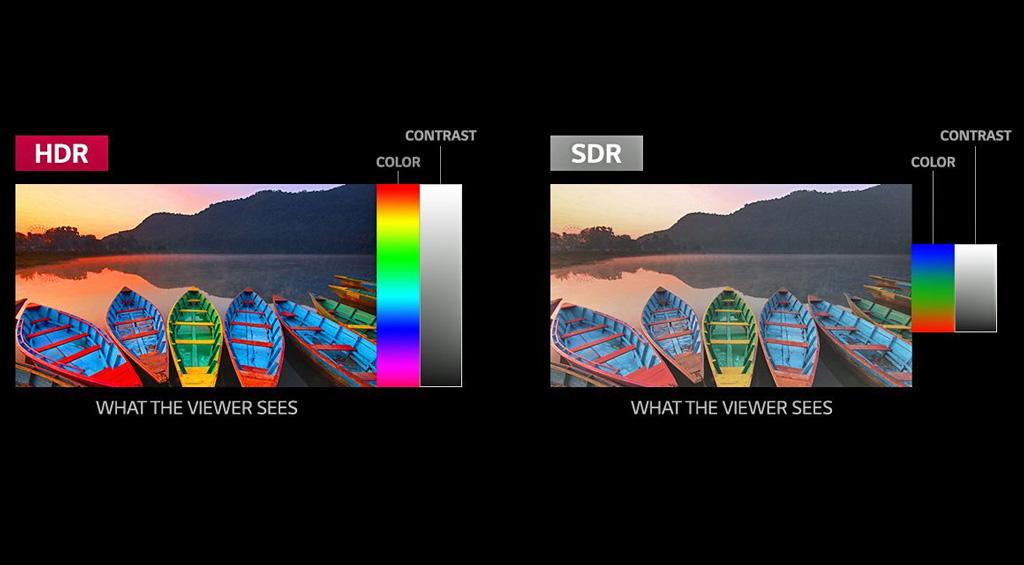

Uno de los problemas que presenta el HDR es que requiere mayor ancho de banda para transmitir la imagen. Al fin y al cabo, es mucha mayor información la que se está transmitiendo al televisor o al ordenador, de manera que se hacen necesarias conexiones a Internet bastante decentes para disfrutar de ese contenido. Por no contar que la mayoría de televisores y monitores que proclaman que tienen HDR, en realidad no lo tienen, dado que, para esa tecnología,son necesarios paneles con color de 10 bits (dado que se representan más colores en la imagen). Pero incluso algunos paneles que afirman poseer HDR10, no tienen el suficiente brillo como para poder hacerlo.

Necesitamos el HDR en nuestros monitores y televisores

La respuesta es que no. Al menos, por el momento. Dado el cajón de sastre que son todos los diferentes estándares que hay circulando entre televisores y monitores de ordenador, sin que vayamos a saber cuál de las dos tecnologías acabará siendo al campeona de esta prueba de resistencia que es el mercado, la realidad es que lo mejor que podemos hacer es sentarnos a ver qué bandazos acaba dando el mercado de la imagen y actuemos en consecuencia. No solo esto, sino que los actuales estándares son susceptibles de cambiar de un día para otro y dejar anticuados nuestro flamante monitor o televisor.