Antes de nada vamos a dejar claro (además de que ya lo dice en el título) que lo que manejamos en éste artículo es solo un rumor y como tal lo trataremos. En cualquier caso, según un reporte publicado por Bitsandchips las primeras muestras de GPU de arquitectura NVIDIA Pascal tienen serias dificultades para superar el rendimiento de la anterior generación, Maxwell, en cuanto a cómputo asíncrono.

Se supone que Pascal será un gran salto generacional con respecto a Maxwell, una arquitectura totalmente nueva con nueva litografía, nuevo controlador de memoria y que promete un enorme salto de rendimiento. Sin embargo los primeros reportes preliminares muestran que a pesar de tener un FP64 muy superior a Maxwell, las GPUs NVIDIA Pascal apenas superan por unas décimas los resultados obtenidos con las GPUs NVIDIA Maxwell, por lo que podríamos estar ante una enorme decepción en ciernes. El reporte incluso menciona que NVIDIA espera ganar a Maxwell por números brutos «a pelo».

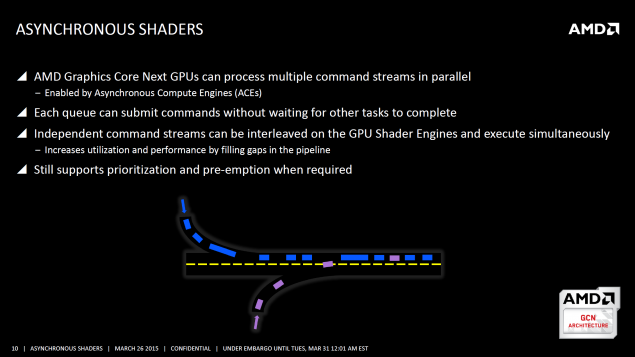

La computación asíncrona ha sido el punto fuerte de las GPUs AMD Radeon desde que DirectX 12 entró en escena, y los de rojo están liderando todas las clasificaciones de rendimiento en DirectX 12 a día de hoy gracias a que sus GPUs son capaces de manejar varios procesos asíncronos de manera simultánea. Las GPUs de NVIDIA superan a las de AMD bajo DirectX 12 en el caso de que se desactive la computación asíncrona. Según el reporte que hemos mencionado antes esto es así porque NVIDIA ha desactivado ésta característica directamente a nivel de software porque su hardware no es capaz de procesar varias tareas asíncronas de manera concurrente.

En teoría las GPUs NVIDIA Pascal utilizan una técnica llamada «pre-emption» para paliar ésto. Según NVIDIA, la computación asíncrona es ineficiente y han optado por utilizar otro sistema para procesar los frames en los juegos, y éste es el motivo por el que los analistas no son capaces de ver predicción de frames cuando se fuerza a las gráficas NVIDIA a utilizar computación asíncrona.

Los resultados por el momento le dan la razón a AMD, y demuestran que NVIDIA se equivoca al decir que es ineficiente, aunque habrá que ver qué ocurre cuando tengamos los modelos finales en el mercado y con los drivers optimizados, ya que ésto parece que está sucediendo de ésta manera a nivel de software.