Hace algunos años, cuando la mayoría de nosotros teníamos monitores de resolución 1024 x 768 o incluso 1280 x 1024 píxeles, los fabricantes nos decían que eso se veía borroso y que para tener la mejor calidad de imagen necesitábamos dar el salto a la resolución Full HD (1920 x 1080). Ahora el 4K está en boca de todos y resulta que es el Full HD el que se ve borroso, y que necesitamos comprar un monitor de mayor resolución para tener la mejor calidad de imagen. ¿Hasta qué punto es esto verdad?

Normalmente, podemos pensar que esto se trata de una estrategia de marketing, y realmente es precisamente eso: han creado mejores monitores y quieren venderlos, así que nos dicen que lo que tenemos ahora no vale y que necesitamos gastar dinero en su nuevo producto. Pero, en realidad, también estamos mejorando la calidad de imagen… ¿o no es así?

¿Más resolución implica mejor calidad de imagen?

Si nos atenemos a los datos empíricos, una pantalla Full HD tiene 1920 x 1080 píxeles, o lo que es lo mismo, algo más de 2 millones de píxeles. Una pantalla Ultra HD tiene una resolución de 3840 x 2160 píxeles, cerca de 8,3 millones de píxeles, cuatro veces más. Esto significa que en el mismo espacio estamos integrando muchísimos más píxeles, así que lo que tendremos es una mayor definición, siempre y cuando estemos hablando del mismo tamaño de pantalla.

Y este es un dato importante, el tamaño de la pantalla, porque lo que nos da definición no es la resolución o el número de píxeles, sino la densidad de píxeles.

La densidad de píxeles es el factor clave para la definición

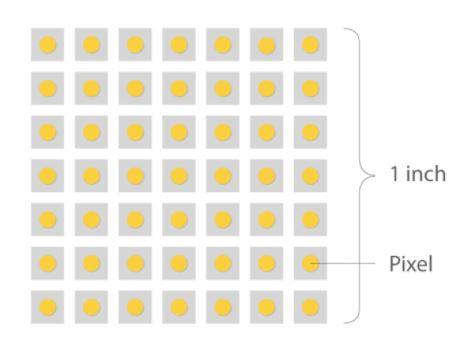

La densidad de píxeles en un monitor se mide en puntos por pulgada (DPI en inglés por «dots per inch») pero dado que se refiere al número de puntos que se encuentran dentro de una línea de una pulgada de exploración, se dejaron de utilizar en favor de los PPI (píxeles por pulgada). Si bien PPI es el término correcto para referirse a monitores, ambos se suelen usar indistintamente.

La densidad de píxeles es importante porque es lo que determina la calidad de la imagen en el sentido de que, en general, una mayor densidad permitirá crear imágenes más definidas. Pongamos algunos ejemplos tomando como referencia un monitor de 27 pulgadas, que es algo bastante habitual y normal hoy en día:

- Un monitor 720p de 27 pulgadas tendría unos 54 PPI.

- Un monitor 1080p de 27 pulgadas tiene una densidad de unos 81 PPI.

- Si el monitor tiene resolución 1440p, su densidad sería de unos 108 PPI.

- Si pasamos a resolución 4K la densidad sube a 163 PPI.

- Un monitor 8K de 27 pulgadas tendría una densidad de 326 PPI.

Para poner estos datos en perspectiva, imaginad que tenéis dos monitores, uno al lado del otro, y ambos con resolución Full HD. Si uno de ellos tiene un tamaño de 32 pulgadas mientras que el otro tiene 27 pulgadas, si acercas la vista podrás ver una diferencia evidente en cuanto al tamaño de los píxeles, puesto que aunque ambos monitores tengan la misma cantidad, la densidad del de 27 pulgadas será mucho mayor, sus píxeles serán más pequeños y, por lo tanto, proporcionará una mejor definición.

Otro ejemplo al respecto de la densidad: imaginad un monitor 4K de 1000 pulgadas (exagerando). Siendo así, veremos que los píxeles tienen un tamaño considerable porque la densidad sería muy baja, y en consecuencia la calidad de imagen será mala por mucho 4K que sea.

La distancia de visionado en lo importante

El motivo por el cual preferimos grandes pantallas cuando vemos la televisión o jugamos a la consola en el sofá es por el hecho de que el tamaño relativo de los píxeles con la distancia disminuye y se llega al punto en que el tamaño de los píxeles es tan pequeños que no se ven ya como unidades separadas.

Dependiendo del tamaño en pulgadas de nuestro monitor, para disfrutar de la mejor experiencia visual, existe una fórmula que nos permite conocer cuál es la distancia de pantalla recomendada. Para conocer cuál es la distancia en centímetros que permitirá disfrutar de la máxima calidad en base a las pulgadas de un monitor debemos multiplicar las pulgadas por 3,04.

De esta forma, si nuestro monitor es de 24 pulgadas, la distancia recomendada la obtenemos al multiplicar 24 pulgadas x 3,04 que es igual a 72,96 cm, unos 70 centímetros. Esta es una pauta recomendada que se utiliza principalmente para televisores de gran tamaño pero que también podemos aplicar a monitores de menores dimensiones, aunque, al final, el usuario es quien decide cuál es la distancia que le permite disfrutar de la mejor calidad de su monitor.

Obviamente, esto no se aplica a las gafas de realidad virtual que tienen pantallas con una mayor densidad de píxeles por pulgadas,. Es necesario que tenga una elevada densidad de píxeles ya que al estar tan cerca de los ojos, se trata de que el usuario no pueda ver los píxeles rompiendo por completo la calidad de imagen y evitando que usuario considere realmente que está evadiendo de la realidad.

Entonces, ¿cuánto mayor sea la densidad de píxeles, mejor?

La respuesta es sí y no. En general, una mayor densidad de píxeles es mejor porque proporciona una mejor definición de las imágenes, pero hay cierto punto en el que el rendimiento decrece. A medida que la densidad aumenta más y más, las ventajas observables de esa mayor densidad son cada vez menos evidentes hasta llegar al punto de que son imperceptibles para el ojo humano.

En el ejemplo de antes, el monitor Full HD de 27 pulgadas tendrá una densidad de unos 81 PPI, mientras que el de 32 pulgadas tendrá 69 PPI. En esta situación es seguro decir que habrá diferencias observables entre ambos monitores, pero si estuviéramos hablando de dos monitores de 24 pulgadas, los dos, uno con resolución 4K y otro 8K, la diferencia sería imperceptible, y, sin embargo, obviamente procesar imágenes a resolución 8K tiene un coste de rendimiento mucho mayor que hacerlo a 4K.

Llegados a este punto, es tema de debate el punto exacto de densidad en el que el ojo humano deja de percibir los cambios. Algunos expertos dicen que esa cifra se sitúa en torno a los 400 PPI, otros dicen que 1000, y la mayoría de usuarios nos conformamos con incluso menos de 200. Sea cual sea ese punto, lo que es evidente es que llega cierto momento en el que deja de apreciarse una mayor densidad de píxeles.

Un ejemplo ligado a esto que seguro que muchos conocéis es el de los iPhone, siempre se ha comparado sus características con otros móviles de peor calidad por tener siempre una cantidad de megapíxeles de cámara muy bajo, y eso, sin embargo, no quiere decir que su foto sea peor, todo lo contrario, ahí importa la lente no el tamaño de la imagen, con esto pasaría algo parecido, llega un punto en el que no es importante aumentar esa cantidad, ya que sería casi inapreciable.

La calidad de imagen, ligada pero no atada a la resolución

Volviendo al tema principal, según Dolby la calidad de imagen que percibimos las personas (porque al fin y al cabo es una cuestión subjetiva de percepción) depende principalmente de tres factores:

- El número de píxeles (y su densidad, como hemos explicado).

- La tasa de cuadros por segundo.

- Las prestaciones de los píxeles.

Es en este último punto en el que los fabricantes de paneles para monitor han estado haciendo hincapié en los últimos tiempos, ya que -según Dolby- si se logra que incluso con el mismo número de píxeles estos sean capaces de representar una gama dinámica mayor y con un espacio de color más grande, se mejora la calidad de reproducción. Y en lo que a nosotros respecta no podríamos estar más de acuerdo, ya que no todo es resolución cuando hablamos de calidad de imagen, sino que en términos de experiencia de usuario, influyen y mucho los FPS y las tecnologías asociadas, como el HDR por ejemplo.

Además, hay una ventaja clave con respecto a esto, puesto que realmente a mayor PPI realmente menor número de efectos visuales debemos usar en cualquier juego, principalmente porque no son necesarios. Ya en un monitor de 27 pulgadas y 4K la definición es tan por norma general que usar algo tan trivial como Antialiasing se convierte en una pérdida de rendimiento tonta, puesto que a nuestros ojos no hay diferencia, es imposible visualizarla ni siquiera pegando la nariz al panel.

Por lo tanto, más que la resolución como «estándar» a la hora de definir calidad de imagen (como hemos visto, todo es muy subjetivo), tendríamos que hablar realmente de PPI = mayor calidad de imagen, sea la resolución que sea y el tamaño de la pantalla que tengamos.