Todo aficionado al hardware estará al tanto de los «tanteos» de NVIDIA con respecto a ARM en los últimos tiempos, y a expensas de ver qué pasa con la adquisición que se ha convertido en el culebrón del año, la compañía de verde sigue intentando promover la arquitectura ARM en todos los nichos de mercado. Ahora, han aparecido datos de rendimiento de un servidor equipado con una GPU A100 y CPU ARM con un rendimiento muy similar al de los servidores x86 (aunque por el momento x86 sigue teniendo un rendimiento pico más elevado).

A despecho de la arquitectura ARM hay que decir que, como siempre, si bien ARM puede superar a x86 en escenarios de bajo consumo y alta eficiencia por el momento es incapaz de escalarla a escenarios de alto rendimiento. Esta es de hecho una de las razones por las que los chips Apple A15 se han convertido en una (relativa) decepción por ahora, así que en un entorno de servidores donde se busca siempre la máxima potencia, en teoría ARM no tiene nada que hacer… ¿o sí? Eso es lo que piensa y defiende NVIDIA.

Un servidor con NVIDIA A100 y CPU ARM vence a uno con x86

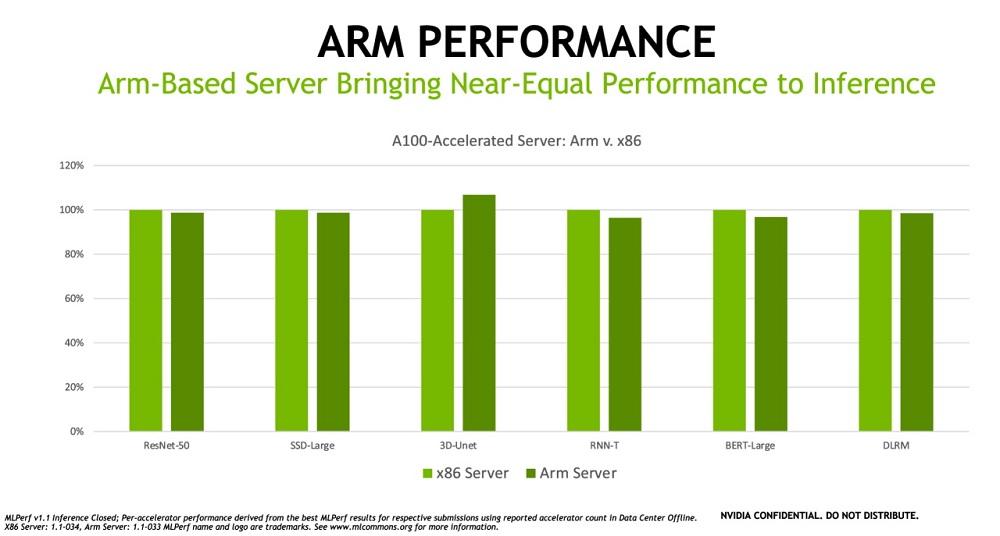

Como podéis ver en la gráfica superior, el servidor equipado con CPU ARM está prácticamente a la altura del que tiene una CPU x86, y de hecho logra superarlo por bastante en el nicho 3D-Unet, mientras que en los más comunes como pueden ser las cargas de trabajo bajo ResNet 50 siguen estando dominados por x86… aunque por muy poca diferencia en realidad.

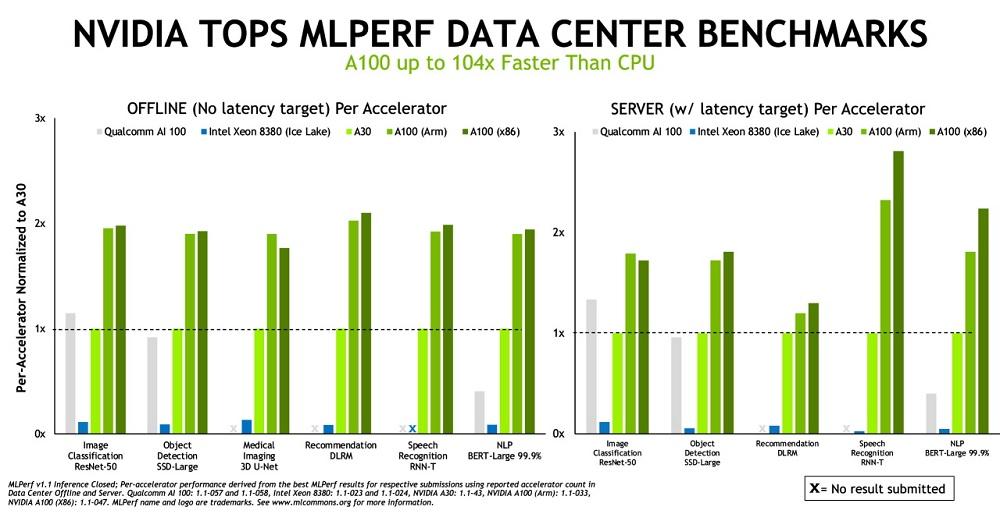

Obviamente, cuando hablamos de inferencia una CPU jamás podrá superar el rendimiento de una GPU independientemente de su arquitectura. Por este motivo, NVIDIA no se ha cortado un pelo a la hora de afirmar que su GPU A100 ARM es hasta 104 veces más rápida que una CPU en los puntos de referencia MLPerf.

«La inferencia es lo que sucede cuando un ordenador ejecuta un software de Inteligencia Artificial para intentar reconocer un objeto o realizar una predicción. Este proceso utiliza un modelo de Deep Learning para filtrar los datos y encontrar los resultados que ningún ser humano sería capaz de realizar. Los puntos de referencia de inferencia de MLPerf utilizan las cargas de trabajo y escenarios de IA más populares a día de hoy (abarcan nichos como las imágenes médicas, procesamiento de lenguaje, etc.).». – dijo David Lecomber, director de HPC y herramientas de ARM.

Por supuesto, estamos hablando de una comparativa que no es demasiado justa (una GPU contra una CPU) puesto que cada elemento ha sido diseñado con una finalidad definida, pero también por supuesto NVIDIA, defensora a ultranza de la arquitectura ARM, parece estar buscando cualquier excusa para promocionar lo que en este momento más les interesa. Por este motivo, podemos ver en la gráfica superior como la GPU NVIDIA A100 ARM reina en todo lo que han probado con ella, desde la popular prueba comparativa de clasificación de imágenes (mediante IA) ResNet-50 hasta el procesamiento de lenguaje natural.

Como sabréis si habéis seguido el culebrón NVIDIA-ARM de los últimos tiempos, la compañía comandada por Jen-Hsun Huang todavía se encuentra enfrentándose a obstáculos regulatorios que están impidiendo su compra, así que la compañía está comenzando a realizar presiones por otros derroteros, que como en este caso abarcan también el ecosistema de los servidores.

En cualquier caso, y si bien esto no es algo que vaya a suceder a corto plazo, lo que sí parece que tiene fundamento es que el reinado de la arquitectura x86 en servidores comienza a verse amenazada por ARM.