DICE publica sus propios números acerca del rendimiento de Mantle

Hoy parece «el día AMD» pero es que no es para menos. Como publicamos esta mañana, DICE ya ha lanzado el parche para Battlefield 4 que habilita la API Mantle, y no han perdido el tiempo para publicar sus propios resultados de rendimiento obtenidos en su laboratorio. Se entiende que los datos de rendimiento que han mostrado han sido obtenidos en sus propias pruebas internas antes de lanzar el parche, por supuesto.

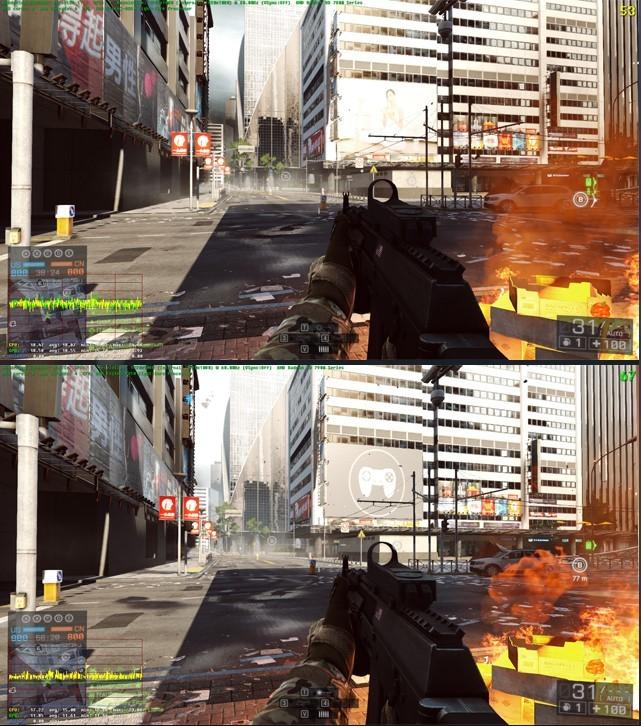

Los resultados que os vamos a mostrar a continuación representan la diferencia de rendimiento entre utilizar Battlefield 4 con la API Mantle o con DirectX 11.1. DICE ha probado el juego en tres escenarios de Gaming: básico, medio y entusiasta. Destacar que el escenario básico cuenta con una APU AMD A10-7850K con su gráfica AMD Radeon R7 integrada (512 stream processors, 720 MHz GPU clock), es decir, es un escenario donde el juego está limitado tanto por CPU como por GPU, y tal y como hemos explicado esta misma tarde es donde más efecto debería tener Mantle en la mejora de rendimiento. A una resolución de 1280 x 720, DICE obtuvo unos resultados un 14% mejores con la API Mantle.

En cuanto al escenario medio, en DICE han empleado un procesador AMD FX-8350 (cuyo rendimiento en juegos es similar al de un Core i5-3570K) con una tarjeta gráfica AMD Radeon HD 7970. Con una resolución Full HD (1920 x 1080) 1xMSAA y los gráficos en Ultra, DICE ha obtenido una mejora de rendimiento de un 26%, lo cual ya es muy, muy notable (de 53 a 67 FPS).

Por último, la configuración entusiasta, consistente en un procesador Core i7-3960X y dos AMD Radeon R9 290X en CrossFire. Con una resolución Full HD (1920 x 1080), 4xMSAA y los gráficos en Ultra, el incremento de rendimiento ha sido de nada más y nada menos que un 58% de diferencia en favor de Mantle (¡¡de 78 a 116 FPS!!).

Como véis, un incremento de rendimiento notable, incluso superior al 45% prometido en primera instancia en la configuración entusiasta. Por nuestra parte, en cuanto tengamos disponibles todos los materiales necesarios os presentaremos nuestro propio análisis en nuestro banco de pruebas con una Radeon R9 290X.