La forma en que las GPU generan los gráficos a tiempo real nos parece magia, pero todas ellas siguen el mismo procedimiento y las mismas etapas. Es por ello que hemos decidido organizar un viaje a través del pipeline 3D, el cual es común para todas las API y todas las arquitecturas 3D.

En informática un pipeline son una serie de pasos ordenados y repetidos hasta la saciedad para realizar una tarea. En el caso del pipeline 3D ha sido el mismo desde hace ya décadas y los cambios han sido en pequeñas optimizaciones del mismo.

Es por ello que vamos a hacer un viaje a través del pipeline 3D, de manera completamente genérica y sin centrarnos en ningún tipo de arquitectura de GPU o tarjeta gráfica en concreto.

Programas shader en el pipeline gráfico

Un Shader no es más que un pequeño programa escrito en un lenguaje de alto nivel que se utiliza para modificar una primitiva gráfica, ya sea un vértice o un pixel. Estos programas son ejecutados varias veces durante el pipeline gráfico por una serie de unidades que realmente son procesadores en sí mismos a los que llamamos unidades shader.

Durante varias etapas del pipeline los datos entran desde las unidades shader a otras unidades del mismo tipo y las de función fija. A día de hoy no existe un tipo de unidad shader especializada para cada tipo de shader, sino que se hace uso de un procesador genérico. Al fin y al cabo pese a que nosotros podemos diferenciar un vértice de un pixel para un procesador no son más que datos en binario que procesar.

La primera etapa del pipeline 3D ocurre en la CPU

Una GPU no es una CPU, es algo obvio, pero se ha de aclarar por el hecho de que no funcionan igual. El motivo de ello es que una GPU no ejecuta un sistema operativo y tampoco un programa, sino que su trabajo es leer una lista de pantalla que escribe la CPU y que no es más que una lista de instrucciones de cómo ha de dibujar el siguiente fotograma.

Dicha lista es escrita por la CPU en una parte de la RAM principal, la GPU a través de una unidad DMA accede a la RAM principal y la copia. Dicha lista siempre se encuentra en la misma parte de la RAM y la tarjeta gráfica la consulta continuamente para generar cada uno de los fotogramas en pantalla.

La información que contiene la lista le va a permitir a la GPU componer una escena en 3D, además que integrará instrucciones para manipular los diferentes elementos. Dicha lista será procesada por el procesador de comandos de la GPU, el cual organizará el resto de los componentes del chip gráfico durante las diferentes etapas.

World Space Pipeline

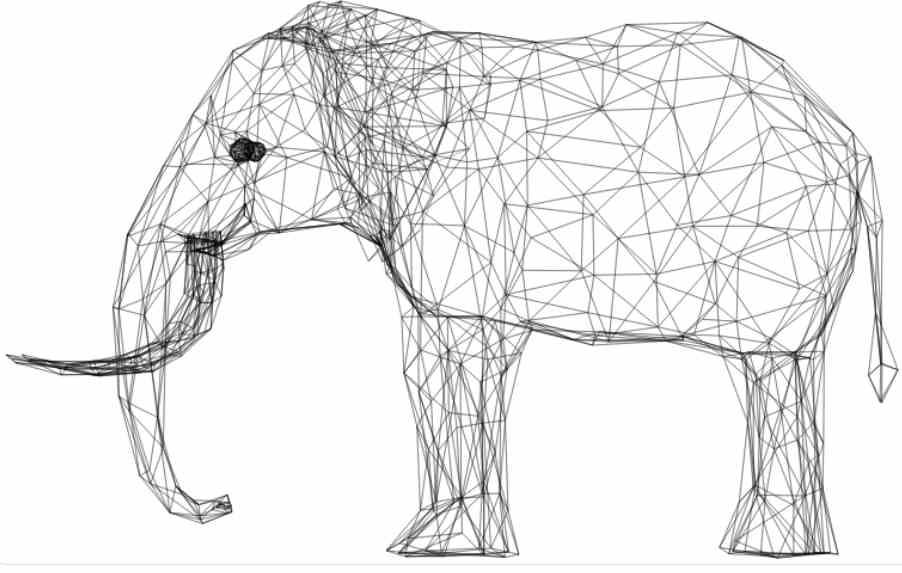

El World Space Pipeline es la primera mitad del pipeline para la creación de escenas en 3D a tiempo real que ocurre en la GPU, se llama así porque aquí es donde se ordenan y dibujan los elementos del mundo antes de proyectarlo. En esta parte se trabaja con vectores en un espacio tridimensional, mientras que en la segunda mitad del pipeline 3D se trabaja con píxeles.

Es a día de hoy la parte más ligera en cuanto a computación, lo cual resulta curioso por el hecho que en los albores de los gráficos en 3D era el cálculo de la geometría de la escena lo que más llevaba de cabeza a los ingenieros de cara a crear hardware capaz de mostrar gráficos en 3D a tiempo real.

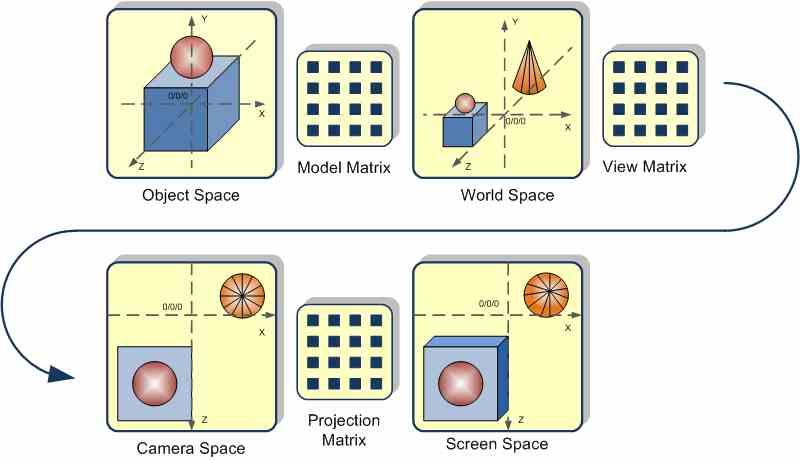

Segunda a quinta etapa del pipeline 3D: Matrices de transformación

Las matrices utilizadas durante el pipeline geométrico son una serie de operaciones aritméticas sucesivas, las cuales son realizadas de manera concatenada y corresponden a varias etapas del pipeline geométrico. No vamos a entrar en la parte matemática de los mismos por el hecho que queremos hacer las cosas lo más sencillas posibles.

Todas ellas se realizan en el siguiente orden y para cada uno de los objetos de una escena en 3D y son ejecutados por cada objeto en la escena.

- Model Matrix: La primera matriz transforma las coordenadas de cada uno de los objetos a coordenadas comunes.

- View Matrix: El segundo paso es rotar y desplazar cada objeto para así colocar cada objeto según el punto de vista de la cámara.

- Projection Matrix: Esta matriz lo que hace es transformar los objetos según la distancia de la cámara, haciendo que los cercanos se van más grandes y los más lejanos más pequeños.

Las GPU realizan todos los cálculos correspondientes a las matrices de transformación en las unidades shaders a día de hoy debido a que están tienen la suficiente potencia para hacerlo. En el pasado se habían utilizado unidades de función fija e incluso combinaciones entre función fija y parte programable, pero a día de hoy ya no es así y todo el World Space Pipeline se ejecuta en los shaders.

Tipos de Shader en el World Space Pipeline

El primero de ellos es el Vertex Shader, el cual es el más común y utilizado. Este nos permite modificar a través de un programa los valores de cada vértice como el color, la posición, su longitud e incluso la textura a la que están asociados El segundo y tercer tipo de Shader son los llamados Hull y Domain Shader, los cuales se utilizan solo en la teselación de la geometría. La cual consiste en crear nuevos vértices para un objeto tridimensional sin perder su forma externa.

El cuarto tipo es el Geometry Shader, fue típico de DirectX 10 y se ejecuta justo al final del pipeline geométrico, en el Geometry Shader se toma un grupo de vértices que forman una única primitiva y a través de un programa shader dichas vertices son transformadas para crear una nueva primitiva a partir de modificar la forma original.

A partir de DirectX 12 Ultimate estos cuatro shaders se han agrupado en dos shaders distintos llamados Amplification Shader y Mesh Shader. El primero de ellos no opera ninguna primitiva, sino que decide cuantos shaders se van a ejecutar y es completamente opcional. Los Mesh Shader en cambio vienen a reemplazar todos los shaders del World Space Pipeline en un tipo de shader único.

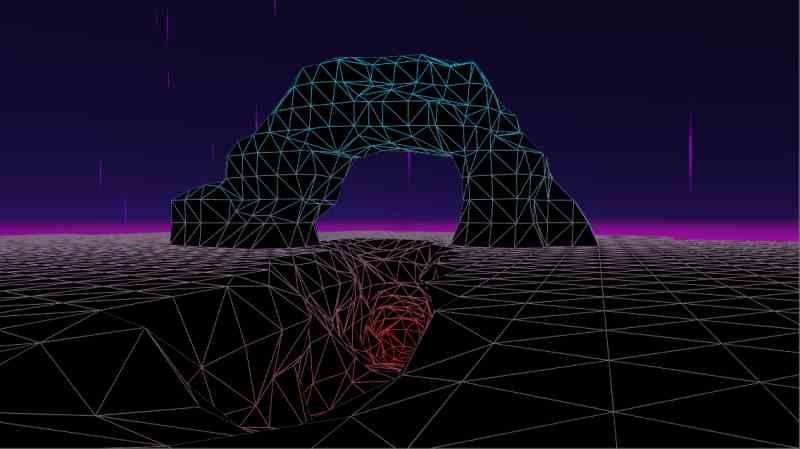

Screen Space Pipeline

El Screen Space Pipeline es la segunda mitad del pipeline 3D, donde los objetos son transformados al espacio en dos dimensiones de la pantalla y manipulados. En dicha etapa la GPU da color y textura los diferentes elementos que componen la escena para enviar después el resultado final al búfer de imagen.

Sexta etapa del pipeline 3D: Scan Conversion o rasterizado

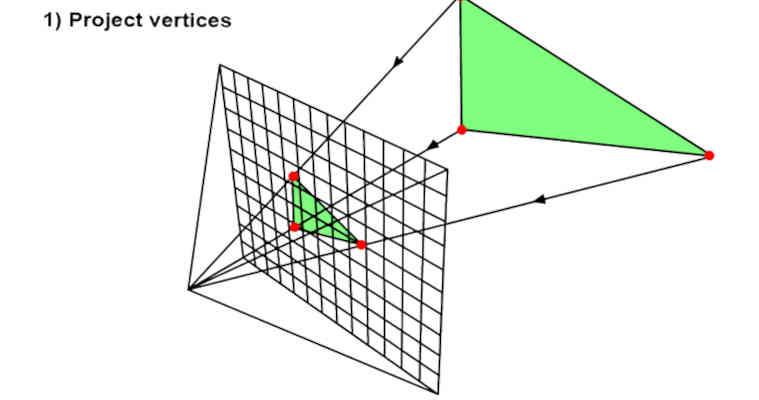

Al final del World Space Pipeline tenemos todos los objetos colocados de manera correcta según distancia y posición respecto a la cámara, por lo que es el momento de convertir la escena en una imagen en 2D. Donde en primer lugar lo que se hace es descartar el valor de profundidad de cada objeto respecto a la cámara, el cual se va a almacenar en un búfer de imagen llamado Z-Buffer donde se almacena la distancia de cada píxel respecto a la cámara en cada posición del búfer de imagen.

Este proceso es realizado en unidades especializadas dentro de las GPU, las cuales desde las primeras aceleradoras 3D forman parte integral de todos los chips gráficos dedicados a renderizar este tipo de gráficos. Debido a que es el propio hardware el que realiza este trabajo

Una vez terminado el proceso de rasterizado, viene el de texturizado donde los fragmentos son enviados de nuevo a las unidades Shader para el texturizado y la aplicación de los Pixel Shaders.

Séptima etapa del pipeline 3D: texturizado

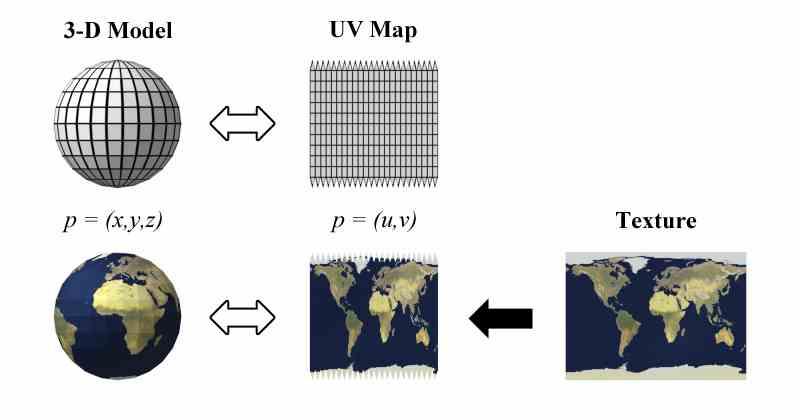

El siguiente paso es el de dar textura a los diferentes fragmentos, para visualizar el concepto os tenéis que imaginar que por un lado tenemos una serie de superficies que son los fragmentos y por el otro tenemos una serie de adhesivos que tenemos que engañar a cada fragmento.

Desde el inicio del pipeline cada una de las superficies tiene asignados una serie de parámetros y entre ellos la dirección de memoria donde se encuentran las texturas, para que así se puedan aplicar de manera correcta las texturas sobre la superficie, para que cada píxel quede en su posición correcta.

La colocación de las texturas es realizada por unidades especializadas que se encuentran dentro de la GPU, a día de hoy se encuentran en las unidades encargadas de ejecutar los programas shader y conectadas a la caché de datos de primer nivel.

La caché de datos/texturas y el filtrado de texturas

En todas las GPU habréis observado que la unidad de filtraje de texturas está muy cercana a las unidades de cálculo que ejecutan los shaders, así como una caché de datos también llamada caché de texturas.

Las ALU de las unidades shader ejecutan siempre los datos que se encuentran en sus registros, pero hay momentos en los que es necesario acceder a datos alejados de estos y por ello son traídos con un sistema de cachés, incluido como es obvio las propias texturas o fragmentos de las texturas.

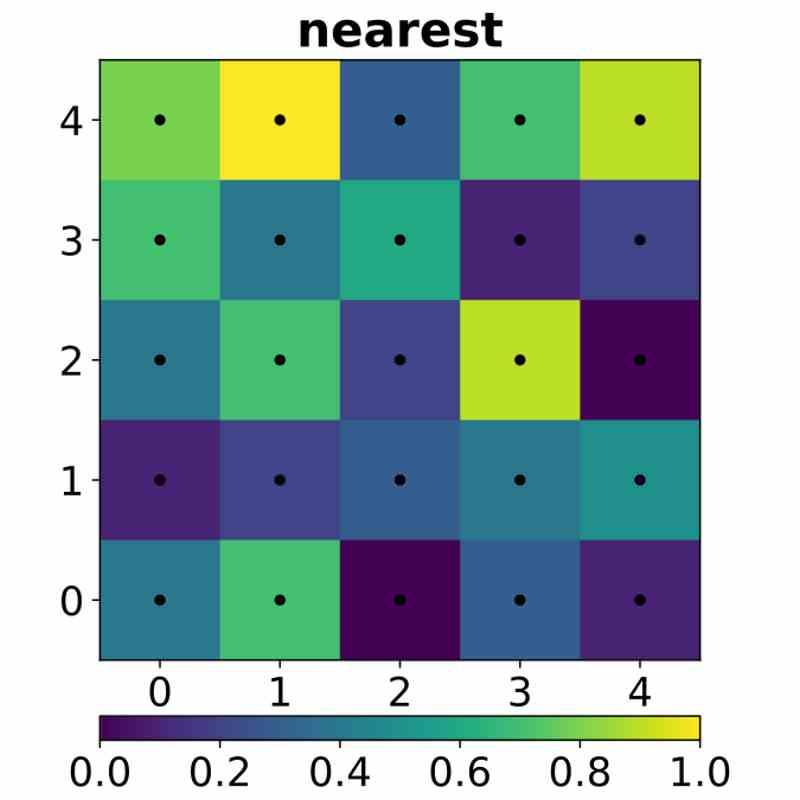

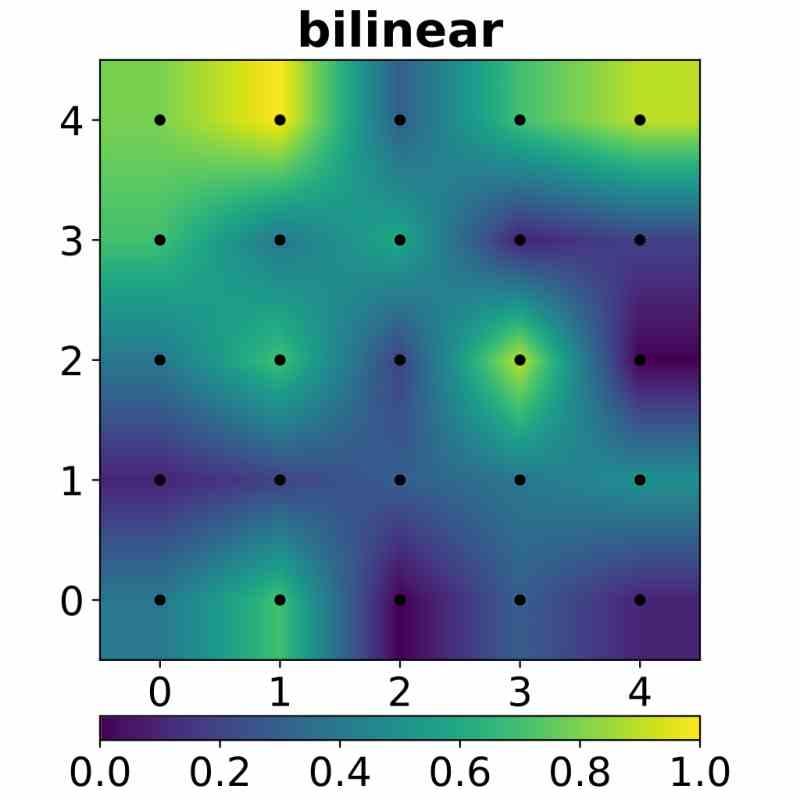

Estas texturas llegan sin estar filtradas, lo que provoca un efecto de pixelado, el cual es corregido a través de efectos de interpolación. El más básico es la interpolación bilineal, el cual consiste en interpolar los valores de 4 píxeles colindantes. De ahí a que en todas las GPU todas las unidades de texturas se agrupen en las unidades shader de 4 en 4.

Pixel Shaders

Solo hay un tipo de shader que se utiliza en el Screen Space Pipeline, este es el Pixel Shader y consiste en poder manipular los valores de los píxeles a través de una serie de programas, siendo uno de los dos tipos de shader esenciales junto al Vertex Shader.

Es precisamente el Pixel Shader la parte de más carga computacional de todo el pipeline gráfico, el motivo de ello es que un triángulo puede estar formado por tres vértices, pero una gran cantidad de píxeles. Además, debido a que las GPUs trabajan con fragmentos de 2×2 píxeles de manera interna en cada unidad Shader, su funcionamiento es distinto al resto de los shaders y es el único tipo que trabaja con datos fuera de los registros.

Última etapa del pipeline 3D: Render Output

La parte final es el Render Output, una serie de unidades que copian el resultado final de cada píxel en el búfer de imagen final, el cual habitualmente se encuentra en la VRAM, pero los sistemas más modernos escriben en la caché L2 de la propia GPU para acelerar el postproceso.

Las unidades encargadas de esta etapa son los llamados Render OutPut, abreviado ROP y en plural ROPS. Tienen su origen en las unidades Blitter del Commodore Amiga y el Atari ST. Las cuales realizan un traslado de un bloque de datos de una memoria a otra con una instrucción por el medio.

Tras esta etapa la imagen se encuentra ya en el búfer de imagen y completamente terminada la imagen final para ser reproducida en la pantalla del usuario. También es posible que se realicen efectos de post-procesado, pero esto ya está fuera del pipeline 3D y son realizados como si se manipulase una imagen en 2D.