Uno de los apartados más críticos de una tarjeta gráfica es sin duda su memoria RAM (VRAM). Hasta ahora, las VRAM se han centrado en dos tipos distintos diferenciados por dos aspectos: rendimiento y costes, por lo que dependiendo del sector donde esté enfocada la tarjeta, el tipo de memoria podría ser HBM o GDDR. La última novedad en GDDR ha sido su sexta versión, pero ¿qué novedades traen los fabricantes de HBM? Lo nuevo toma por nombre memoria HBM2E, la «E» de evolución.

Samsung y SK Hynix van a volver a liderar un apartado tan importante como es el de la memoria de alto rendimiento, ya que ambos han presentado ya sus nuevos módulos de memoria HBM2E y como es lógico, ambos cumplen con la especificación del JEDEC.

La tecnología HBM había llegado a un límite físico que ahora se ha roto

Las nuevas GPU tendrán un apartado que con total seguridad no gustará a ningún usuario: el precio. Y es que esto parece que va a ser una constante, al menos en la gama alta o elitista, ya que tanto NVIDIA como AMD tendrán que rascarse el bolsillo si pretenden aumentar el rendimiento de sus GPU.

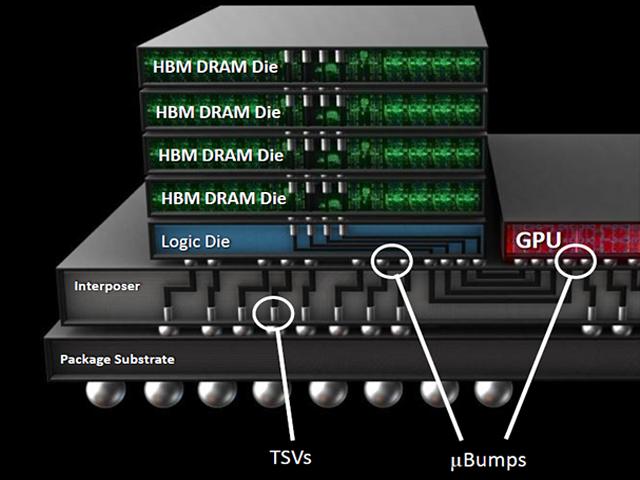

Lo cierto es que HBM y HBM2 como tal estaban llegando a un límite bastante curioso, debido principalmente a la longitud de los cables de interconexión de las TSV. Las HBM tienen la particularidad de que necesitan estas vías de interconexión y ello requiere miles de ellas por cada milímetro cuadrado, lo que necesita una ingeniería eléctrica muy superior a las simples GDDR6.

Esto lógicamente ha limitado las configuraciones de las pilas HBM, lo que directamente influye en el rendimiento y la capacidad de las mismas. Debido a las restricciones físicas entre la memoria, las TSV y el interposer, todo se limita versión tras versión a aumentar o al menos mantener el ancho de banda y poco a poco mejorar la velocidad y capacidad de la VRAM.

Mejoras de la memoria HBM2E para las GPU

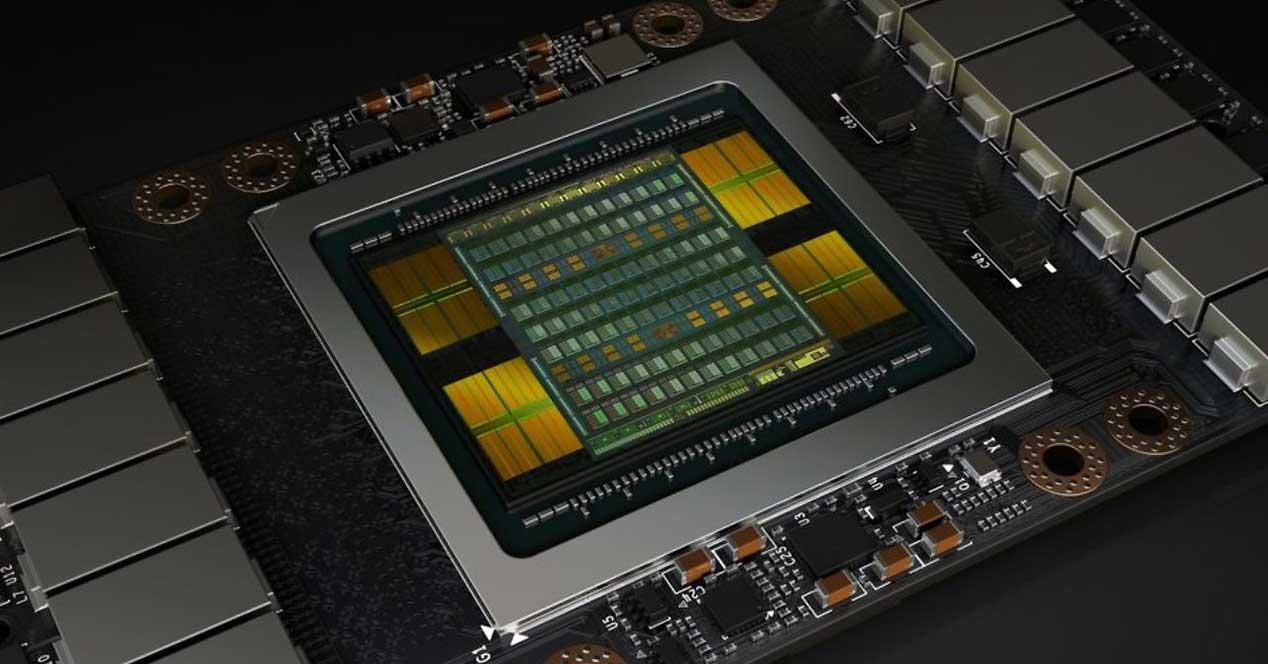

Toda GPU de alto rendimiento requiere un ancho de banda gigantesco, pero este siempre tiene que ir acompañado de una capacidad de cómputo o bien individual o bien paralelizable. Por ello, la gran mayoría de GPUs con HBM de cualquier versión se usan en centros de datos o centros de entrenamiento para IA.

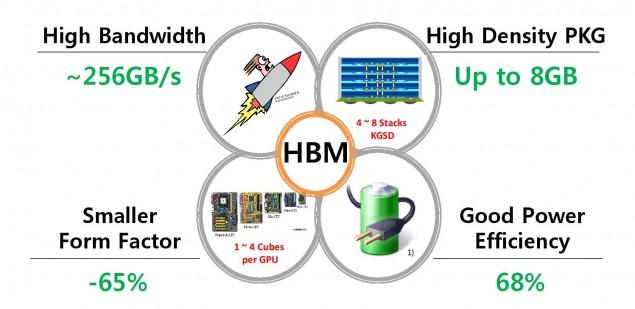

Samsung ha revelado que ha terminado de romper la barrera de los problemas de HBM y HBM2 con su nueva HBM2E Flashbolt, donde según han comentado han logrado un salto del 33% en el rendimiento (frecuencia de 1,2 GHz y voltaje reducido a 1.2V). Las novedades son bastante curiosas, ya que se mantendrá el ratio por pila de HBM de cuatro troqueles a modo de dos canales de 128 bits por troquel para un total de 8 canales y bus de 1024 bits.

En cambio, se ha duplicado la frecuencia para dos gigacanales, donde para ello se ha tenido que aumentar la interfaz en unos bits únicos que permitan una mayor capacidad de dirección y así lograr una velocidad de 3,2 gigatransfers por segundo.

Esto sigue sin ser una velocidad muy alta, pero deja un diseño más simple con un ancho de banda brutal que permite mantener la potencia y la complejidad del diseño de los ASIC, permitiendo que no haya que preocuparse demasiado por la integridad de las señales.

La capacidad será otra de las mejoras clave que demanda el mercado, pero curiosamente ni Samsung ni SK Hynix han querido comentar nada acerca de este parámetro. Lo que se espera es una duplicidad literal de 16 GB a 32 GB, donde aparte de una mayor velocidad general se añadirá el soporte para ECC, algo requerido en inteligencia artificial.

La IA y el DeepLearning respirarán tranquilos, los gamers no tanto

El progreso no se detiene y los centros de datos están viendo como sus operaciones y cálculos están necesitando de una mayor capacidad de VRAM para sus GPUs. Si la capacidad aumentase un 50%, se escala en capacidad de cómputo casi a igual cifra, por lo que es altamente rentable para este tipo de sector el hecho de que HBM2E llegue al mercado.

¿Qué hay del gaming? Las últimas filtraciones dicen que Intel llegará al mercado con sus GPUs para jugadores con memoria HBM2E directamente, pero aunque no está confirmado, también existe la posibilidad de que esto sea solamente para los HPC, debido a la segmentación de la arquitectura que planean los azules.

El problema de HBM2E para gaming es su alto coste y su poca disparidad de rendimiento en cuanto a ancho de banda con GDDR6, donde se esperan los nuevos módulos de 16 Gbps. En ese caso, aun teniendo un ancho de banda mucho mayor, la diferencia de rendimiento no compensa el coste salvo que la GPU requiera dicho bus.

Por lo tanto, las limitaciones en GPUs de escritorio para jugadores vienen influenciadas de nuevo por el coste y la velocidad, algo que HBM3 debería resolver de un plumazo.

El costo se dispara

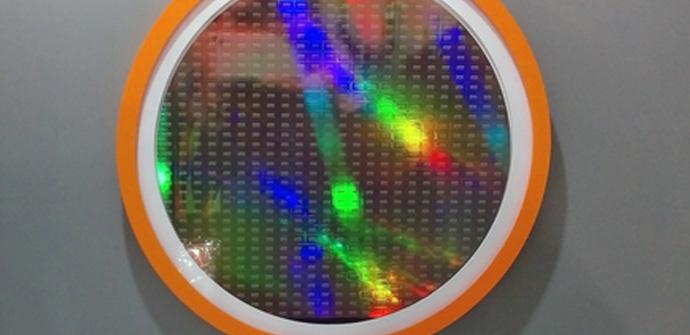

Se estima que una oblea de HBM cuesta, aproximadamente, casi 2000 dólares, un 30% más que lo que vale el mismo tamaño de oblea para DRAM. Debido a su naturaleza y tecnología, este tipo de memoria solo es aprovechable en escenarios muy concretos, por lo que el mercado no la demanda tanto como la DRAM normal y el coste sigue siendo alto.

No ha habido una adopción general de la industria, lo que sumado a los retrasos de HBM2E no dejan un panorama mucho mejor para los años venideros. Lo único positivo de esto es que esta nueva memoria es solo un paso para contentar al mercado específico de GPUs y que HBM3 por sus características es posible que abra el abanico a más productos en diferentes sectores, abaratando el coste y haciéndola más asequible.

Curiosamente y para finalizar, ha sido Micron la que se ha vuelto a adelantar a Samsung e Hynix, ya que ha anunciado la disponibilidad de su sucesor en un breve periodo de tiempo, así que es posible que este tipo de memoria quede en desuso más rápido de lo que esperamos.

Eso a pesar de que NVIDIA y AMD la han adoptado de buena manera, pero el rendimiento manda y si Micron ofrece esta memoria a un precio muy ajustado seguramente ningún fabricante se plantee volver a HBM2E.