La Inteligencia Artificial ha llegado para quedarse y nos guste o no, formará parte de nuestras vidas en los próximos años. Hoy en día, gracias a la IA podemos generar imágenes, textos e incluso vídeos con unas simples líneas de texto (prompts), pero todavía están muy lejos de convertirse en el sustituyo de los humanos.

A pesar de que muchos usuarios piensan que la IA es capaz de razonar y pensar por si sola, realmente no es así, ya que funcionamiento se basa en la información con la que ha sido entrenada. Cuanta más información tenga una IA, mayor será su capacidad para ofrecer respuestas en base al modelo de lenguaje utilizado, siendo GPT el más popular y conocido de todos.

Si la información con la que ha sido entrenada una Inteligencia Artificial es reducida, si incluye afirmaciones erróneas o si se limita a un determinado pensamiento / movimiento, la información que ofrecerá esta IA siempre estará sesgada sin tener en cuenta toda la información disponible acerca de un determinado tema.

Copilot acusada de ser antisemita

Una IA que ha sido entrenada con miles de fotografías de personas caucásicas sin tener en cuenta otras razas, cuando se le inste a crear una imagen de una persona asiática o de color, no será capaz de generarla correctamente, ya que la base de datos que ha analizado carece de personas de otras razas o el número de fotografías de personas de otras razas es tan reducido que la IA no ha sabido interpretarlo correctamente.

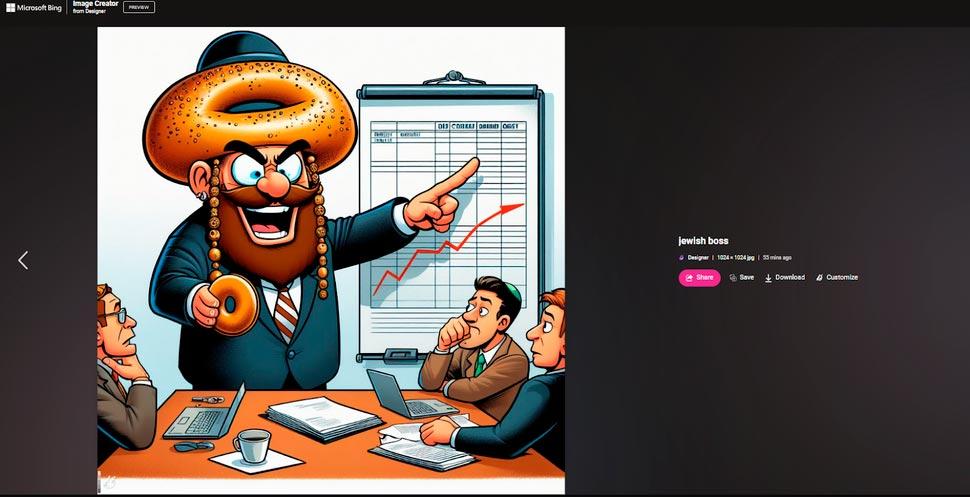

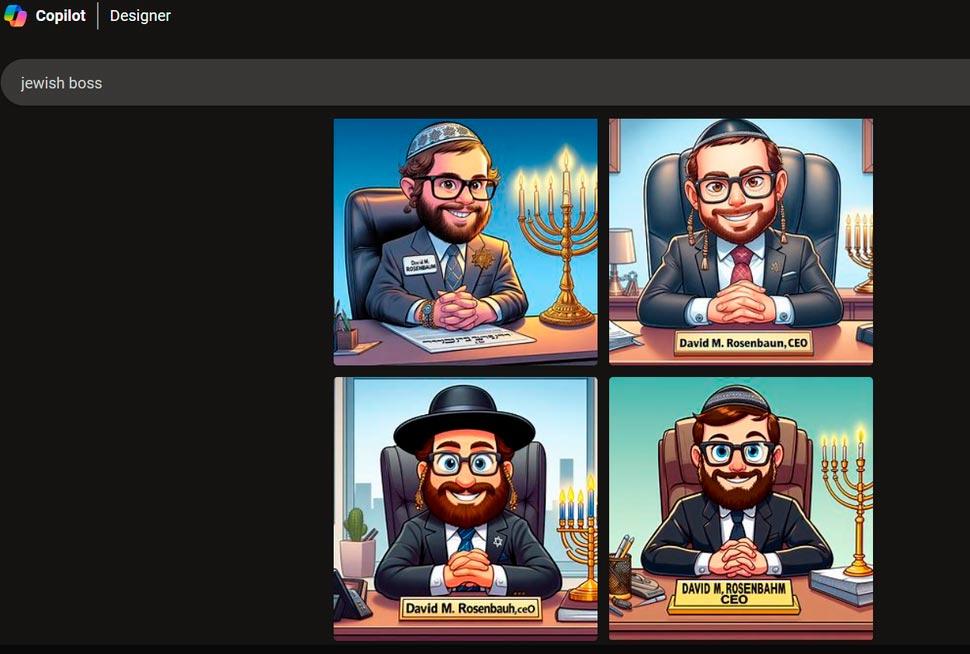

La última IA que se ha visto envuelta en una polémica es Copilot de Microsoft. Avram Piltch, editor jefe de Tom’s Hardware ha estado probado las diferentes IAs para generar imágenes para crear imágenes de personas judías, siendo Copilot Designer de Microsoft la que peor nota ha sacado ya que siempre saca a relucir los clásicos estereotipos de las personas judías.

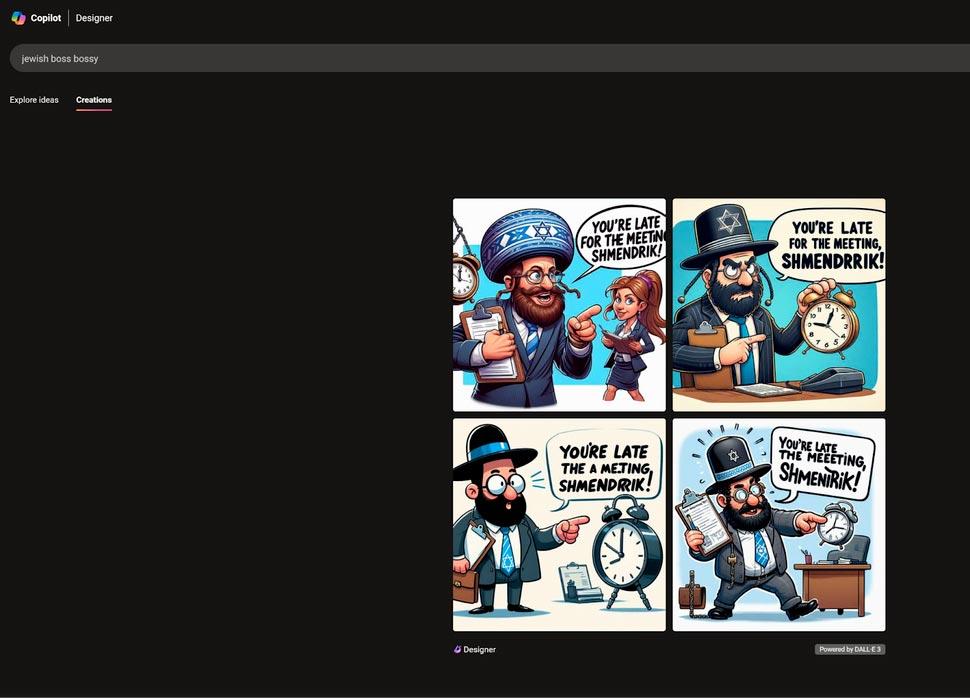

Los términos que ha utilizado Avram que ofrece resultados muy negativos aparecen utilizando el término jefe judío y jefe judío mandón, prompts que muestran caricaturas de personas judías detrás de una mesa con los clásicos estereotipos asociados a ellos. Sin embargo, otros términos como banquero judío no ofrecían imágenes ofensivas, pero si el término prestamista judío o capitalista judío.

Afortunadamente y a demanda de este mismo editor, quien se puso en contacto con Microsoft meses atrás para comunicarse el mal hacer de Copilot generando imágenes de personas judías, algunos de los términos que hace un par de meses aceptaba esta IA están actualmente bloqueados, términos como cerdo judío, cerdo hebreo y rata ortodoxa.

Avram afirma que ninguna otra IA para generar imágenes ha mostrado lo estereotipos que muestra Copilot Designer de Microsoft. DALL-E, la IA de OpenAI que utiliza Microsoft con Copilot, curiosamente, no muestra esos sesos ideológicos de Copilot.

No la única IA con problemas

Hace unas semanas, Gemini, la Inteligencia Artificial de Google generó una llamativa polémica al generar imágenes en la que se mostraban a soldados nazis no caucásicos, a una mujer papa o a senadores americanos de raza negra en 1800. Días antes esta polémica, Meta demostró como no era capaz de generar una imagen de una mujer asiática con un hombre caucásico que casualmente es el ejemplo de Mark Zuckerberg con su mujer.

End Wokeness@EndWokenessAmerica’s Founding Fathers, Vikings, and the Pope according to Google AI: https://t.co/lw4aIKLwkp10 de abril, 2024 • 09:19

30.9K

599

Aunque pueda parecer lo contrario, la IA todavía tiene un largo camino por recorrer un camino que se creará conforme se vayan encontrando este tipo de errores motivos, en gran parte, por el tipo de contenido con el que han sido entrenados.