La High Definition Media Interface se ha convertido en el estándar para la transmisión de vídeo a pantallas de diversos tipos y en varios ámbitos. Dado que se utiliza tanto en el mundo de la informática como en el de la electrónica de consumo. No obstante, en sus dos décadas de existencia y con tal de adaptarse a los nuevos estándares, el HDMI ha sufrido una importante evolución. ¿Cuál es la versión más interesante del HDMI?

El paso de los clásicos televisores de tubo a la llamada alta definición basada en pantallas derivadas de las tecnologías LCD les sirvió a los creadores de contenido multimedia para imponer un tipo de interfaz para la transmisión de información que impidiera la copia no autorizada del contenido. En el caso del vídeo VHS añadieron sistemas anticopia que hacía que el contenido de una cinta a otra no se copiara bien, pero con el DVD y a través del cable de vídeo compuesto era posible copiar el contenido de una película sin problemas.

Preocupados por la incipiente piratería de películas en la red a través de versiones codificadas en formatos como DivX, se terminó optando por la creación de una nueva interfaz de vídeo a la que bautizaron como HDMI, y para su construcción tomaron como referencia el estándar DVI, sin embargo, le añadieron dos mejoras. La primera fue una portadora de audio desde el mismo cable y el segundo el HDCP que se diseñó para impedir la reproducción y copia del contenido para alta definición.

Los inicios del HDMI: versión 1.0 a 1.2

El nacimiento de la versión 1.0 de la interfaz HDMI se produjo en 2003, por aquel entonces los televisores de alta definición, 1280 x 720 píxeles, se contaban con los dedos de las manos. Es más, las primeras consolas de alta definición como tal serían Xbox 360 –y su primer modelo no lo incluía ya que tuvimos que esperar a siguientes revisiones o adquirir adaptadores– y PlayStation 3 no eran más que un proyecto y formatos como el Blu-Ray aparecían en los rumores como noticias. Aun así, en 2006 ya comenzamos a tomar contacto prácticamente todos con ete nuevo estándar completamente digital, dejando atrás los míticos conectos A/V o los SCART/Euroconector de las teles de los 80 y 90.

Las primeras revisiones del HDMI no fueron ampliamente adoptadas por el mercado, al fin y al cabo, todavía no existían los paneles Full HD y otras interfaces de vídeo daban el suficiente ancho de banda como para poder reproducir a 720p y 60 Hz, de ahí que su adopción fuese mucho más tardía. ¿Y qué es lo que la produjo? Pues la aparición del Blu-Ray que vino acompañado de la consola de tercera generación de SONY que requería de una interfaz HDMI para poder transmitir datos por el HDCP.

La evolución del HDMI 1.0 al 1.2 fue la de la siguiente manera:

- La versión 1.1 del estándar HDMI añadió soporte para DVD Audio, lo que permitía transmitir el sonido en los reproductores desde la interfaz y no tener que depender de los cables blanco y rojo del vídeo compuesto o por componentes.

- La versión HDMI 1.2 amplió la capacidad de audio hasta los 8 canales. De esta hubo una versión mejorada que fue la 1.2a y que añadía el llamado CEC o Control Electrónico del Consumidor. El cual permite controlar el volumen y ciertas opciones de imagen a partir de un mismo mando de control.

El HDMI 1.3 a 1.4b, la evolución con DSC

En pleno 2006 el HDMI aún no había sido adoptado a gran escala en el ámbito de la electrónica de consumo, pero la adopción de las pantallas LCD había unificado por fin dos mundos que habían estado durante décadas separados: el de los monitores para PC y los televisores. A partir de ese momento, y hasta el día de hoy, ambos compartirían buena parte de las tecnologías y pasó a ser necesario adoptar resoluciones y tasas de frecuencia más altas.

¿El primer cambio importante en la primera evolución del HDMI? Un aumento en el ancho de banda que fue de los 3,96 Gbits por segundo de velocidad de transferencia a los 8,96 Gbits por segundo. Esto le permitía llegar hasta una resolución de 2560 x 1440 píxeles con una tasa de 144 Hz. Ambas, imposibles en los televisores de aquel entonces., pero que estaban claramente dentro de las necesidades de los monitores para PC.

La gran novedad fue la tecnología compresión DSC, que se basa en que la interfaz de salida HDMI comprime la información RGB de cada píxel. Lo que le permitió llegar incluso a resoluciones 2160 o 4K en ciertas condiciones. La interfaz tuvo una versión mejorada en forma de la 1.4b, que aumentó el ancho de banda hasta los 10,2 Gbits por segundo, permitiendo resoluciones más altas. Así que con cada pequeño paso que daba el estándar, más cerca estábamos de entrar en la era del 4K/UHD.

HDMI 2.0: llega el soporte para 4K

El salto del Full HD a los 4K era tan importante con respecto a la calidad de imagen como el que hubo de PAL o NTSC a resoluciones HD, claro está que cuatro veces más píxeles requieren cuatro veces más información a transmitir. Por eso a finales de 2013 el consorcio de empresas que dictan los estándares del HDMI y lo consensúan entre ellas decidieron crear la versión 2.0 del estándar, la cual en su versión inicial llegaba a los 18 Gbps y, por tanto, se consiguió que en algunas resoluciones previamente establecidas no se necesitará el uso de la compresión DSC, la cual empeoraba la calidad de imagen.

Aunque sus grandes novedades no solo tuvieron que ver con la implementación de un mayor ancho de banda y resoluciones, sino con elementos como el soporte HDR, a través de la versión 2.0a, soporte para audio 7.1 con calidad de muestreo de 192 KHz por canal, el soporte para monitores panorámicos con relación de aspecto 21:9 y la sincronización de vídeo y audio para la emisión en de vídeo a través de internet, pensado para plataformas como Netflix y HBO que por aquel momento empezaban a despuntar.

La versión 2.0 también supuso la implementación de un HDCP mejorado, el cual es clave para la reproducción de las películas en UHD Blu-Ray, así como de cierto contenido transmitido a través de internet.

HDMI 2.1, ¿el final del camino?

El último estándar HDMI es el 2.1, el cual permite visualizar vídeo a resolución 8K, aunque solo a 30 Hz. En todo caso su mayor baza es el aumento de su ancho de banda, que sufrió un aumento hasta los 48 Gbps, siendo el aumento más importante en la evolución del HDMI y que le permite soportar una gran cantidad de resoluciones sin compresión DSC por el medio.

En realidad se trata de una versión mejorada del HDMI 2.0. Dado que fuera del ancho de banda no aporta novedades adicionales, pero este ha sido lo suficientemente grande como para asegurarse su continuidad durante muchos años sin que aparezcan versiones menores mejoradas, lo cual fue algo que afectó a la evolución de los HDMI 1.X, donde rápidamente los monitores y dispositivos de vídeo se quedaban desfasados.

Por lo que por el momento no se espera una versión mejorada, ya que el HDMI 2.1 cumple de sobra para ofrecer soporte sin necesidad de una actualización inminente bastantes años en adelante. Ahora bien, ¿qué ocurre si conectamos dos dispositivos de distinta generación?

Realmente no va a ocurrir nada, simplemente que la transferencia de vídeo se adaptará al ancho de banda de la parte menos rápida. Esto ayuda a que todos los dispositivos HDMI sean compatibles hacia adelante, aunque por ejemplo tu consola Full HD no reproducirá a 4K por utilizar una interfaz con la versión 2.1 del estándar. Esto es gracias a que en todas las versiones las forma, la distribución y funcionalidad de los pines ha sido siempre la misma.

Por lo que a la hora de comprar un cable, asegúrate que este está certificado para su uso en la versión de la interfaz HDMI que necesitas. Esto significa que para las versiones más nuevas tendrás que comprar cables nuevos si los que tenías estaban pensados para generaciones anteriores de la interfaz. Pero nunca al revés.

Debido a todo esto una nueva versión se hace difícil, además, DisplayPort está ocupando muchas de las nuevas conexiones de dispositivos, por lo que podría llegar a sustituir al famoso HDMI en poco tiempo, sobre todo con la llegada de los 16 K con SDR a 60 Hz, para el cual ya estaría preparado. En este caso, estamos más cerca de una desaparición que de una adaptación del estándar a esas necesidades toda vez que ya existe una tecnología capaz de dar soporte a esos nuevos tamaños de pantalla y, por tanto, a la cantidad de información necesaria para transmitir.

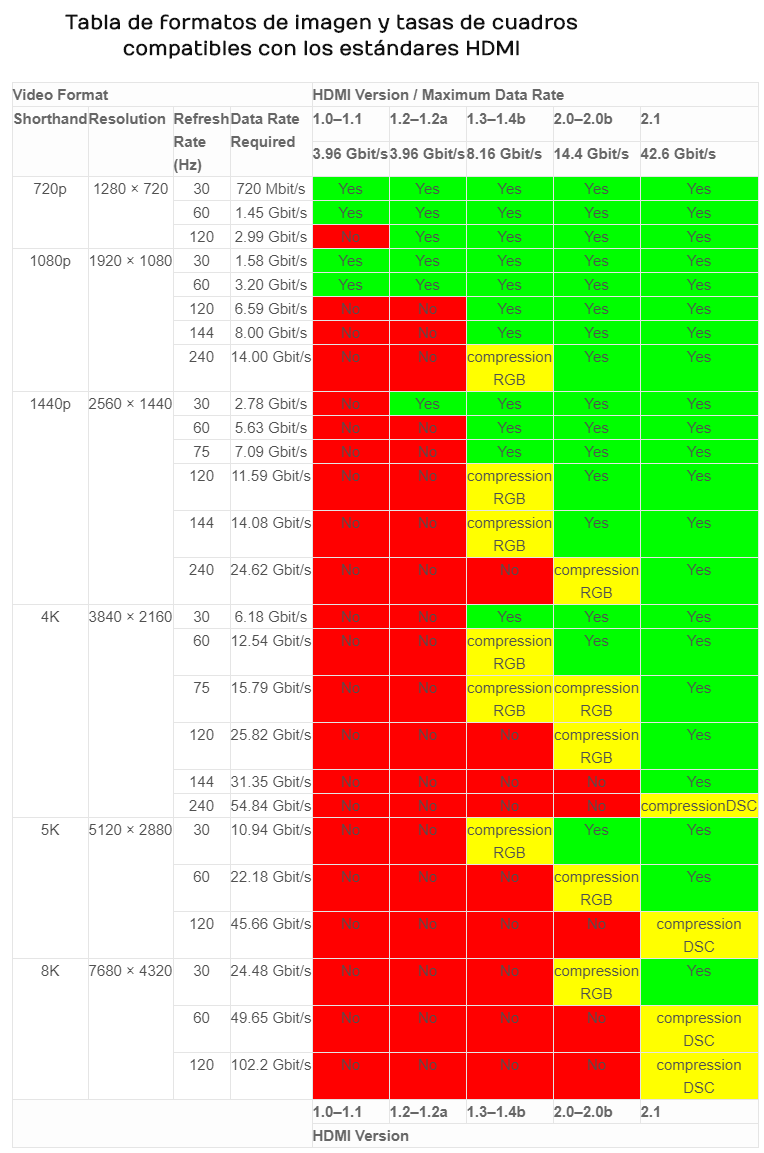

HDMI soportada por cada generación

Para finalizar os dejamos esta tabla que tenéis justo aquí debajo, para que podáis conocer qué resoluciones y tasas de refresco soportan las diferentes generaciones de la interfaz HDMI. Con ello podréis observar su evolución durante sus dos décadas de vida en cifras y saber qué resoluciones soporta un monitor según la versión de esta interfaz de vídeo que se le haya implementado, tanto a la tarjeta gráfica de tu PC como al monitor a la que está conectada.

Dependiendo de la consola, ordenador o aparato que queráis conectar a un monitor o Smart TV así tendréis que instalar un cable compatible con cada estándar porque no todos valen indistintamente en cada caso. Es por eso que cuando vayáis a una tienda tendréis que confirmar que ese componente puede funcionar para resoluciones 4K o, si tienes una pantalla con más resolución, incluso 8K. Y como siempre ocurre, esa compatibilidad sí funciona de arriba abajo, desde los cables que más pueden hacia los que menos y no al revés. Por ejemplo, el viejo cable de vuestra PS3 de hace 15 años, por desgracia, poco rendimiento os va a ofrecer con PS5 enchufada en una tele UHD y si lo intentáis conectar, lo más seguro es que provoque errores que, si no estáis atentos, podríais achacar a otras causas.