NVIDIA ha revolucionado el mundo de los monitores y videojuegos con una tecnología tan simple como costosa. Hablamos de G-SYNC, una tecnología que vuelve a estar en boca de todos, pero que realmente un numero muy pequeño de usuarios conoce a fondo. Debido a esto, vamos a explicar en profundidad y mediante sus características, qué es y cómo funciona realmente.

Antes de la llegada de G-SYNC en su primera versión allá por el 2013, los jugadores solo tenían tres opciones (en el mejor de los casos) para combatir los problemas típicos del gamer medio: stutter, flicker y tearing.

Estos inconvenientes tan típicos y conocidos por todos solo se podían solucionar mediante el famoso V-SYNC y más tarde y solo en parte con Fast-SYNC, lo cual entrañaba una serie de problemas adyacentes como un mayor retraso de la entrada, algo que tampoco era del agrado de los jugadores.

G-SYNC llegó para terminar con los problemas de un plumazo

NVIDIA G-SYNC ha sido la solución real a todos los problemas que ha suscitado hasta ahora el jugar en PC. Es un tipo de tecnología de visualización que se utiliza tanto en monitores, como en portátiles como en algunas televisiones, de manera que elimina por completo tearing, stuttering y flickering.

El único requisito es disponer de una tarjeta gráfica compatible (a partir de la serie 600, mínimo 650 Ti o superior) donde esta deberá estar conectada mediante DisplayPort (necesita como mínimo la versión 1.2).

En cuanto a drivers, G-SYNC es compatible desde los 340.52 y posteriores, por lo que a día de hoy no tendremos ningún problema en este punto.

Cómo funciona G-SYNC

La tecnología de NVIDIA parte de una base muy simple: lograr una perfecta sincronización entre la frecuencia con la que la tarjeta gráfica envía frames y la frecuencia con la que el monitor puede representarlos en pantalla, la llamada tasa de refresco o actualización del monitor. Pero para comprender esto hay que entender que con G-SYNC ahora es el monitor el que se sincroniza y espera a la GPU y no al revés, lo cual es un detalle que no se suele tener en cuenta, pero que es tremendamente importante.

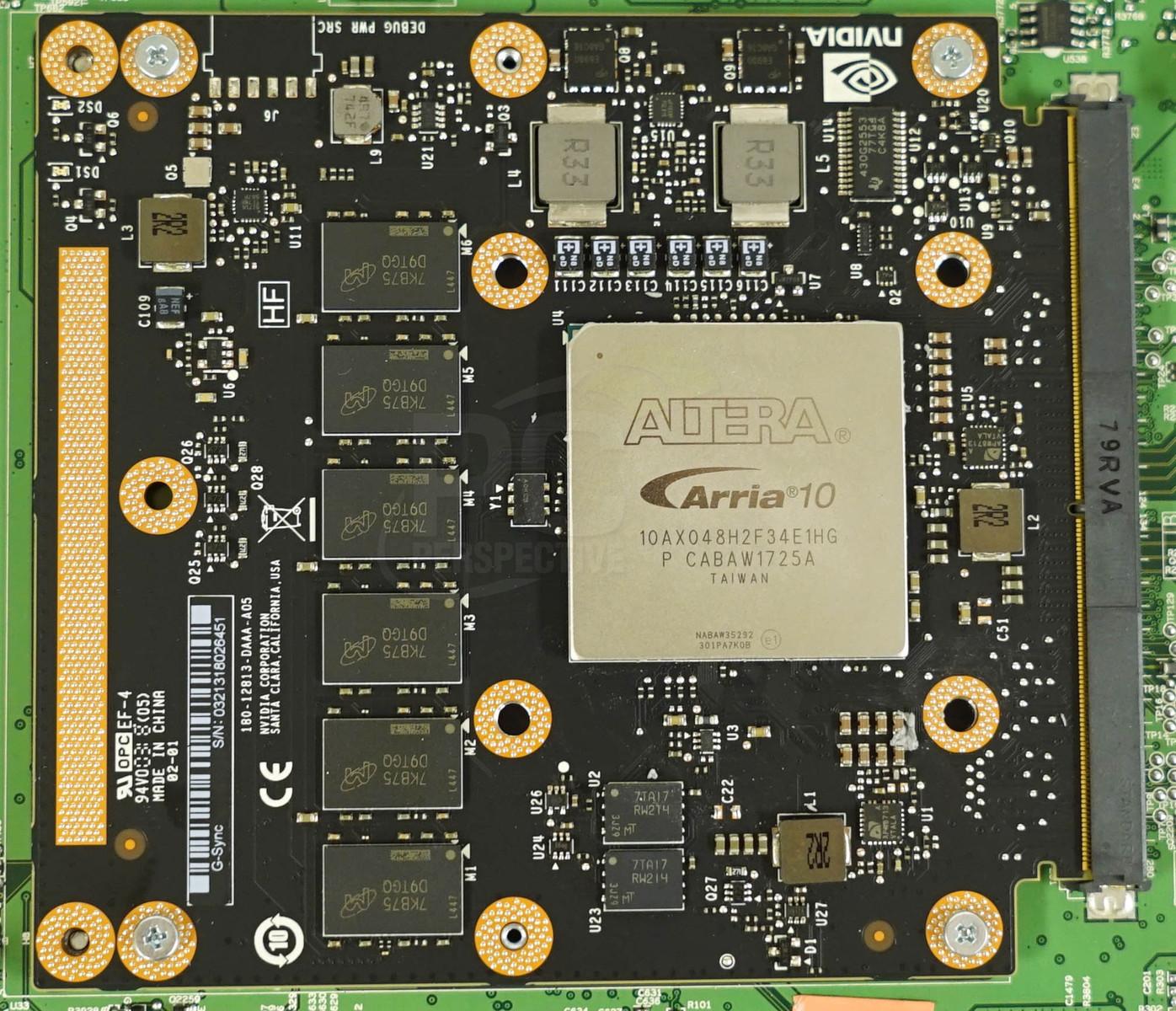

Para ello, NVIDIA incluye un módulo físico instalado en cada monitor que lleve su certificado. Este módulo lo que permite es una frecuencia de actualización variable, conocida actualmente como VRR, y es el encargado de lograr dicha sincronización entre ambos componentes.

El rango de frecuencias se establece desde 30 Hz hasta la tasa máxima soportada por el panel, por lo tanto, cada monitor tiene un rango máximo diferente. Pero ¿qué se consigue con esto? Se logra una sincronización perfecta que permite mostrar las imágenes justo cuando la tarjeta gráfica las procesa, por lo tanto, el monitor no espera a la tarjeta gráfica y ésta puede seguir rindiendo al mismo nivel.

Inconvenientes de esta tecnología

Básicamente solo uno: encarece en exceso el precio final del monitor, lo que ha favorecido el auge de una tecnología rival y parecida en parte y fundamentos como es FreeSync.

Y es que ha habido casos del mismo monitor a distinto precio debido al añadido de G-SYNC, donde la diferencia ha podido ser de más de 200 dólares, lo cual es un precio que hay que tener en cuenta. Muchos jugadores profesionales, acostumbrados a jugar sin V-SYNC afirman que G-SYNC introduce input lag y aunque esto es cierto en parte, la diferencia de rendimiento es de apenas un par de milisegundos.

El problema es que este tipo de jugadores no juegan con la suavidad que consigue G-SYNC, por lo que van «a saltos», mínimos es cierto, pero existentes, por lo que este input lag ínfimo es percibido como input lag común. Una vez que un jugador se habitúa a G-SYNC no quiere volver a otra cosa, sobre todo si el juego al que está jugando está realmente bien programado.